NATURAL PLAN:LLMs在自然语言规划上的基准

一、结论写在前面

论文来自Google DeepMind。

论文标题:NATURAL PLAN: Benchmarking LLMs on Natural Language Planning

论文链接:https://arxiv.org/pdf/2406.04520

论文提出了NATURAL PLAN,一个包含三个关键任务(旅行规划、会议规划和日历调度)的自然语言现实规划基准。论文的评估重点在于LLMs在完全了解任务情况下的规划能力,通过提供来自Google Flights、Google Maps和Google Calendar等工具的输出作为模型的上下文。

这消除了在规划方面评估LLMs时对工具使用环境的需要。论文观察到,NATURAL PLAN对当前最先进模型来说是一个挑战。例如,在旅行规划任务中,GPT-4和Gemini 1.5 Pro分别仅能达到31.1%和34.8%的解决率。论文发现,随着问题复杂度的增加,模型性能急剧下降:当涉及10个城市时,所有模型的表现均低于5%,凸显了当前最先进LLMs在自然语言规划方面存在显著差距。

论文还对NATURAL PLAN进行了广泛的消融研究,进一步揭示了自校正、少样本泛化以及长上下文情境下的规划等方法在提升LLM规划效果上的(不)有效性。

二、论文的简单介绍

2.1 论文的背景

LLM的规划能力仍远落后于人类表现。尽管许多近期工作旨在解决这一问题,但没有反映真实世界应用的现实基准,难以在增强这些模型的规划能力方面取得有意义的进展。

规划在机器人学和具身环境中已被广泛研究。自动化规划算法已被广泛应用于此类系统中,以实现规划功能。在这些场景中,规划涉及制定一系列行动,当执行这些行动时,可以将代理从一个特定的初始状态带到期望的世界状态。这些系统通常使用规划域描述语言(PDDL)或答案集编程(ASP)作为规划器的底层动作语言。尽管最近的工作已经探索了LLM驱动的代理在经典规划设置中的潜力,但规划场景并非实际设置,并且它们通常包含模板,而非自然语言。

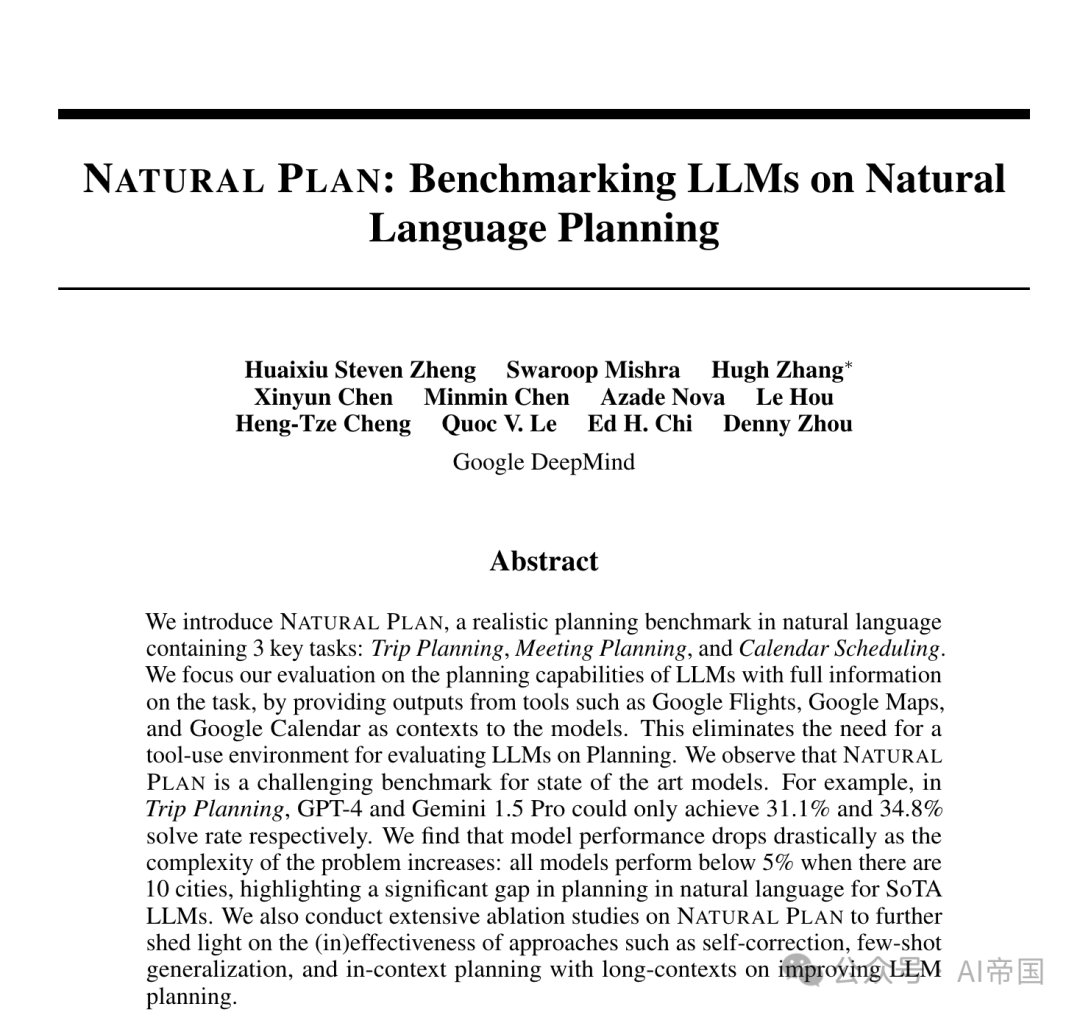

图1:旅行规划任务的示例

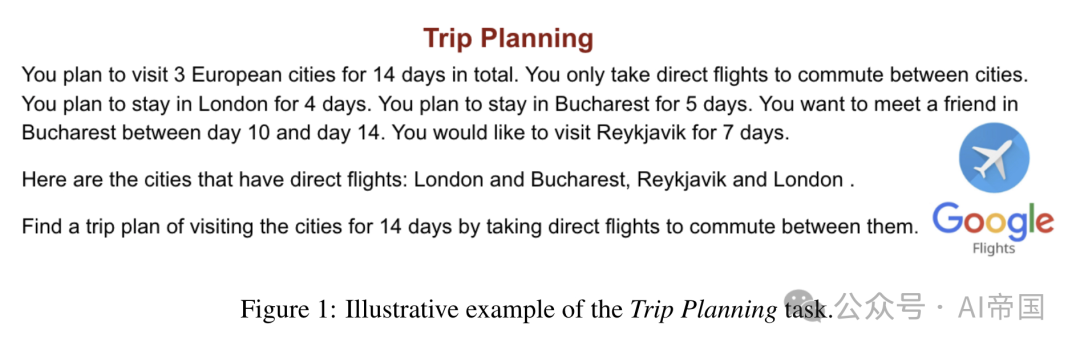

图2:会议规划任务的示例

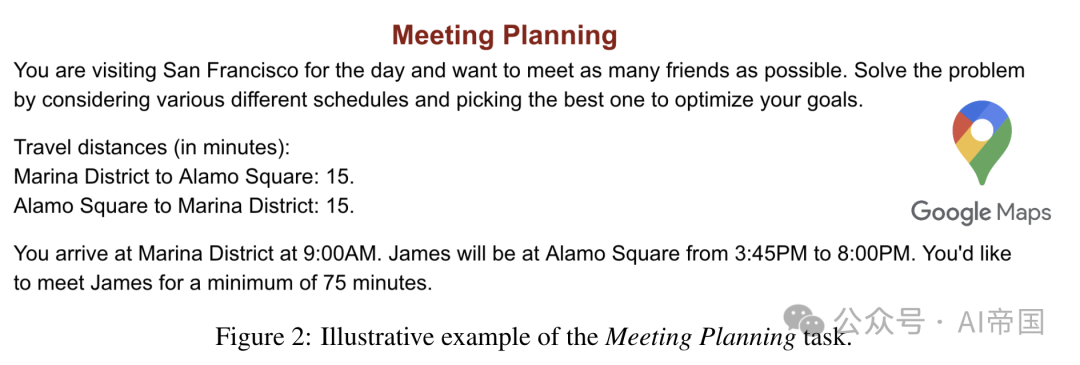

图3:日历安排任务的示例

论文引入了NATURAL PLAN,这是一个专为评估大型语言模型(LLMs)处理自然语言描述的规划任务能力而设计的新基准。NATURAL PLAN包含三种不同的规划任务,即旅行规划、会议规划和日历调度。对于每项任务,论文从现有工具中收集真实信息。例如,在旅行规划中,论文查询Google Flights API,并提供城市间的航班连接信息作为上下文。图1至图3展示了这些任务及其相关的谷歌工具,这些工具提供的信息作为上下文。

2.2 论文的方法--NATURAL PLAN

NATURAL PLAN是一个旨在评估LLMs执行自然语言表达的规划任务能力的基准。

2.2.1 数据集类别

NATURAL PLAN包含三个规划类别:旅行规划、会议规划和日历调度。每个类别旨在捕捉涉及某些工具(如Google Flights)的真实世界规划任务。论文将工具使用与推理任务分离,并在上下文中提供工具输出,以确保NATURAL PLAN专注于规划。论文相信这将显著简化评估LLMs规划过程的复杂性。

2.2.1.1 旅行规划

旅行规划是一项任务,专注于在给定约束条件下规划旅行行程。附录A展示了一个示例提示及其解决方案。该任务是关于确定访问 个城市的顺序。论文添加足够的约束条件,使得任务只有一个解决方案,从而使得对预测的评估变得直接。

个城市的顺序。论文添加足够的约束条件,使得任务只有一个解决方案,从而使得对预测的评估变得直接。

2.2.1.2 会议安排

本部分基准专注于在各种给定约束下安排会议。给定 个朋友,该任务提供了会议时间和地点。附录A展示了一个示例问题。目标是在给定的约束条件下,尽可能多地与朋友见面,这些约束包括地点之间的旅行时间。

个朋友,该任务提供了会议时间和地点。附录A展示了一个示例问题。目标是在给定的约束条件下,尽可能多地与朋友见面,这些约束包括地点之间的旅行时间。

2.2.1.3 日历调度

日历调度是一项任务,专注于在多人之间根据现有日程和各种约束条件安排工作会面。论文通过改变参与会议的人数和工作的天数来调整任务难度。附录A展示了一个示例问题。

2.2.2 数据集构建

论文通过使用相应的工具数据并创建各种约束条件,人工合成了NATURAL PLAN数据集。下面描述了每类任务的具体创建过程。

2.2.2.1 旅行规划

论文创建数据集的方式如下:为了创建一个问题,论文从欧洲访问量最大的48个城市中随机抽取

个城市。论文还随机抽取总持续时间和在每个城市停留的天数,设为 。论文在行程中添加约束条件,要求在特定日期访问某些城市,例如在旅行中的第3天到第5天在巴黎与朋友见面。作为一个全局约束,论文增加了只使用直飞航班在城市间通行的偏好,排除了如果没有从

。论文在行程中添加约束条件,要求在特定日期访问某些城市,例如在旅行中的第3天到第5天在巴黎与朋友见面。作为一个全局约束,论文增加了只使用直飞航班在城市间通行的偏好,排除了如果没有从 到

到 的直飞航班,就不能在访问

的直飞航班,就不能在访问 后访问

后访问 的可能性。为了帮助LLM理解连通性约束,论文查询Google Flights API,并在上下文中提供城市之间的航班连通性信息。

的可能性。为了帮助LLM理解连通性约束,论文查询Google Flights API,并在上下文中提供城市之间的航班连通性信息。

2.2.2.2 会议规划

对于此数据集类别,论文随机抽样人员姓名以安排会议,并相应地抽样地点。论文还抽样时间框架,显示人员的可用性。论文增加了约束条件,例如您将在旧金山访问一天。在此设置中,目标是要尽可能多地会见朋友。为了使问题更加真实,时间约束/地点遵循现实世界的地点。旅行距离通过查询Google地图API的驾驶时间来估算。

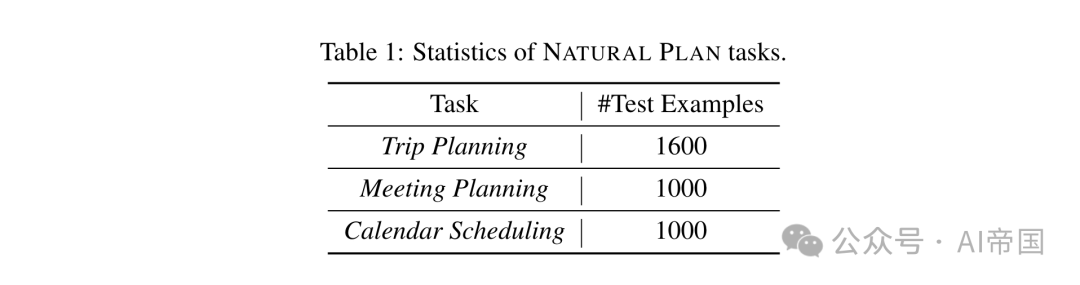

表1:NATURAL PLAN任务的统计数据

2.2.2.3 日历调度

数据集的这一部分包括在多个工作日中安排30分钟或1小时会议的任务,涉及不同数量的与会者。论文实例化了两个子集:第一个子集固定会议在特定的一天,例如星期一,同时变化与会者的数量在[2, 7]之间;第二个子集固定与会者数量为2,同时变化会议可以安排的工作日数量为1, 5。每个参与会议的人都有他们当天的现有会议安排(第一个子集)或一周(第二个子集),这是通过向每天添加随机的30分钟会议直到n小时的会议时间被填满来创建的。

论文随机为每个与会者分配n,以确保一半的与会者有繁忙的日程,意味着他们超过一半的工作时间用于会议,而另一半有较轻的日程,不到一半的工作时间用于会议。每个与会者的连续会议被合并成一个单独的块,如图3所示。一旦论文有了所有与会者的现有日程,论文添加两种类型的约束:1) 最早可用性;2) 避免在特定时间段内开会,以确保问题有一个单一的解决方案。

2.2.3 统计数据

表1展示了NATURAL PLAN中涉及的行程规划、会议规划和日历调度等多个任务的统计数据。

2.3 论文的效果

论文进行了一系列实验,以评估当前最先进的语言模型(LMs)在NATURAL PLAN中规划任务的表现。

2.3.1 模型

论文实验了多个顶尖的LLMs:GPT-4(gpt-4-turbo-2024-04-09),GPT-3.5(gpt-3.5-turbo-0125),GPT-4o(gpt-4o-2024-05-13),以及Gemini 1.5 Flash和Pro 。

2.3.2 设置

少量示例学习 对于NATURAL PLAN中的每个任务,论文提供5个同一任务内的示例作为少量示例,以使LLM通过上下文学习[Brown et al., 2020]从这些示例中学习。此设置还确保输出可以轻松解析以进行评分。

约束复杂性理解 为了更好地理解LLMs的规划能力,论文通过控制变量改变每个任务的难度级别。论文通过改变约束条件(如人数、城市数、天数等)进行分析,以更好地理解模型在规划任务复杂性变化中的行为。

少量示例泛化 论文通过分别提供简单和困难示例作为上下文示例,进行由易到难和由难到易的泛化研究。例如,在行程规划中,对于由易到难(由难到易)的泛化,论文提供5个比评估任务实例少(多)2个城市更简单(困难)的示例。

自我修正 论文评估模型是否能在NATURAL PLAN中各种任务类别中自我修正其错误。论文提示模型识别是否存在任何错误,并在必要时进行自我修正。

长上下文中的上下文规划 论文评估模型如何利用长上下文能力进行规划中的上下文学习。论文将测试集分为80%和20%,其中80%用作上下文示例,同时论文在20%的测试集上评估模型性能。论文将使用的少量示例数量增加到800个。

评估 论文解析LLM的输出,并与黄金计划进行比较。论文计算LLM生成的计划与黄金计划完全匹配(EM)的分数。

2.3.3 结果与分析

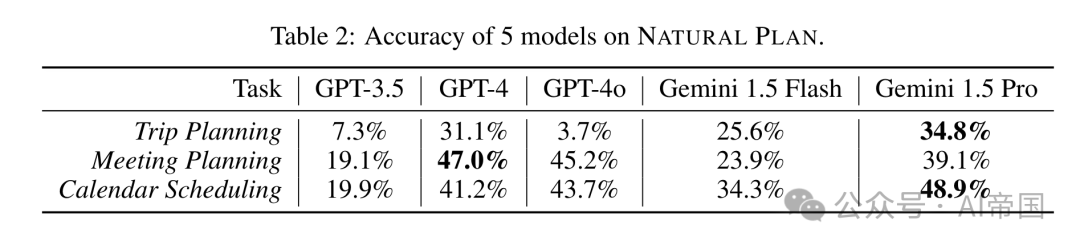

表2:5种模型在NATURAL PLAN上的准确性

2.3.3.1 结果

表2展示了在5次尝试设置中,各种LLM在NATURAL PLAN任务中的表现。论文从结果中得出以下见解。

所有模型在NATURAL PLAN上的表现都不佳。Gemini 1.5 Pro在旅行规划和日历调度上表现最佳,而GPT-4在会议规划上表现最佳。

在旅行规划中,Gemini 1.5 Pro达到34.8%的准确性,而GPT-4为31.1%。特别是,论文观察到GPT-4o仅为3.7%。进一步分析显示,GPT-4o在理解和遵守航班连接和旅行日期限制方面遇到困难,更多详细分析见附录D。在会议规划上,GPT-4和GPT-4o分别达到47%和45.29%的准确性,而Gemini 1.5 Pro为39.1%。对于日历调度,Gemini 1.5 Pro以48.9%的准确性超过了GPT-4和GPT-4o。

在NATURAL PLAN的三个任务中,旅行计划是其中最难的,最佳准确率仅为34.8%。值得注意的是,所有模型在这三个任务上的准确率均未超过50%,这表明即使所有必要的工具使用信息都已在上下文中提供,自然语言规划对于最先进模型来说仍然是一个极具挑战性的任务。

2.3.3.2 约束复杂性

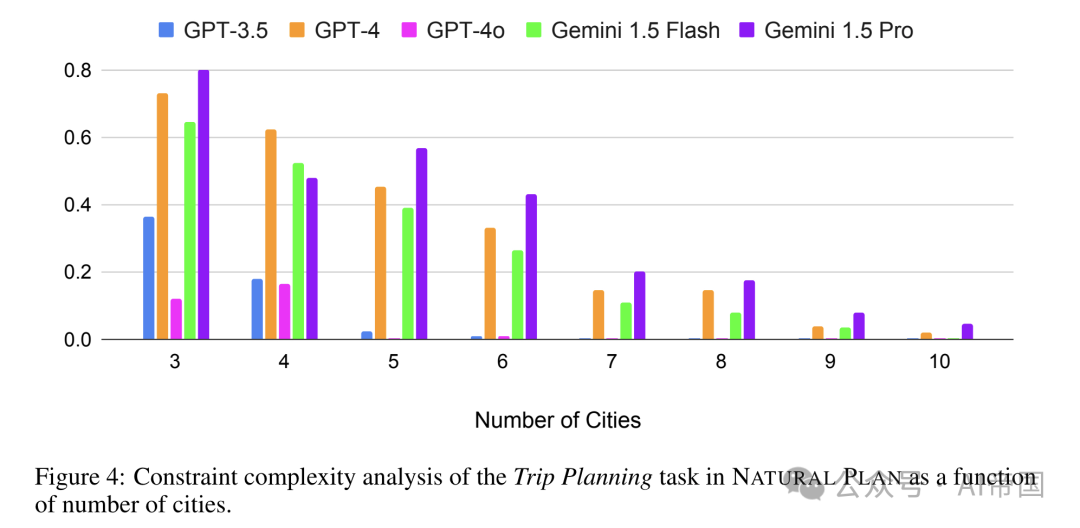

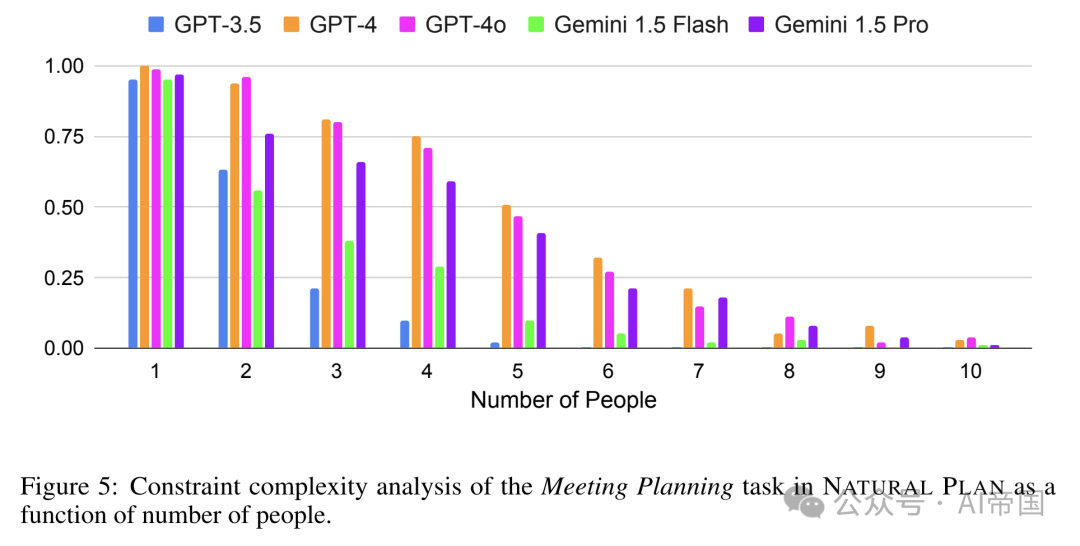

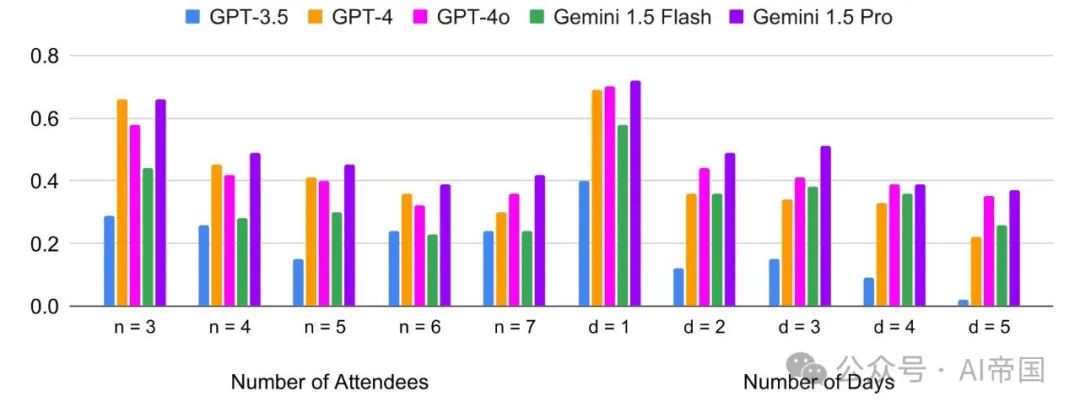

图4至图6展示了模型在旅行计划中城市数量、会议安排中人数、日历安排中参与者和天数变化下的性能变化。论文观察到以下关键见解:

图5:NATURAL PLAN中会议规划任务的约束复杂性分析,作为人数的函数

图6:日历调度任务的约束复杂性分析,作为一天内涉及的人数(左)和两个与会者之间选择会议时间的工作日数量(右)的函数

随着城市/人数/与会者/天数的增加,性能下降。对于旅行规划,图4显示,当规划中涉及更多城市时,模型开始失败。在旅行规划中,所有五个模型在涉及10个城市时,性能都低于5%。对于会议规划,论文评估了从1到10的人数场景。图S再次显示,随着需要会见的人数增加,性能急剧下降。超过8人后,所有模型的得分都低于10%。对于日历调度,与其他两个任务相比,增加与会者或天数时,准确性的下降并不显著。

2.3.3.3 泛化分析

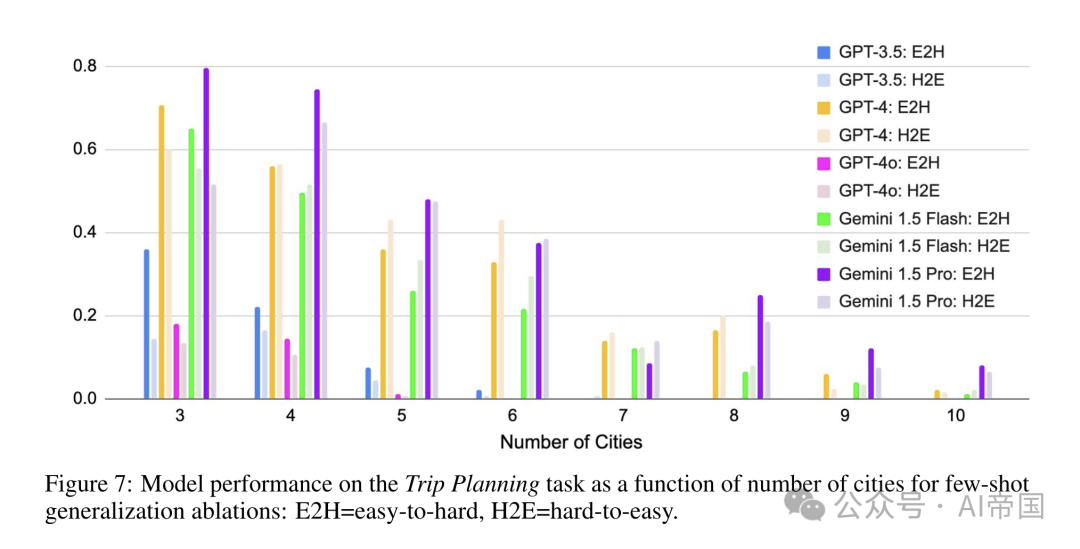

图7:模型在旅行规划任务上的性能,作为城市数量对少数镜头泛化消融的影响函数:E2H=从易到难,H2E=从难到易

图7展示了论文对从易到难和从难到易泛化实验的总结。对于从易到难(从难到易)泛化,论文提供了5个更简单(更难)的例子,这些例子比任务少2个(多2个)城市,以测试大型语言模型(LLMs)是否能从更简单(更难)的上下文学习示例中泛化。论文选择旅行规划任务来进行消融研究,因为它是自然规划任务中最困难的任务。

总体而言,论文观察到从易到难的泛化效果优于从难到易的泛化,跨越了不同的模型家族。第4.2节显示,当任务复杂度较高时,模型的表现更差。这一结果表明,即使是对于最先进的LLMs,理解和利用上下文学习中的困难示例仍然具有挑战性。然而,论文确实观察到,对于GPT-4和Gemini 1.5 Flash,随着任务复杂度的增加,趋势发生了逆转:对于

到8,从难到易的示例比从易到难的示例表现更好。

到8,从难到易的示例比从易到难的示例表现更好。

2.3.3.4 自我修正

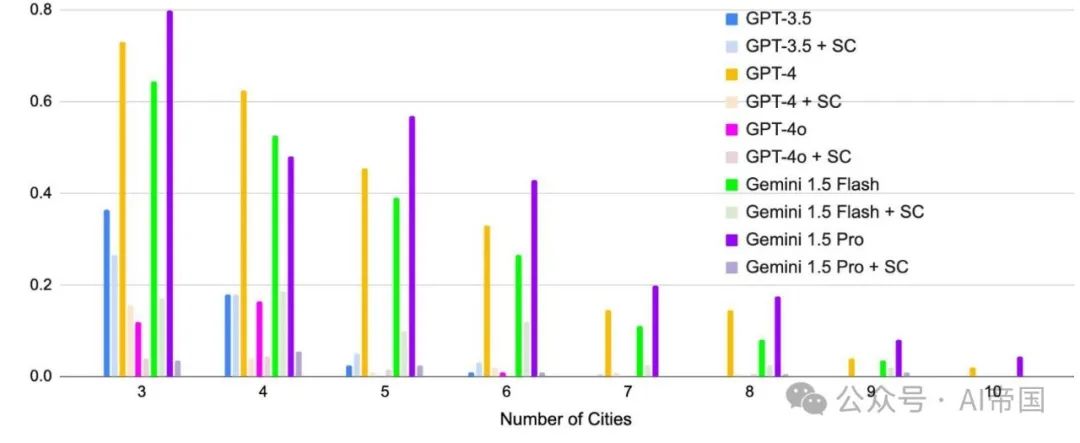

图8:自我修正消融实验中,行程规划准确率随城市数量的变化。SC=自我修正

图8展示了在行程规划任务中对模型预测进行自我修正的结果。论文提示大型语言模型(LLM)检查生成的计划是否正确,如果判定为不正确,则修正计划(见附录B中的提示)。

自我修正导致所有模型性能显著下降。有趣的是,如GPT-4和Gemini 1.5 Pro这样的更强模型相比GPT-3.5遭受了更大的损失。如GPT-4和Gemini 1.5 Pro这样的更强模型相比GPT-3.5遭受了更大的损失。这与先前发现自我修正可能导致推理任务性能下降的研究结果一致[Huang et al., 2023]。像GPT-4和Gemini 1.5 Pro这样的经过指令调优的强模型可能在被提示时对自己的解决方案过于自信,自我修正的示例见附录E。

2.3.3.5 长上下文情景下的即时规划

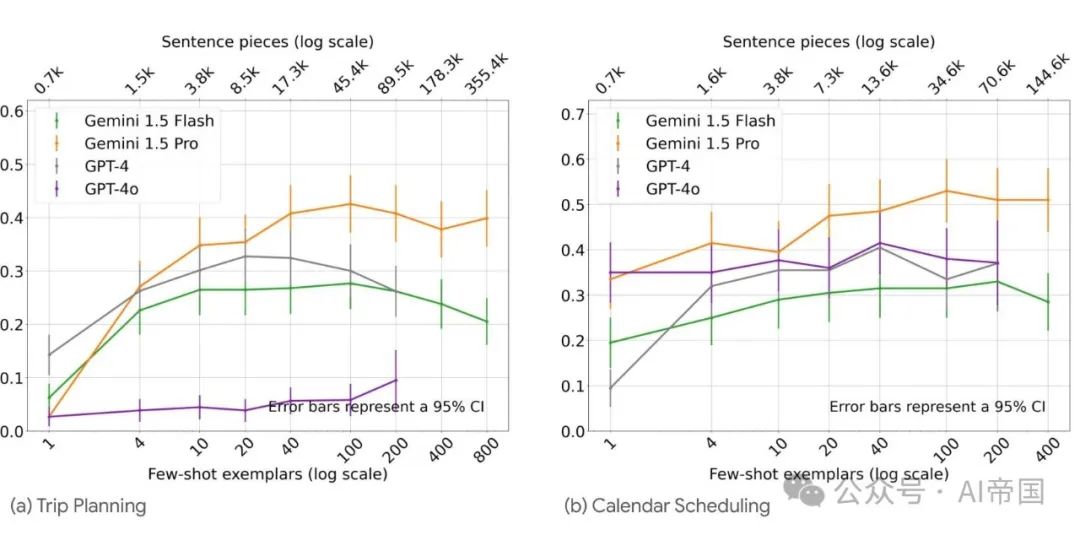

图9 展示了在旅行规划和日历调度任务中利用长上下文进行情境规划的情况。Gemini 1.5 Pro在规划任务上展现出强大的长上下文学习能力,相较于其他模型表现更优

论文研究了通过利用近期模型的长上下文能力进行情境规划的可能性。图9展示了四种模型在最多800个示例下的性能。

由于强大的长上下文能力,Gemini Pro 1.5能够利用多达35.5万个上下文示例,并持续显示出稳定的改进。例如,在旅行规划中,将示例数量从1增加到800,Gemini Pro 1.5的准确率从2.7%提升至39.9%。与此同时,GPT-4和Gemini 1.5 Flash在20个示例时达到性能峰值,并开始出现性能下降。在日历调度任务中,Gemini 1.5 Pro持续改进至400个示例。这些结果展示了情境规划的潜力,其中长上下文能力使得大型语言模型能够利用更广泛的上下文来提升规划能力。

本文转载自 AI帝国,作者: 无影寺