谷歌推出V2A,可为视频大模型自动匹配语音

谷歌Deepmind在官网推出了视频转音频模型V2A。

用户可以用视频+文本提示的方式,通过V2A为视频模型自动匹配语音。例如,为紧张、恐怖、惊悚的片段自动匹配语音,可以进一步节省制作时间和提高效率。同时可以与谷歌的视频模型Veo相结合使用。

目前,Sora、可灵、Gen-3、Dream Machine等知名模型生成的视频没有任何声音,用户如果想使用这些视频还需要二次加工配音。

但在嘴型、音轨匹配方面就比较麻烦,而V2A可以生成无限数量的音轨,用户可以根据实际需求来选择最贴近的内容。

例如,为一个骑马的牛仔视频配上音乐,提示词,草原上夕阳西下时,悠扬柔和的口琴声响起。

水下游动的水母、海洋生物、海洋

电影、惊悚片、恐怖片、音乐、紧张、氛围、混凝土上的脚步声

音乐会舞台上的鼓手,周围是闪烁的灯光和欢呼的人群。

一只狼对着月亮嚎叫

下面这个视频短片的人物嘴型,就通过AI语音进行了精准匹配。

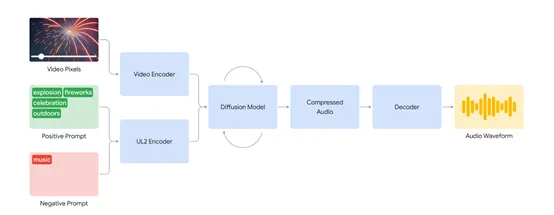

模型架构方面,V2A首先将视频和音频提示输入编码,生成初始的压缩表示。然后,通过迭代的方式,扩散模型不断优化音频,从而使其与视觉信息和文本提示同步。

这一步骤确保生成的音频不仅具有高逼真度,还能准确反映视频中的场景和动作。最后,生成的音频被解码,转换为音频波形,并与视频数据结合。

为了提高音频质量并增加对特定声音生成的控制,V2A技术在训练过程中加入了多种训练数据,包括AI生成的详细音频描述和对话的转录。

通过这些额外的注释,V2A系统能够学习将特定的音频事件与各种视觉场景关联起来,并根据提供的注释或转录做出响应。

使得V2A技术在处理视频像素和生成音频时,不需要手动调整生成的声音与视频的对齐,从而避免了繁琐的声音、视觉和时间元素的调整,为生成逼真的音效奠定了坚实的基础。

此外,V2A在改进频中语音的口型同步方面进行了大量优化,会从视频输入和文字转录中抽取信息,生成初步的音频表示并通过扩散模型不断细化。

为了进一步提升口型同步的准确性,V2A在训练过程中加入了更多的信息,包括AI生成的详细音频描述和对话转录。可帮助V2A能够学习将特定的音频事件与各种视觉场景关联起来,并根据提供的注释或转录做出响应。这不仅改善了语音与口型的同步,还提高了整体音频生成的质量。

本文转自 AIGC开放社区 ,作者: AIGC开放社区