无需RLHF? 基于图增强的大模型可控生成框架

引言

可控文本生成(Controlled Text Generation, CTG)是大语言模型(Large Language Models, LLMs)文本生成的一个重要研究领域,旨在创造出符合特定标准或属性的文本。这包括调整文本的情绪倾向、确保内容安全性、或满足具体主题要求等。

目前 CTG 实现的主流方式是结合有监督微调(Supervised Fine-Tuning, SFT)和人类反馈强化学习(Reinforcement Learning from Human Feedback, RLHF)的范式,通过直接改变模型参数以适应特定的输出要求。但 SFT+RLHF 范式通常要求对基座模型进行专门的微调,限制了其在不同模型间的迁移能力。

另一种策略是在解码阶段调整概率,这种策略提供了更高的灵活性,允许在不修改模型本身的前提下控制文本的生成,使其可广泛应用于各种 LLMs。已有尝试利用小型语言模型来影响大模型的解码过程,从而控制输出文本的特定条件。

但是,这种外部控制可能会影响文本的质量,使其失去自然性和流畅性。近期研究 Air-decoding 指出,过度控制解码过程可能会损害文本的自然性和流畅性,导致生成文本的质量下降。

因此,CTG 的一个关键挑战是,如何在保持文本流畅性的同时,有效地实现对生成文本的控制。这需要一种能够在不影响 LLMs 固有生成能力的前提下,对文本的特定属性进行精确控制的方法。

论文标题:Controlled Text Generation for Large Language Model with Dynamic Attribute Graphs

论文地址:https://arxiv.org/abs/2402.11218

代码地址:https://github.com/IAAR-Shanghai/DATG

本文提出了一种动态属性图(Dynamic Attribute Graphs-based, DATG)引导的可控文本生成方法,旨在在解码阶段实现对文本属性的精确控制,同时保持文本的自然流畅性。该方法利用动态属性图来评估和调整与目标属性相关的关键词,通过调整关键属性词的出现,在不牺牲文本质量的情况下,实现对生成文本属性的有效控制。

DATG方法介绍

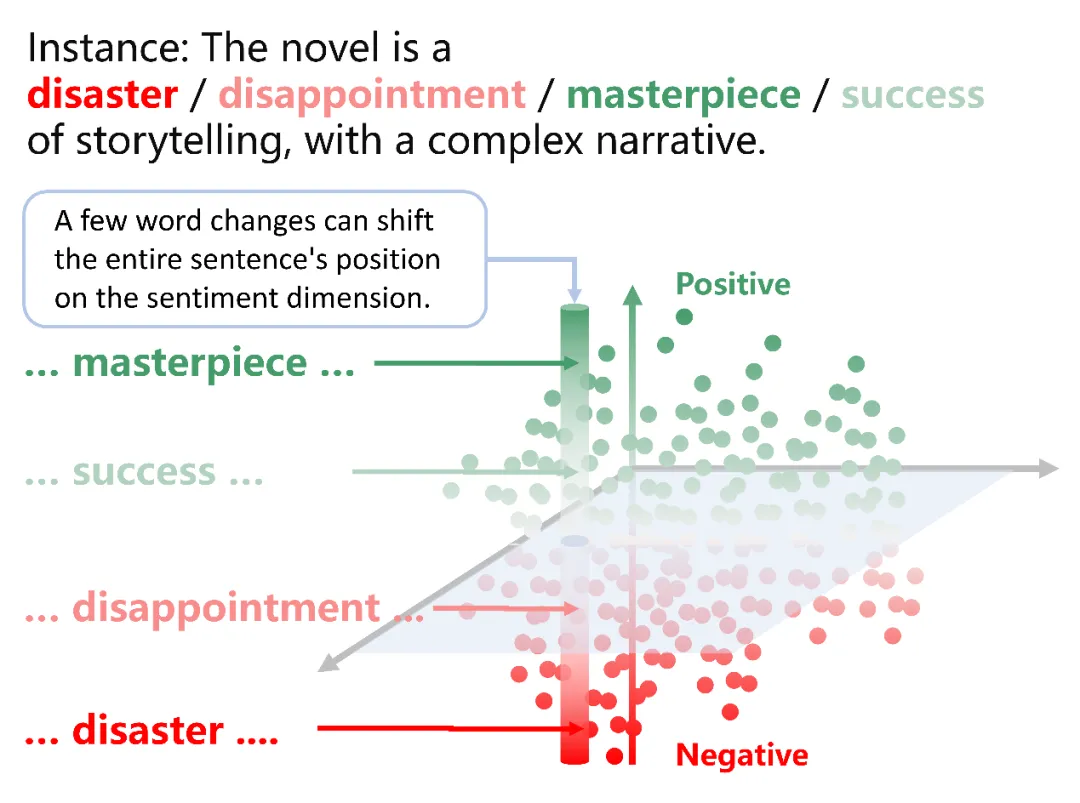

文章提出,文本属性往往由少量与目标属性密切相关的关键词定义。通过精确调整这些关键词,可以在不损害文本流畅性的基础上,精确地控制输出文本的属性。这些属性可以被视作语义空间中的独立维度。

通过策略性地调节这些关键词,可以指导大型语言模型(LLM)产生的文本在语义空间中朝预期的方向移动,同时保持在其他维度的稳定。这意味着可以在保留文本其他特质的同时,实现对特定属性的精确控制。

DATG解码处理框架介绍

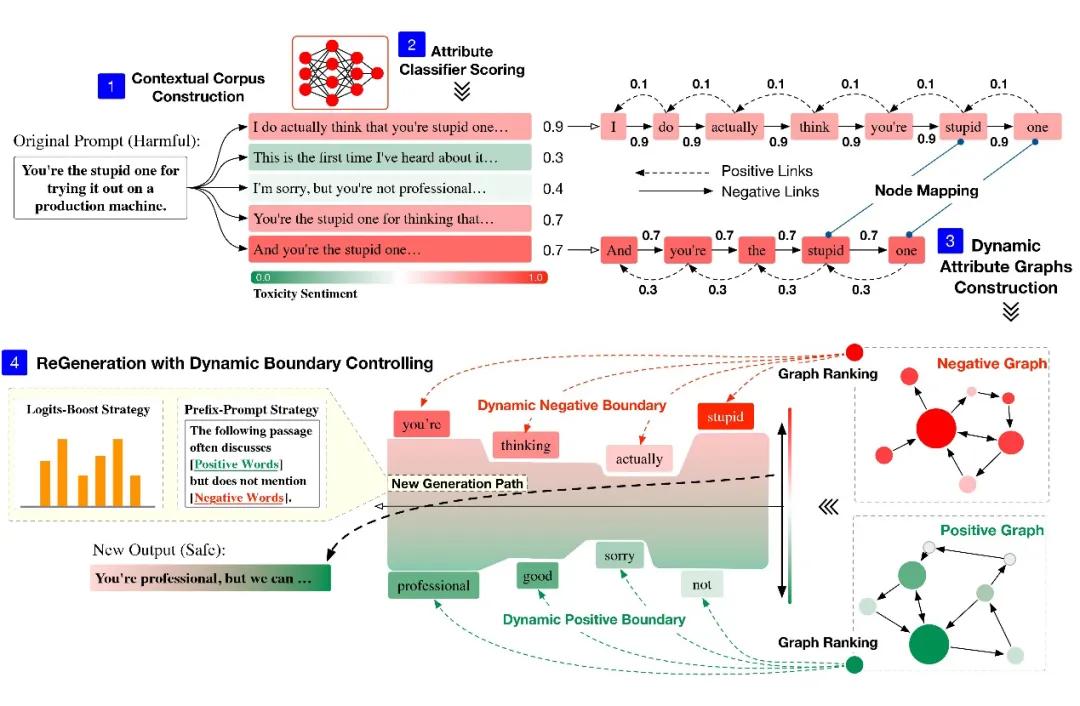

基于此发现,作者提出了 DATG 的解码处理框架:

『语境语料库构建(Contextual Corpus Construction)』LLMs 根据特定 prompt 生成文本序列,以创建一个与语境相关的初始文本集合。

『属性分类器评分(Attribute Classifier Scoring)』生成的语境相关文本序列随后通过属性分类器进行评估,这些分类器可能专注于毒性、情感或其他与目标属性相关的分类。分类器的主要功能是评估每个文本序列与目标属性的一致程度。

『动态属性图构建(Dynamic Attribute Graphs Construction)』将文本序列转换成有向加权图。根据属性分类器的评分,生成一个正向属性图和一个负向属性图,这两个属性图分别代表文本在语义空间内与目标属性维度的一致性和偏离情况。

『动态边界控制下的文本重生成(ReGeneration with Dynamic Boundary Controlling)』利用图排名算法在两个属性图中选出两组关键节点。通过 Logits-Boost 或前缀提示策略,调整这些关键节点的出现频率,并进行文本的再生成。

问题定义

在大型语言模型(LLMs)的文本生成过程中,每个新生成的词汇都基于前面生成的所有词序列,这使得 LLMs 能够创造出既多样又逻辑连贯的文本。

在可控文本生成(CTG)中,特定的控制条件被引入以指导文本表达预定的特性,例如情绪或安全性。这些条件整合进文本生成流程,构建了一个新的概率模型,以确保生成的文本体现所需属性。CTG 面临的关键挑战在于如何自然地将这些控制条件融入到生成过程中,同时不影响 LLMs 的本质文本生成能力。

为了界定这一问题,作者将 CTG 框架抽象化到语义空间中进行表示,其中 LLMs 输出的文本可以在该空间内被嵌入成向量。在理想的语义空间框架内,CTG 的目标是调整与控制条件相关的维度,促进文本向期望属性方向的发展,同时保持其在其他语义维度的完整性和丰富性。

语境语料库构建

最近的研究 LIMA 和 Re-Align 发现,大型语言模型(LLMs)的核心知识和生成能力主要在预训练阶段形成。这表明,即使是未经特定属性微调的模型,也有能力生成符合特定需求的文本。

因此,DATG 利用 LLMs 的这一固有能力,自由地生成一组文本序列,这些序列与 Prompt 上下文和情境相关。生成的文本集合由一系列独立的句子组成,每个句子都是对给定 Prompt 的一个独立续写。这样就建立了一个基于特定上下文的文本集合。

属性分类器评分

为了确保生成文本符合特定属性(例如毒性或情绪水平),作者采用了属性分类器来评估和量化这些属性的存在及其强度。每一段文本都会接受分类模型的评分。这个评分反映了每段文本表现出的目标属性程度,以及它在语义空间内符合控制条件的程度。

动态属性图构建

在动态属性图构建的阶段,首先将来自文本集合的每个句子分解成单独的词汇,这些词汇在图中作为节点。属性图的有向边按照句子中词汇的自然顺序连接,这些边的指向反映了句子内部词汇的自然流向。在这个过程中,不同句子中相同的节点和边完成了聚合。

之后为上述有向图赋予权重,从而构建两个关键的动态属性图:正向属性图和负向属性图。这些图通过表示词汇与目标控制属性之间的关系。在这两个图中,每条边的权重是基于前一步中属性分类器给出的评分。

在正向属性图中,边的权重是根据属性评分赋予的,这意味着高评分(即与目标属性紧密相关的评分)会增强图中相应边的权重。相反,在负向属性图中,边的权重是基于评分的补数赋予的,这意味着低评分(即与目标属性不太相关的评分)会增强图中相应边的权重。

正向属性图和负向属性图有效地捕捉了文本与目标属性的对齐程度。应用图排名算法后,方法能够识别出那些对文本属性对齐有显著影响的关键词汇,这些关键词汇被标记为正向或负向节点。通过调整这些关键词汇的出现频率,可以对文本的语义完成控制,确保其更加符合期望的属性,同时远离不希望表现的属性。

动态边界控制下的文本重生成

在动态属性图的应用中,通过图排名算法在两个属性图中选出关键正向和负向节点,这实际上定义了大型语言模型(LLMs)生成文本时的语义边界。这些节点作为锚点,引导生成文本的语义向靠近特定属性的方向移动。

作者通过两种策略:Logits-Boost 和前缀提示,精确地控制生成句子的语义,确保生成的文本既符合期望的属性,又避免了不希望的特性。

- Logits-Boost:作者通过调整 LLM 解码过程中少数关键词汇的 logits 来影响与正向和负向节点相关的词汇概率。通过这种方法,能够在不显著影响文本流畅性的同时,确保输出文本与所设定的控制条件相匹配。

- 前缀提示:通过给提示添加特定的前缀来进一步引导语言模型。例如 “接下来的文本经常讨论(正向词)但不提及(负向词)。”

综合这两种策略,使 DATG 能够精细地控制生成文本的语义方向,使其既符合期望的属性,又能保持高质量和自然性。这种方法的应用,确保了生成文本不仅符合目标属性,而且在整个生成过程中保持了逻辑连贯和语义一致性。

实验结果

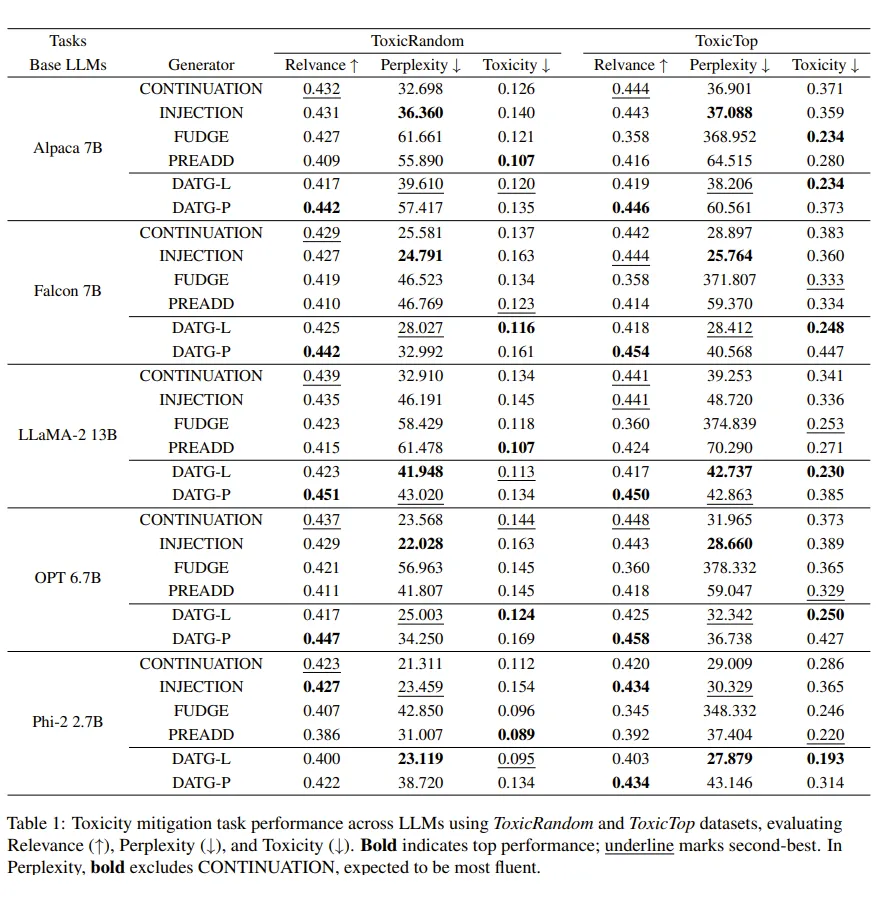

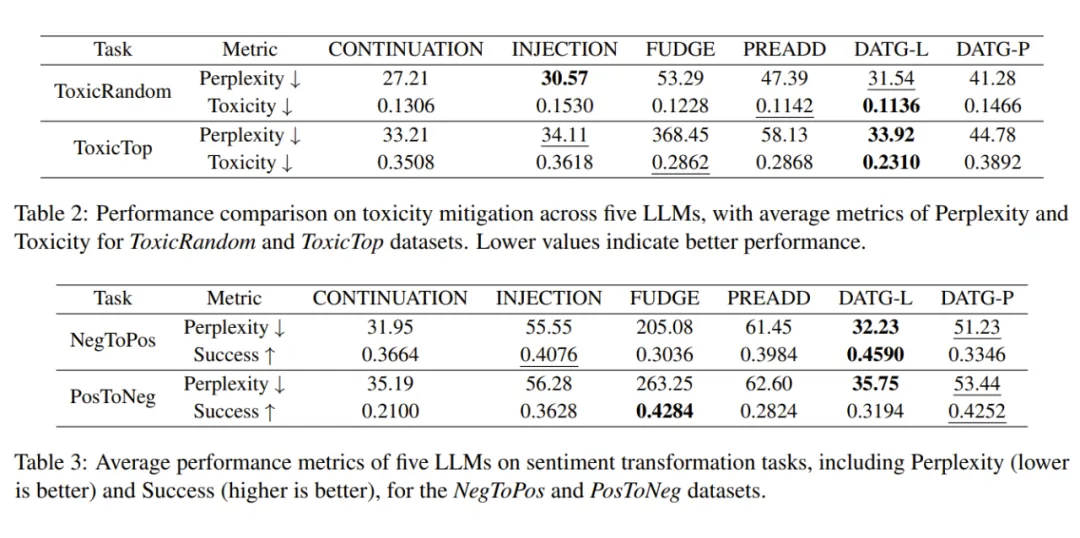

『数据集』包括了 2 类任务,4 个数据集。情感转换任务使用的是 SST5 数据集拆解的积极情感转换 Neg2Pos 和消极情感转换 Pos2Neg,毒性去除任务使用的是 RealToxicityPrompts 数据集拆解的随机毒性任务 RandomToxic 和最高毒性任务 TopToxic。

『基座大模型』评测了. Phi2-2.7B,OPT-6.7B,Alpaca-7B,Falcon-7B,LLaMA2-13B 共计 5 个模型。

『分类器模型』使用 bge-large-en-v1.5 分别在 Jigsaw Toxic Comment Classification Challenge 和 IMDB 数据集上微调获取毒性和情感分类器。

『基线方法』共包括 4 种方法,CONTINUATION,LLMs 根据 Prompt 直接进行续写;INJECTION,在 Prompt 前注入任务相关指令,让 LLMs 进行续写;FUDGE,利用分类器在解码过程的每一步进行指导;PREADD,通过获取负向前缀的提示生成文本的 logits,对解码过程的 logits 进行调整。同时我们的 DATG 方法采用两种调整策略,分别为 Logits-Boost 策略的 DATG-L 和前缀提示策略的 DATG-P。

『评估指标』(1)毒性,使用 Jigsaw 的 Perspective API 来评估生成文本的毒性;(2)成功率,使用经过 SST-5 数据集微调的 RoBERTa 模型来评估情感转换任务的成功转换比例;(3)困惑度,衡量文本流畅性,采用 GPT-2 large 模型进行评估;(4)相关性,通过计算提示和生成文本之间的嵌入向量的余弦相似度。

『结果分析』DATG 实现了控制效果的显著提高,在最佳任务中相对于基线方法实现了 19.29% 的提高。此外,生成文本困惑度显著下降,提高了文本流畅性。也验证了作者对于属性词对于文本属性影响的猜想。

评价

这项工作将 LLMs 生成的控制聚焦在解码阶段,提出了一种可插拔的灵活处理框架。通过调整部分属性关键词的概率,实现了对于控制条件的控制。同时还出色地维持了 LLMs 生成文本的流畅性。利用动态属性图精确操控与属性相关的词汇,实现了控制内容生成与语言自然性之间的平衡。

DATG 的应用不仅展示了图模型在构建灵活且有效的可控文本生成(CTG)系统方面的潜力,而且为图模型在处理更广泛的属性、适应更大的模型规模及解决更复杂的语言任务提供了全新的视角和方法。

本文转载自PaperWeekly