UBCFashion和TikTok新SOTA!复旦和腾讯优图发布端到端人像动画生成器VividPose!

文章链接:https://arxiv.org/pdf/2405.18156

项目链接:https://kelu007.github.io/vivid-pose/

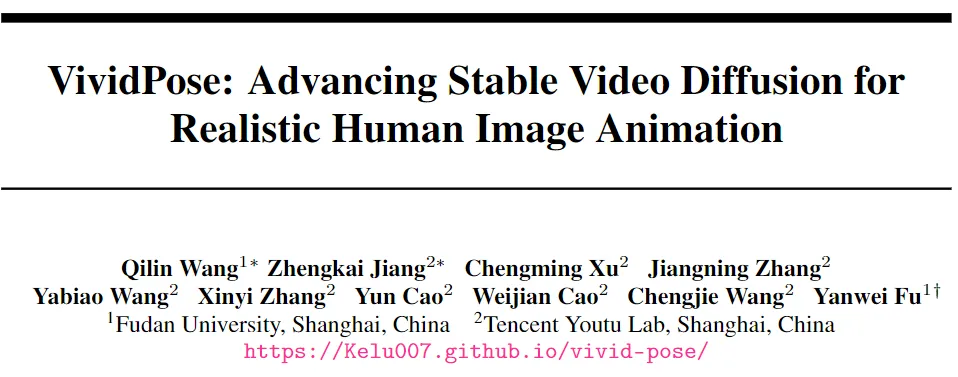

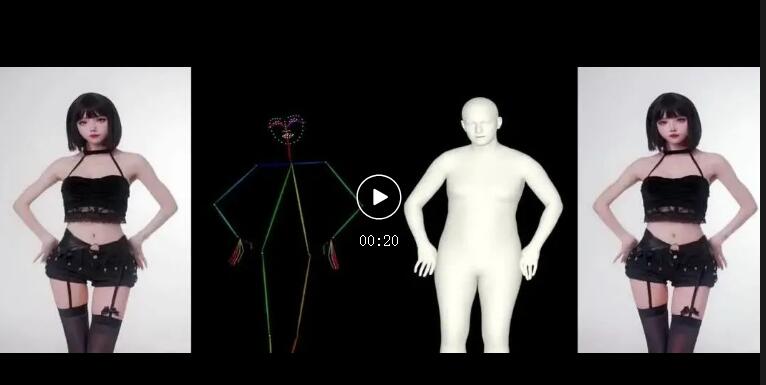

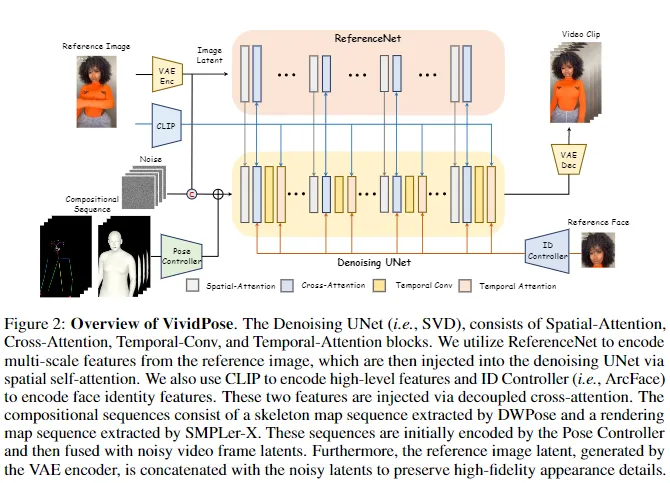

人像动画涉及通过遵循指定的姿势序列从静态图像生成视频。目前的方法通常采用多阶段pipeline,分别学习外观和动作,这往往导致外观退化和时间不一致。今天和大家分享一篇优化这些问题的工作————VividPose,这是一种基于Stable Video Diffusion (SVD)的创新端到端pipeline,确保了优越的时间稳定性。为了增强人类身份的保留,提出了一种身份感知外观控制器,该控制器集成了额外的面部信息,同时不影响服装纹理和背景等其他外观细节。这种方法确保生成的视频在各种姿势下保持对人类主体身份的高度保真度,保留关键面部特征。

为了适应多样的人体姿势和手部动作,引入了一种几何感知姿势控制器,该控制器利用SMPL-X的密集渲染图和稀疏骨架图。这使得生成的视频能够准确对齐姿势和形状,提供了一个能够处理广泛的体型和动态手部动作的强大框架。在UBCFashion和TikTok基准上的大量定性和定量实验表明,本文的方法实现了最先进的性能。此外,VividPose在提出的数据集上展示了出色的泛化能力。

本文的主要贡献:

- 提出了VividPose,这是一种利用Stable Video Diffusion的创新端到端pipeline,显著增强了人像动画视频的时间一致性和平滑度。

- 引入了一种身份感知外观控制器,该控制器集成了额外的面部信息,同时保留了服装纹理等其他外观细节。该方法确保在不同姿势下对人物身份的高度保真度。

- 提出了一种几何感知姿势控制器,该控制器利用密集渲染图和稀疏骨架图,确保了准确的体型生成,并有效适应各种体型和动态手部动作。

方法

概述

预备知识:Stable Video Diffusion (SVD)SVD 是一种最前沿的视频生成模型,它通过将潜在扩散模型从2D图像合成扩展到高分辨率、时间一致的视频创建,接收文本和图像作为输入。从技术上讲,SVD 引入了3D卷积和时间注意力层。这些时间层也集成到VAE解码器中。SVD的一个主要改进是从DDPM 噪声调度器转换为EDM调度器,该调度器使用连续噪声尺度σ进行更灵活和有效的采样,取代了离散时间步长。这种端到端的训练模式和pipeline在视频生成中保持了强大的时间一致性,使其特别适合于人像动画。

预备知识:SMPL-X SMPL-X是一种先进的3D参数化人体模型,通过结合详细的面部、手部和身体特征增强了SMPL 模型的能力。它将人体表示为具有固定拓扑的网格,由形状、姿势和表情参数控制。形状参数(β)捕捉身份特定的属性,姿势参数(θ)编码关节旋转,表情参数(ψ)模拟面部表情。为了从SMPL-X模型生成2D渲染图,采用了可微渲染过程。使用相机投影函数(Π),渲染过程公式化为:

SMPL-X基础姿势序列在工作中,上述过程准确地将3D人体模型投影到2D图像平面。对于人像动画,从参考图像中获取形状和表情参数(β和ψ),而姿势参数(θ)则从驱动视频中提取。生成的渲染图作为姿势条件,确保生成视频的体型与参考图像准确对齐,同时跟随驱动视频中的动态姿势,从而生成逼真且连贯的动画。

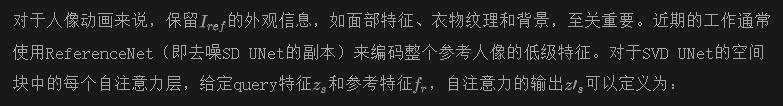

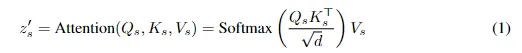

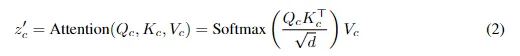

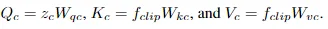

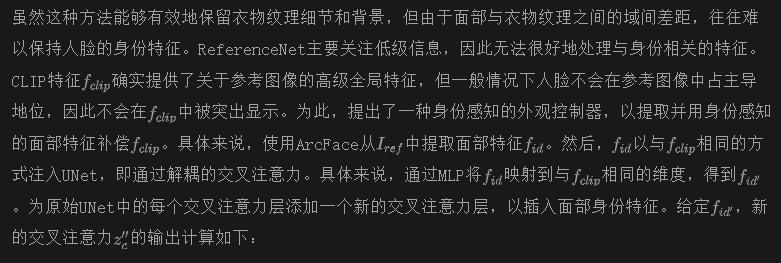

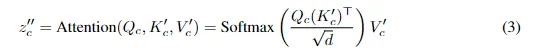

身份感知的外观控制

其中,

其中

其中,

因此,解耦交叉注意力的最终公式定义如下:

额外的注意力,如方程式3所示,增强了面部身份,而不影响其他外观信息,如服装纹理和背景,从而确保将细粒度的面部特征有效地与UNet特征集成,而不干扰其他外观特征。

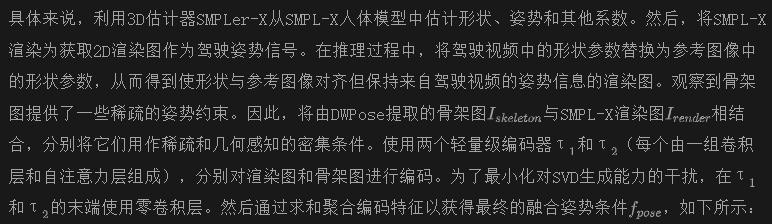

几何感知姿势控制

人体图像动画pipeline以参考图像和从任何驾驶视频中提取的姿势序列作为输入。现有方法通常使用骨架图或密集图(均来自2D姿势估计器)作为姿势驱动信号。这经常导致形状不对齐问题。具体而言,骨架图仅捕获姿势信息,忽略了身体形状的细节。而密集图包含姿势和形状信息,但身体形状来自驾驶视频,无法修改以与参考图像的身体形状对齐。因此,这导致姿势驱动信号的形状与参考图像中的形状不对齐,从而在生成的视频人体形状中产生不准确性。

为了解决这个问题,将3D参数化人体模型SMPL-X的渲染图纳入姿势驱动信号中。由于SMPL-X的参数化表示,可以建立重构的SMPL-X与从驾驶视频中提取的基于SMPL-X的姿势序列之间的几何对应关系。这种对齐不仅确保了姿势驱动信号的形状与参考图像的形状匹配,而且从3D信息中提供了额外的几何关系(例如,手交叉和身体遮挡)。通过分别从参考图像和驾驶视频中提取形状和姿势参数,可以创建渲染图,确保生成的视频人体形状与参考图像对齐,同时遵循驾驶视频的姿势。这种全面的表示对于实现逼真和连贯的动画至关重要,捕捉手部动作中的微妙细微差别,并有效处理身体形状的变化。

将添加到噪声潜变量中,然后将其输入到UNet中。

实验

设置

数据集。在两个常用的学术基准数据集上进行实验,即UBC-Fashion和 TikTok 数据集。还精心收集和处理了来自互联网的 3000 个视频,以进一步验证本文的方法在实际场景中的适用性。具体而言,UBC-Fashion 包括 500 个训练视频和 100 个测试视频,每个视频大约包含 350 帧。该数据集非常适用于与时尚相关的人体动画任务。TikTok 包含 340 个单人舞蹈视频,每个视频持续 10-15 秒。大多数 TikTok 视频侧重于人物的上半身。遵循 DISCO 并使用相同的训练和测试划分。精心筛选的数据集包括来自哔哩哔哩的 2224 个舞蹈视频和来自抖音的 776 个视频。这些视频涵盖了各种外观和姿势变化,如室内外场景、不同的服装纹理、不同年龄段和各种舞蹈风格。所有这些数据集的帧都根据原始视频的帧速率提取,并分别应用于每帧的 DWPose和 SMPLer-X 来推断骨架图和渲染图。

评估指标。评估单帧图像质量和整体视频保真度,以确保全面评估。对于单帧质量,使用 L1 误差、SSIM 、LPIPS 、PSNR 和 FID 。视频保真度通过 FID-VID 和 FVD进行评估。这些指标能够严格衡量单个帧的视觉质量和生成视频的时间连贯性,确保对方法的性能进行彻底评估。

实现细节。在训练过程中,个别视频帧被采样、调整大小并居中裁剪到分辨率为 512×768。使用 SVD-img2vid 初始化去噪 UNet 来一次生成 14 帧,并使用 SD2.1 初始化 ReferenceNet。去噪 UNet、ReferenceNet、身份控制器和姿势控制器都以端到端的方式进行训练。所有实验都在 8 个 NVIDIA 80GB H800 GPU 上进行,batch大小为 32。

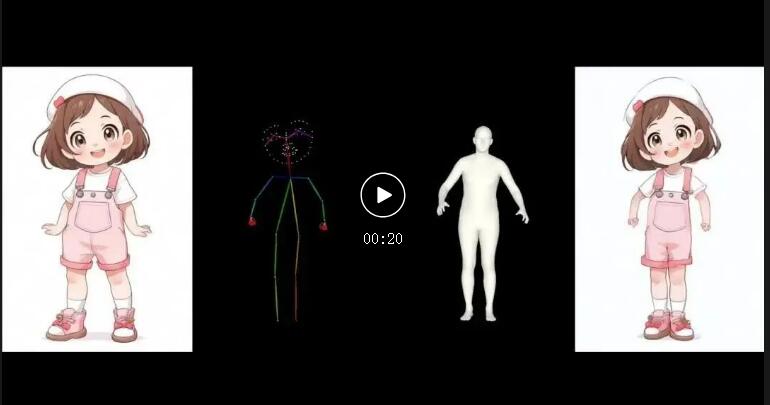

比较方法。评估包括与人体图像动画领域一系列最先进方法的全面比较:(1) MRAA 是一种基于 GAN 的方法,利用来自驾驶序列的光流估计来扭曲源图像。最近的基于扩散的方法,如 (2) MagicAnimate 和 (3) AnimateAnyone ,以其复杂的外观和时序建模而闻名,表现出令人印象深刻的性能。为了进行定量比较,还与 (4) DreamPose 进行了比较,该方法设计了一个适配器,以整合人体图像的特征。(5) DisCo也是一种先进的基于扩散的方法,它包含用于各种元素的不同条件模块,例如姿势、前景人物和背景。(6) BDMM 在时尚视频生成方面表现良好。由于采用了相同的基准和数据分割,定量比较是基于直接引用原始论文的统计数据进行的。

比较

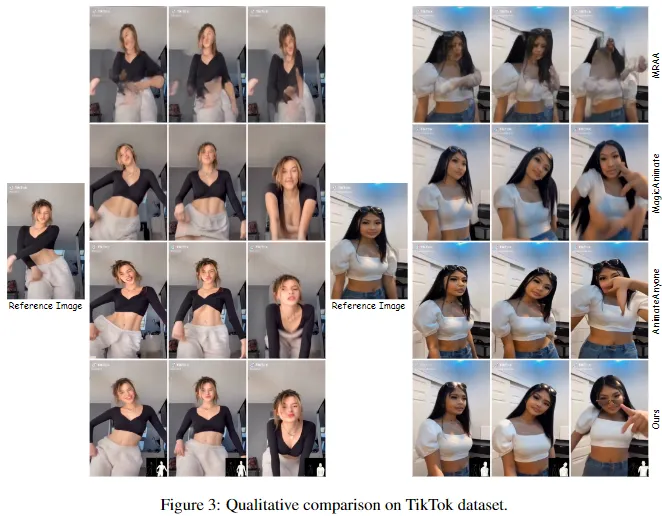

定性比较。从下图3可以明显看出,本文的方法在激烈运动过程中保持了更好的面部身份一致性,并成功实现了复杂的手势。一个有趣的案例(第四行,最后一列)显示,在剧烈运动后,本文的方法生成的角色佩戴的太阳镜从头上掉落,完美地落在了眼睛上。这表明本文的方法对物理世界有着更优秀的理解,进一步强调了它在创建逼真动画方面的优势。

总之,VividPose在几个关键领域明显优于最先进的方法。本文的方法在保留服装纹理细节、保持高度的面部身份一致性以及准确捕捉身体姿势变化方面表现出色。此外,VividPose有效地处理了涉及手部交叉和动态运动的复杂场景。这些优势突显了本文方法的稳健性和精确性,确保了超越现有技术性能的逼真连贯的人体图像动画。

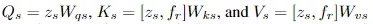

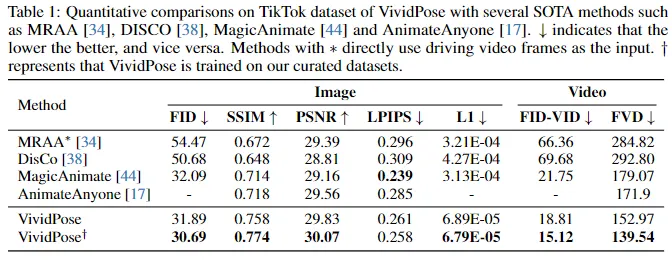

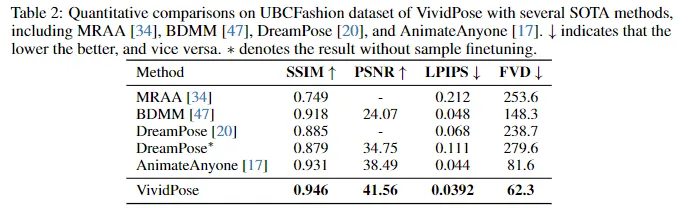

定量比较。对TikTok和UBCFashion数据集进行了广泛的定量比较,评估VividPose与几种最先进方法(包括BDMM、DisCo、MagicAnimate、AnimateAnyone和DreamPose)的性能。在TikTok数据集上的结果(下表1)显示,VividPose在多个指标上优于其他方法,实现了最低的FID得分、最高的SSIM和PSNR,以及最低的LPIPS得分之一。这些结果表明了出色的视觉质量、结构相似性和感知相似性。

在视频保真度方面,VividPose以最低的FID-VID和FVD表现出色,显示出优秀的时间一致性。当VividPose在精心筛选的数据集上进行训练时,性能进一步提高。在UBCFashion数据集上的结果(下表2)突显了VividPose的优势,在保持图像质量和感知相似性方面实现了最高的SSIM和PSNR,以及最低的LPIPS,表明了其在保留图像质量和感知相似性方面的优越能力。此外,VividPose实现了最低的FVD,证实了其生成时间连贯视频的能力。这些结果突显了VividPose在保留细粒度外观细节、保持面部身份和准确捕捉复杂身体姿势和动作方面的优势。VividPose在图像质量和视频保真度方面持续优于现有方法,使其成为人体图像动画的稳健可靠解决方案。

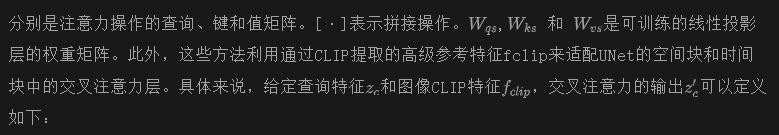

消融研究

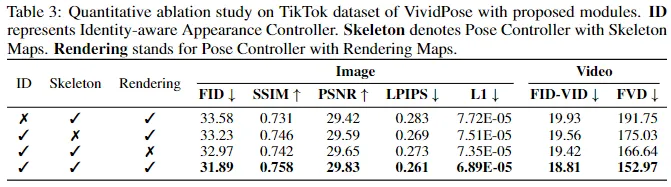

ID控制器的有效性。在TikTok数据集上的定量和定性割舍研究,如下表3和图5所示,强调了ID控制器的有效性。定量上,包含ID控制器改善了图像质量指标:FID从33.58降至31.89,SSIM从0.731增至0.758,LPIPS从0.283降至0.261。定性上,ID控制器确保了更好的面部身份一致性,在不同的姿势中保留了关键的面部特征。这对于保持被拍摄对象的识别度至关重要,特别是在动态场景中。ID控制器通过有效地编码和保留特定于身份的特征,确保生成的视频既视觉上吸引人,又在时间上连贯。

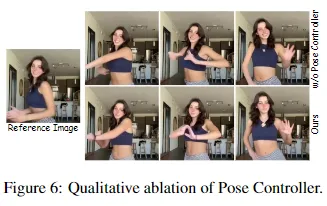

姿势控制器的有效性。姿势控制器利用骨架图和渲染图,对于保持运动连续性和处理复杂手势至关重要。如表3和下图6所示,启用这两个组件会导致更好的视频质量指标。骨架图为整体身体结构和运动提供了稀疏的框架,而渲染图则补充了关于身体形状和表面变形的详细信息。这种双重方法允许对动态姿势和复杂手势进行精确建模,这些通常很难复制。这些改进突显了姿势控制器在确保平滑连贯运动方面的有效性,特别是在涉及复杂手势和动态姿势的场景中。

结论

本文介绍了VividPose,一种基于Stable Video Diffusion(SVD)的人体图像动画的新型端到端pipeline。VividPose包括两个主要模块:(1)身份感知外观控制器通过合并面部信息增强了人体身份的保留,而不影响其他外观细节。

(2)几何感知姿势控制器使用来自SMPL-X的密集渲染图和稀疏骨架图,以适应多样化的身体形状和手势效果。在UBCFashion和TikTok基准上的大量实验表明,VividPose在时间一致性、视觉保真度和泛化能力方面取得了最先进的结果。它在数据集上也表现出色,展示了在实际场景中的稳健性。

本文转自 AI生成未来,作者:Qilin Wang等