大神Aviral Kumar:价值学习真的是离线 RL 的主要瓶颈吗? 原创

动机

- 离线强化学习 (RL) 和模仿学习之间的主要区别在于使用价值函数,并且离线 RL 中的大多数先前工作都侧重于使用更好的技术学习更好的价值函数。

- 所以价值函数学习是离线 RL 的主要瓶颈……对吗?

- 在这项工作中,研究人员表明,实践中情况往往并非如此!

分析离线强化学习的瓶颈

这项工作的主要目标是了解离线 RL 的性能在实践中如何受到瓶颈限制。

离线 RL 有三个潜在瓶颈:

- (B1 )数据价值评估不完善

- (B2)从学习到的价值函数中提取不完善的策略

- (B3)测试时策略泛化不完善,表明策略在评估期间访问

请注意,离线 RL 算法的瓶颈总是可以归因于这些因素中的一个或几个,因为如果所有因素都完美,代理将获得最佳性能。因此需要做的就是分别剖析这些组件!

主要假设

首先陈述本项研究的主要研究假设:

“离线 RL 的主要瓶颈是策略学习,而不是价值学习。”

换句话说,尽管价值学习当然很重要,如何从价值函数(B2 )中提取策略以及策略如何很好地推广到它在评估时访问的状态(B3)通常是显着影响许多问题中的性能和可扩展性的主要因素。

为了验证这一假设,在本文中进行了两项主要分析:在第一次分析中,比较了价值学习和策略提取(B1和B2);在第二次分析中,分析了策略泛化的效果(B3)。

长话短说

这是本文分析的简要内容 🙂:

- (1)策略提取通常比价值学习更重要:不要使用加权行为克隆(AWR);始终使用行为约束策略梯度(DDPG + BC)。

- (2)测试时间策略泛化是离线 RL 中最显著的瓶颈之一:当前的离线 RL 通常已经擅长在数据集状态下学习有效策略,而性能通常仅仅由其在分布外状态下的性能决定。

分析1:是价值还是政策?(B1和B2)

- 价值学习还是策略提取哪个更重要?

- 为了回答这个问题,研究人员使用不同数量的数据运行不同的算法进行价值函数训练和策略提取,并绘制数据缩放矩阵来可视化结果。

- 这说明(1)性能的瓶颈在于价值还是策略;(2)各种价值学习和策略提取算法之间的性能差异。

- 为了清楚地剖析价值学习和策略提取,在本研究中重点关注具有解耦价值和策略学习阶段的离线 RL 方法(例如IQL、一步式 RL、CRL 等)。这听起来可能有点限制性,但即使在这些解耦方法中,策略学习通常也是主要瓶颈!

分析设置

在本分析中考虑以下算法和环境。

三种价值学习算法:

- (1)隐式 Q 学习(IQL)

- (2)一步 RL(SARSA)

- (3)对比 RL(CRL)。

三种策略提取算法:

- (1)加权行为克隆(例如AWR、RWR、AWAC 等)

- (2)行为约束策略梯度(例如DDPG+BC、TD3+BC 等)

- (3) 基于采样的动作选择(例如,SfBC,BCQ,IDQL 等)

八项任务(包括目标条件(“ gc- ”)和基于像素的任务!):

- (1) gc-antmaze-large

- (2) antmaze-large

- (3) d4rl-hopper

- (4) d4rl-walker2d

- (5) exorl-walker

- (6) exorl-cheetah

- (7) kitchen

- (8)(基于像素的)gc-roboverse。

结果

显示全部结果

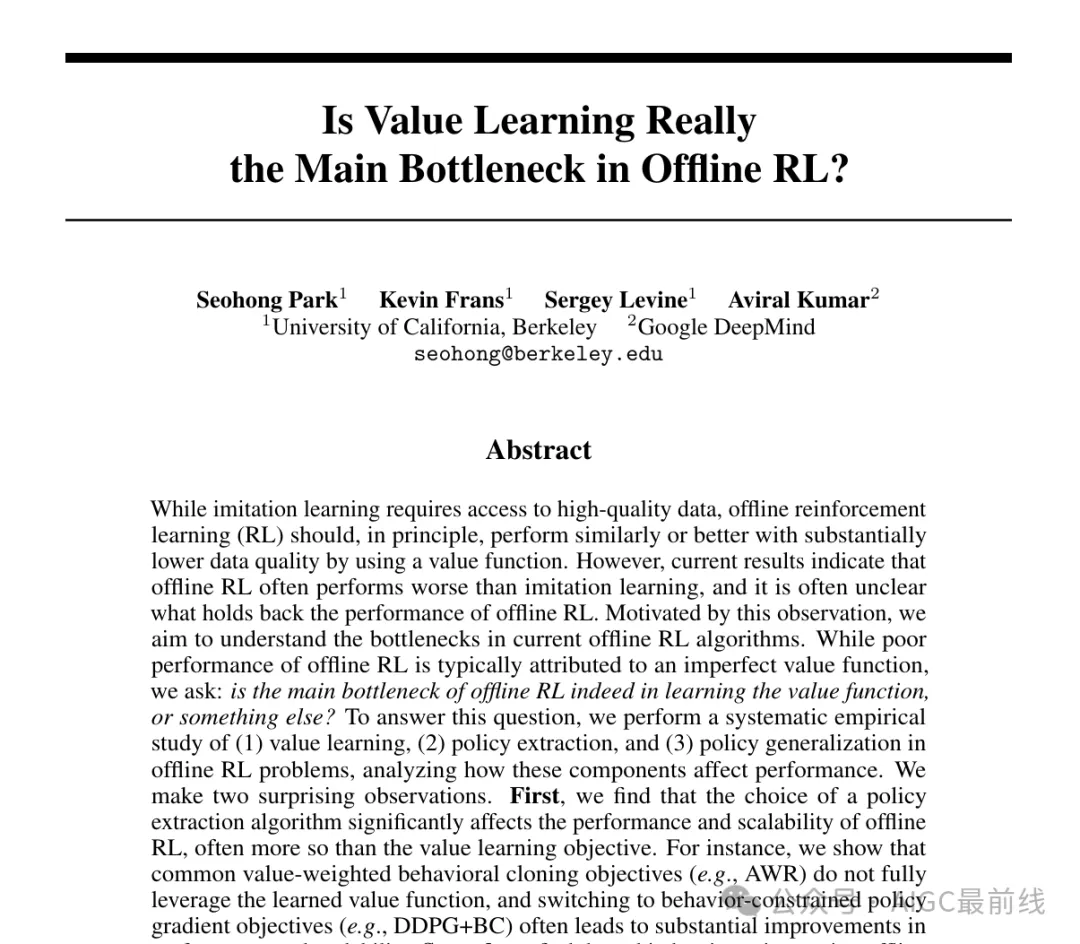

- 上图显示了数据缩放矩阵。重点介绍了exorl-walker和exorl-cheetah上的结果。单击上面的按钮可查看八个任务的完整数据缩放矩阵,这些矩阵是从总共 7744 次运行中汇总而来的。为每个矩阵条目单独调整了策略提取超参数。

- 通过查看颜色渐变,可以看到每个算法的性能如何随着更多数据的增加而扩展以及/或者如何出现瓶颈。下面,重点介绍一些关键观察结果。

- 首先,可以看到,策略提取算法通常对性能和数据扩展趋势的影响远远大于一般的价值学习目标(也许除了antmaze-large),即使它们从相同的价值函数中提取策略!

- 在策略提取算法中,可以发现DDPG+BC 几乎总是全面实现最佳性能和扩展行为,其次是 SfBC,而 AWR 的性能在许多情况下明显落后于其他两种。

- 还可以看到,AWR 的数据缩放矩阵总是具有垂直或对角线的颜色渐变,这表明它没有充分利用价值函数(请参阅下文以获得更明显的证据)。

分析2:策略泛化(B3)

- 现在,将注意力转向离线 RL 中的第三个独特瓶颈:策略泛化。

- 在离线 RL 中,代理在测试时会遇到新的、可能超出分布的状态,而它对这些新状态的推广程度会直接影响性能。

分析设置

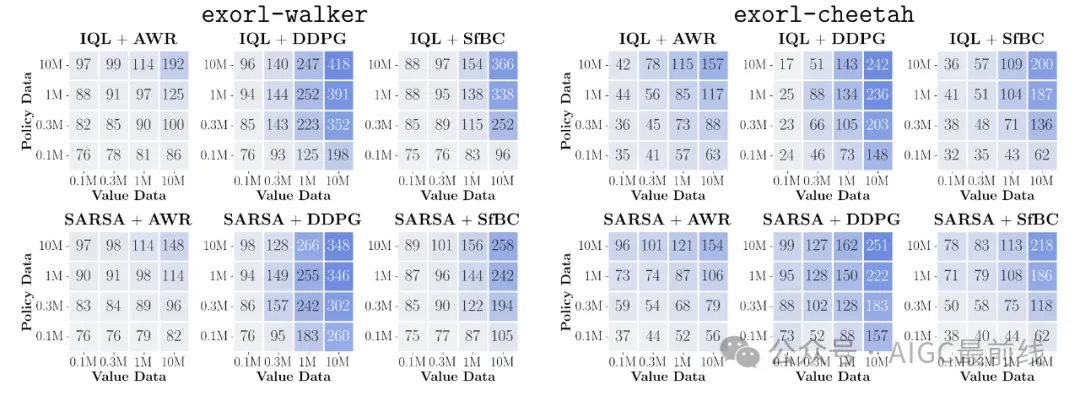

- 为了理解这个泛化瓶颈,首先定义三个量化策略准确性的关键指标:

- 直观地讲,这些指标衡量了该策略在三种不同分布上的准确度。

- 也许你已经熟悉训练 MSE和验证 MSE。但还有另一个指标:评估 MSE,它看起来可能与验证 MSE 相似,但实际上非常不同。

- 验证 MSE 和评估 MSE 之间的关键区别在于,验证 MSE 衡量的是分布内的策略准确率,而评估 MSE 衡量的是分布外的策略准确率(见上图)。评估 MSE 恰好对应于要测量的泛化瓶颈。

- 为了了解这些数量与性能之间的关系,观察了这些指标和性能如何随着额外的在线交互数据而发展(通常称为离线到在线 RL设置)。

结果

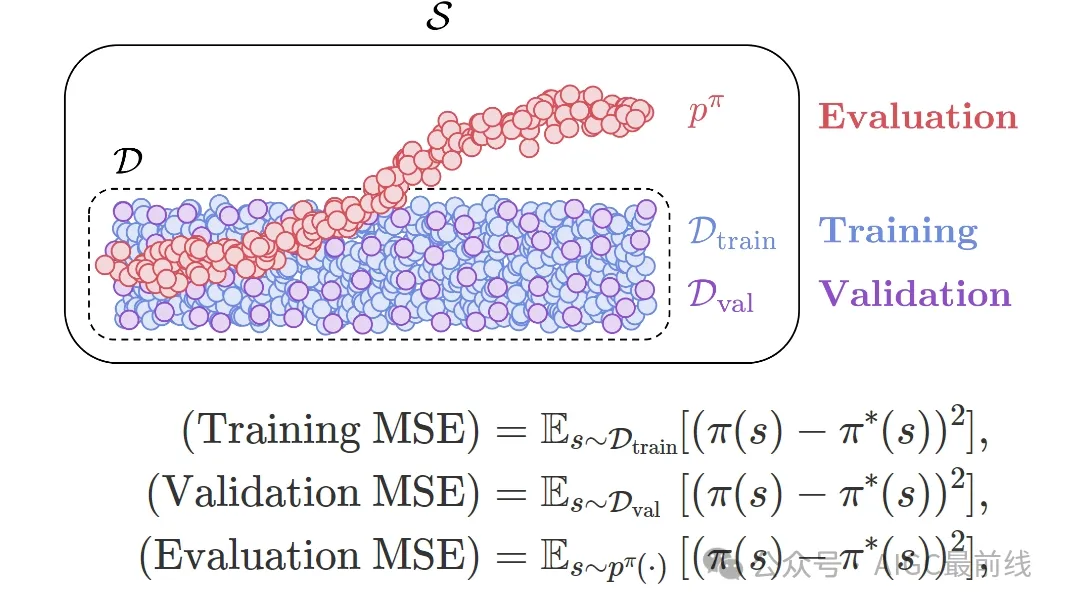

- 上图显示了回报和 MSE 指标如何随着更多在线互动数据而改善。用红色表示在线训练步骤。

- 结果非常令人惊讶!可以看到:(1)离线到在线 RL 大多只会改善评估 MSE,而验证 MSE 和训练 MSE 通常保持完全平坦;(2)离线 RL 的性能与评估 MSE指标呈非常强(负)相关性。

- 这是什么意思?这意味着当前的离线 RL 算法可能已经足够擅长在离线数据集覆盖的状态分布中学习最佳策略,并且性能通常仅由代理在测试时遇到的新状态的策略准确性决定!

- 这为离线 RL 中的泛化提供了一个新的视角,这与之前对悲观主义和行为正则化的关注有些不同。

- 那么,如何才能提高测试时策略的泛化能力呢?不幸的是,这在原则上非常困难,因为它需要泛化到一个可能完全不同的分布。尽管如此,如果稍微放宽假设,就可以解决这个问题,在本文中提出了两种这样的解决方案。

解决方案 1:提高离线数据覆盖率

- 第一个解决方案是使用高覆盖率的数据集。

- 理由很简单:如果测试时间分布外的泛化是瓶颈,可以简单地使用更多数据使测试时间状态分布内(当然,当可以收集更多数据时🙂)!

- 在上面的图中,尽管高覆盖率数据集的次优性有所增加,但它们确实提高了性能。另外,请注意,在这种情况下,使用正确的策略提取目标 (DDPG+BC) 也很重要!

解决方案 2:测试时策略改进

- 如果无法控制数据,那么提高测试时间策略准确性的另一种方法就是在测试时间状态下即时训练或指导策略。

- 为此,在论文中提出了一种非常简单的方法,称为即时策略提取(OPEX)。关键思想是在评估时简单地按照价值梯度的方向调整策略动作。

- 具体来说,在测试时从策略

- 中采样一个动作后,会根据冻结的学习到的 Q 函数进一步调整该动作,公式如下。

其中

是与测试时“学习率”相对应的超参数。

- OPEX 在评估时只需要一行额外的代码,并且根本不会改变训练程序!

- 在本文中,研究人员提出了另一种方法,即测试时训练(TTT),它在测试时推出期间进一步更新策略参数。

- 这些即时策略改进技术通过缓解测试时间策略泛化瓶颈,提高了各种任务的性能。

要点:测试时策略泛化是离线强化学习中最显著的瓶颈之一。使用高覆盖率数据集。使用即时策略改进技术提高测试时状态下的策略准确性。

那么,这说明了什么?

- 与之前认为价值学习是离线 RL 的主要瓶颈的观点有些相反, 当前的离线 RL 方法通常严重受限于从价值函数中提取策略的准确性以及该策略推广到测试时间状态的准确性。

- 对于实践者来说,分析表明离线 RL 有一个明确的方案:在尽可能多样化的数据上训练价值函数,并允许策略最大限度地利用价值函数,并采用最佳策略提取目标(例如DDPG+BC)和/或潜在的测试时间策略改进策略。

- 对于未来的算法研究,强调离线 RL 中的两个重要开放问题:(1)从学习到的价值函数中提取策略的最佳方法是什么?有没有比 DDPG+BC 更好的方法?(2)如何训练策略,使其在测试时间状态下具有很好的泛化能力?

- 第二个问题特别有趣,因为它提出了与离线 RL 中普遍存在的悲观主义主题截然相反的观点,其中只有少数作品明确旨在解决离线 RL 的这种泛化方面!

译自(有删改):https://seohong.me/projects/offrl-bottlenecks/

本文转载自公众号AIGC最前线