信息抽取哪家强?ChatGLM3、Qwen、Baichuan2、ChatGPT

信息抽取中文开源大模型评测

信息提取(IE)在自然语言处理(NLP)中扮演着至关重要的角色,它通过从非结构化文本中提取结构化信息,从而促进与依赖结构化数据的各种现实世界应用的无缝集成。深入探讨了主流中文开源LLMs在处理IE任务时的表现,特别是零样本条件下,即模型未针对特定任务进行微调。

模型选择:共选择了5个大型语言模型(LLMs)进行实验:ChatGLM3-6B、Qwen-7BChat和Qwen-14B-Chat、Baichuan2-13B-Chat以及ChatGPT2。除了ChatGPT外,所有其他大型语言模型都是开源的。

实验设置:所有的实验都可以在1个A40 GPU上完成。

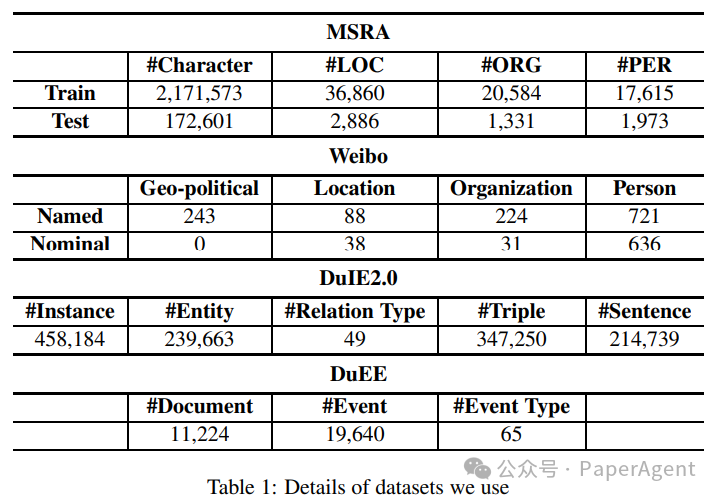

数据集:

NER实验结果:

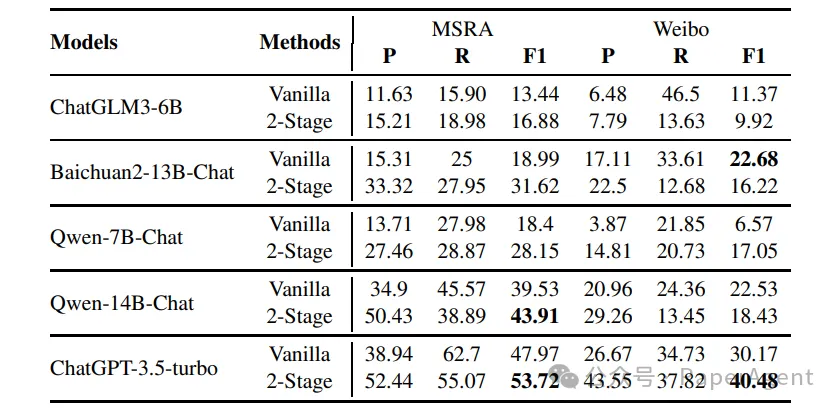

在MSRA和微博数据集上进行的零样本实验的结果。加粗的值代表了在相同数据集上所有大型语言模型(LLMs)和开源大型语言模型中最高的分数。

- 在所有大型语言模型中,ChatGPT-3.5-Turbo表现最佳,在所有数据集和方法中实现了最高的F1分数。在所有开源大型语言模型中,Qwen-14B-Chat在MSRA数据集上取得了最高的F1分数,而Baichuan-13B-Chat在微博数据集上记录了最高的F1分数。

- 在所有开源大型语言模型中,具有13B/14B参数的LLM一致性地在相同方法和数据集的准确性上超过了具有6B/7B参数的LLM。除了Baichuan13B-Chat在微博数据集上使用2-Stage方法得到的F1分数比Qwen-7B-Chat低0.55之外,所有具有13B/14B参数的模型在相同方法和数据集上都展示了比具有6B/7B参数的模型更好的F1分数。背后的可能原因是更大的LLM可能包含更多与实体识别相关的知识,从而带来更准确的分类结果。

- 在模型保持不变的情况下,MSRA数据集上的F1分数高于微博数据集。这种差异可以归因于几个因素。首先,两个数据集的固有难度水平不同。其次,MSRA数据集的来源是报纸媒体,包含书面语言,而微博数据集来源于社交媒体,更加口语化。在这些因素中,模型的内在知识与书面语言更为一致,使其更擅长从书面文本中提取信息。

RE实验结果:

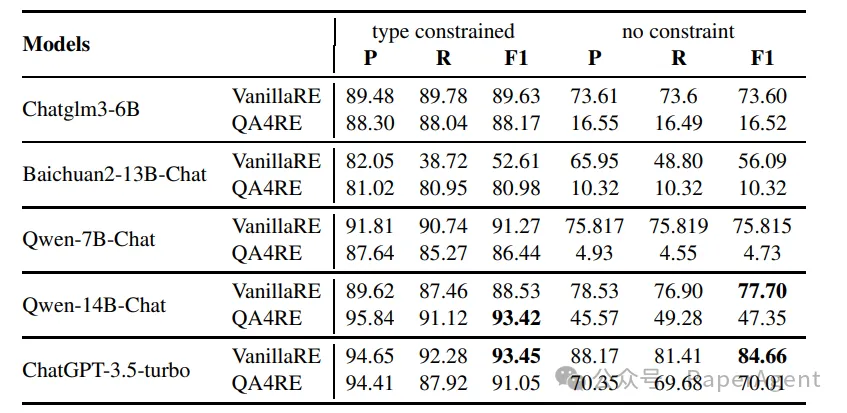

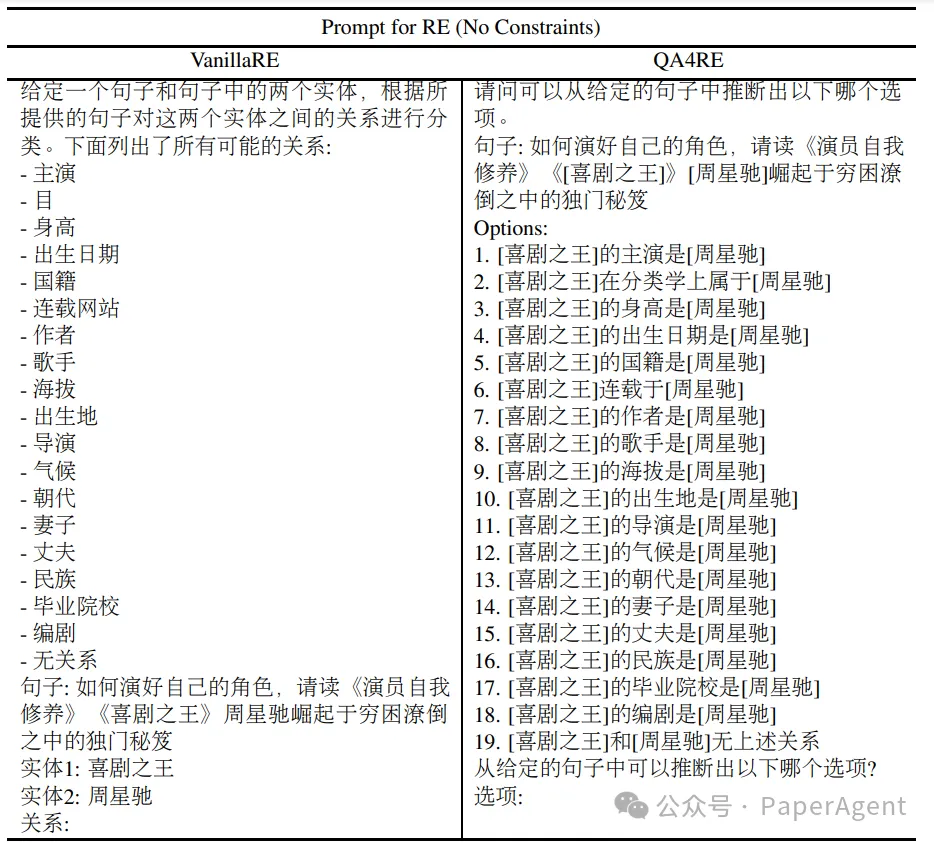

零样本关系抽取在DuIE2.0数据集的20000个子集上的实验结果(%)。对于每个大型语言模型(LLM),我们用加粗标记更好的结果,以比较两个框架。

- 大多数大型语言模型(LLMs)在使用类型约束时表现良好,但没有类型约束时性能显著下降。没有类型约束时,每个LLM需要从50种关系类型中选择一个,而约束可以减少LLMs的大量干扰信息。值得注意的是,在某些实体对上,只保留了唯一正确的关系和NoTA(无上述关系)关系。

- 在传统的Vanilla框架上的性能优于QA4RE框架。一方面,DuIE2.0数据集的关系抽取(RE)任务对LLMs来说可能并不十分困难,而引入问答(QA)增加了理解的难度。另一方面,在无约束实验中,向提示中添加了许多不合理的选项(例如,Alice是Bob的出版商)。这些信息干扰了LLMs对关系类型的选择。

EE实验结果:

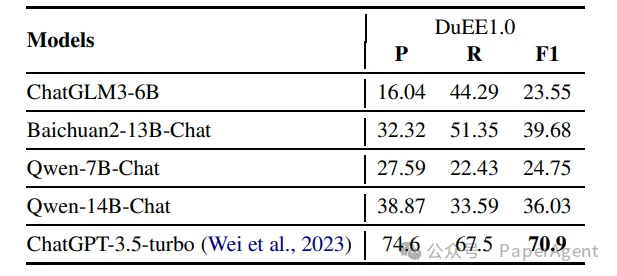

零样本事件抽取(EE)实验的结果。加粗的值代表了所有大型语言模型(LLMs)中的最高分数。

考虑到EE任务对模型阅读理解能力的更高要求,只有两阶段分解方法能够产生更清晰的回答。ChatGPT继续在所有LLMs中以最高的F1分数领先,这在很大程度上归功于其在提示中把握复杂输出格式要求的卓越能力。在开源模型中,Baichuan2-13B-Chat展示了最佳性能;然而,其F1分数仍然比ChatGPT低31.22分。

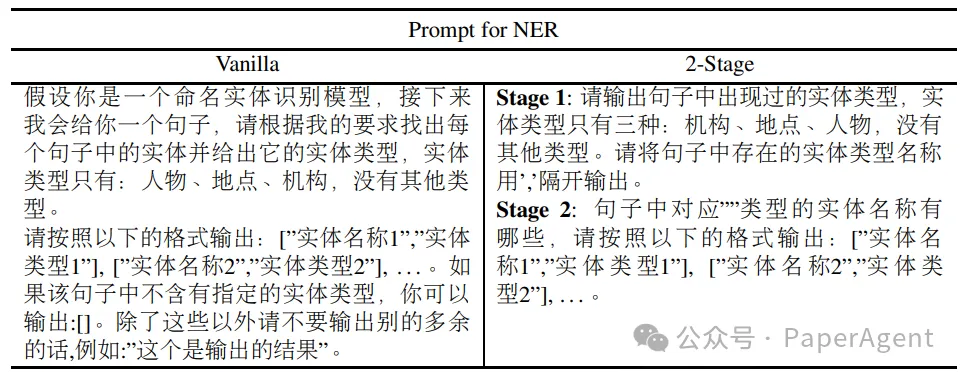

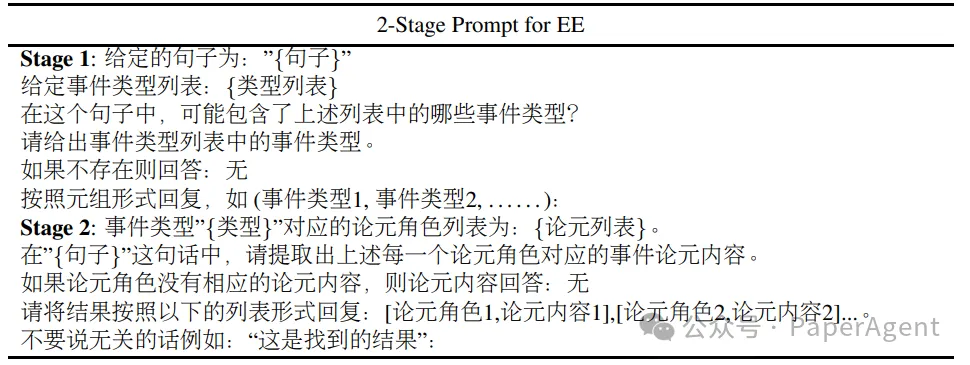

NER、EE、RE的Prompt模板

https://arxiv.org/pdf/2406.02079

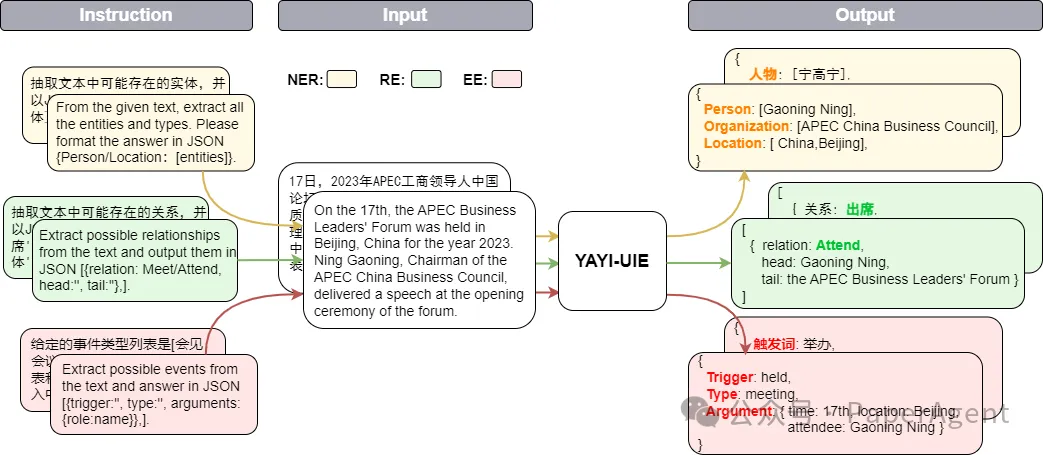

Assessing the Performance of Chinese Open Source Large Language Models in Information Extraction Tasks兼看开源IE大模型:YAYI-UIE

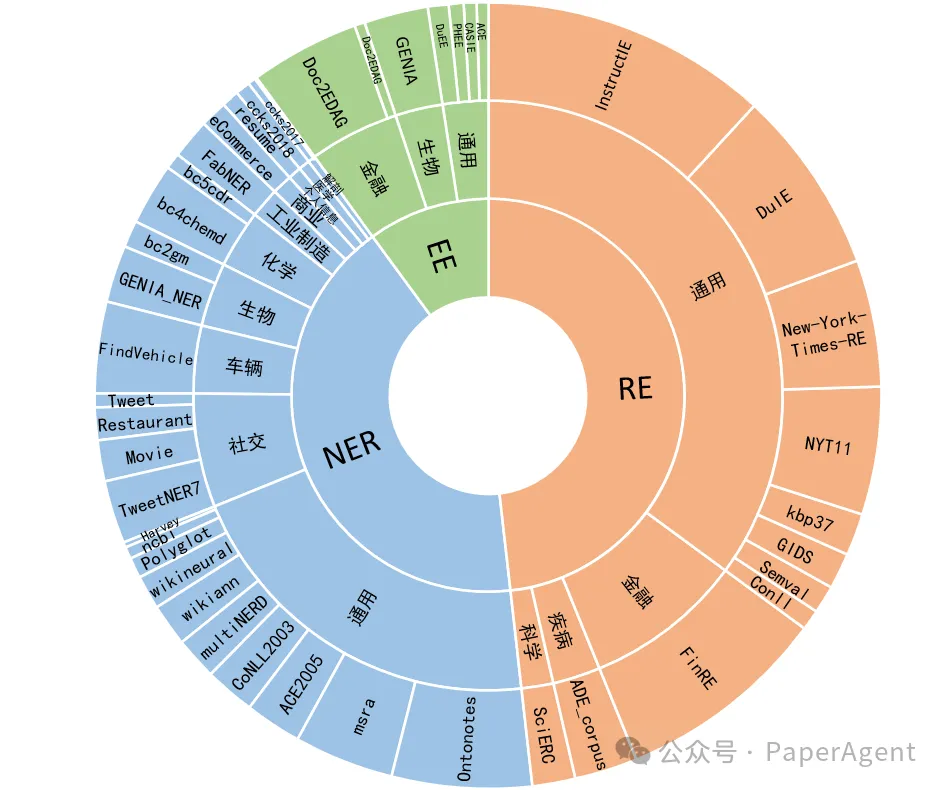

雅意信息抽取统一大模型 (YAYI-UIE)在百万级人工构造的高质量信息抽取数据上进行指令微调,统一训练信息抽取任务包括命名实体识别(NER),关系抽取(RE)和事件抽取(EE),实现通用、安全、金融、生物、医疗、商业、个人、车辆、电影、工业、餐厅、科学等场景下结构化抽取。

训练数据,百万级语料中文54%,英文46%;其中数据集包括12个领域包括金融,社会,生物,商业,工业制造,化学,车辆,科学,疾病医疗,个人生活,安全和通用。覆盖数百个场景

指令样例/Sample Prompts

实体抽取任务/NER task

文本:xx

【实体抽取】抽取文本中可能存在的实体,并以json{人物/机构/地点:[实体]}格式输出。

Text:

From the given text, extract all the entities and types. Please format the answer in json {person/organization/location:[entities]}.关系抽取任务/RE tasks

文本:xx

【关系抽取】已知关系列表是[注资,拥有,纠纷,自己,增持,重组,买资,签约,持股,交易]。根据关系列表抽取关系三元组,按照json[{'relation':'', 'head':'', 'tail':''}, ]的格式输出。

Text:

From the given text, extract the possible head entities (subjects) and tail entities (objects) and give the corresponding relation triples.The relations are [country of administrative divisions,place of birth,location contains]. Output the result in json[{'relation':'', 'head':'', 'tail':''}, ].事件抽取任务/EE tasks

文本:xx

已知论元角色列表是[质押方,披露时间,质权方,质押物,质押股票/股份数量,事件时间,质押物所属公司,质押物占总股比,质押物占持股比],请根据论元角色列表从给定的输入中抽取可能的论元,以json{角色:论元,}格式输出。

Text:

Given the text and the role list [seller, place, beneficiary, buyer], identify event arguments and roles, provide your answer in the format of json{role:name}.

github:https://github.com/wenge-research/YAYI-UIE

模型:https://huggingface.co/wenge-research/yayi-uie

数据集:https://huggingface.co/datasets/wenge-research/yayi_uie_sft_dat本文转载自PaperAgent