纯MLP模型达到新SOTA,基于序列-核心表征融合的高效多元时间序列预测

今天给大家介绍最近的一篇探索如何在更好地建模通道(channel)之间的相关性的多元时间序列文章。文章旨在解决通道独立(channel independent)方法缺乏对通道之间相关性的利用,以及通道依赖(channel dependent)方法不够鲁棒的问题。这篇文章,提出了一种新颖的中心化结构传递不同通道的信息,相比于分布式结构如Attention,Mixer等,这种中心化的结构既降低了计算开销,而且提高了对于异常通道的鲁棒性,以更低的复杂度获得更好的性能。

论文标题:SOFTS: Efficient Multivariate Time Series Forecasting with Series-Core Fusion

下载地址:https://arxiv.org/pdf/2404.14197

论文代码: https://github.com/Secilia-Cxy/SOFTS

1.背景介绍

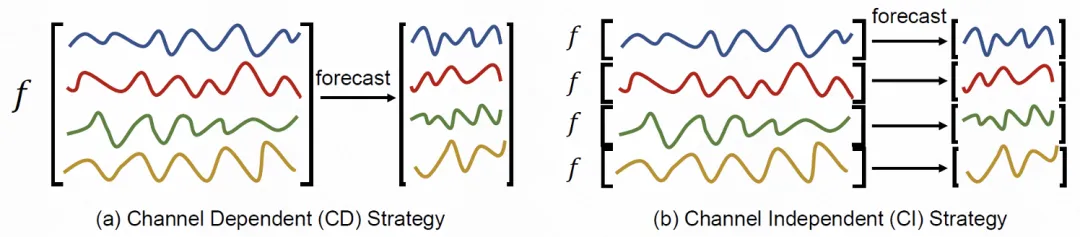

在多元时间序列领域,学术界存在两种建模方式,一种是通道独立(channel independent)方法,一种是通道依赖(channel dependent)方法。

通道独立方法将多元时间序列将多个通道的序列看做多条单元时间序列,使用一个统一的单元时序预测模型进行预测,这种方法因其在非平稳数据上的出色鲁棒性被众多先进方法采用,但是其忽略了通道之间的相关,阻碍了其进一步的性能提升。

通道依赖方法利用特定的通道信息融合模块实现通道间信息的交互,然而这些方法要么过于依赖通道之间的相关性导致缺乏足够的鲁棒性对抗序列的非平稳性,要么使用了复杂的关系建模模块如Attention使得复杂度过高难以扩展。

因此,如何利用通道独立的鲁棒性,并且设计更鲁棒和高效的通道交互模块,是先进多元时序预测方法必须要考虑的问题。

为了解决上述问题,文章主要有以下几个贡献:

提出了Series-cOre Fused Time Series(SOFTS)模型,这是一种基于MLP的简单模型,具有较低的复杂度但表现出最先进的性能。

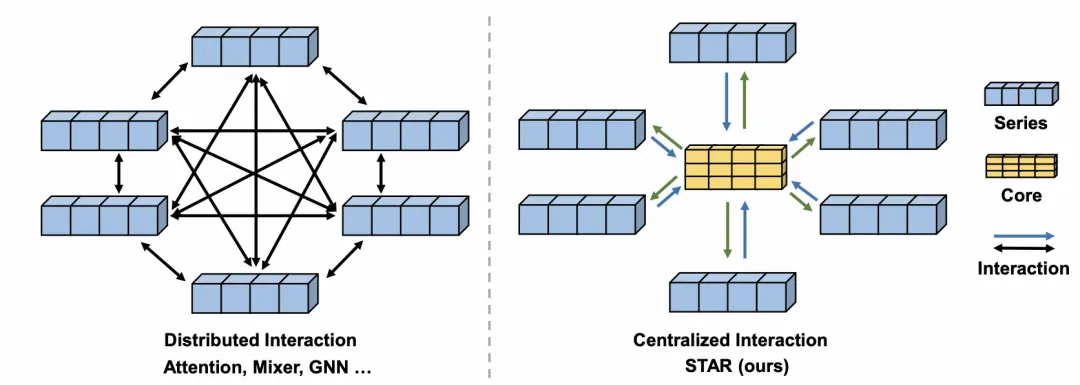

提出了STar Aggregate-Redistribute(STAR)模块,作为SOFTS的基础。STAR设计为一种中心化结构,使用一个核心来聚合和交换各通道的信息。与Attention等分布式结构相比,STAR不仅降低了复杂度,还提高了对通道异常的鲁棒性。

最后,通过广泛的实验,我们验证了SOFTS的有效性、可扩展性以及鲁棒性。

1.实现方法

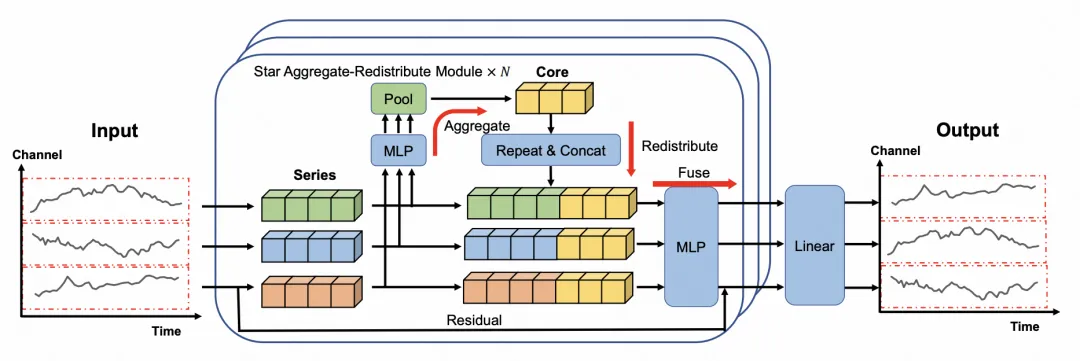

这篇文章提出了一个非常简单且高效的基于MLP的方法,其名字为Series-cOre Fused Time Series forecaster (SOFTS)。正如其名,该方法通过多个通道的序列表示和整个多元序列的核心表示融合来实现通道之间关系的建模。

主要架构如图下图所示。可以看到, SOFTS和iTransformer一样,使用序列级别的embedding,提取每个通道的表示,不同的是,SOFTS通过一种星型聚合分发模块(STar Aggregate Redistribute module, 简称STAR)提取不同通道的序列之间的相关性,交换不同序列的信息。最后,SOFTS通过线性层对每个通道的未来做出预测

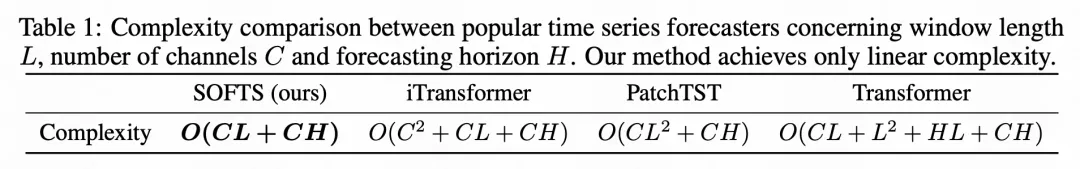

STAR是整个SOFTS方法的核心,它针对性地解决了现有通道交互模块的两个问题:(1) Attention等模块需要两两对比不同通道并计算相似度,导致平方级别的复杂度 (2) 这种两两比较易受通道本身的质量影响,而在现实的非平稳数据上,往往存在很多异常通道。为了实现高效性和鲁棒性,STAR借鉴了计算机网络结构中的中心化架构,相比于深度学习里常用的分布式架构如Attention, Mixer, GNN等,STAR能够将复杂度缩小到线性级别的同时,并且减小异常通道的影响。

具体而言,多个通道的序列表示首先通过一个MLP映射,然后通过一个pooling操作得到一个核心(core)向量,这个核心向量综合了不同序列的特征,代表了整个序列的全局信息,然后将这个核心向量拼接到每个表示后,并用另一个MLP层进行融合。整个过程的计算复杂度只与通道数量,序列长度等呈线性关系。

3.实验结果

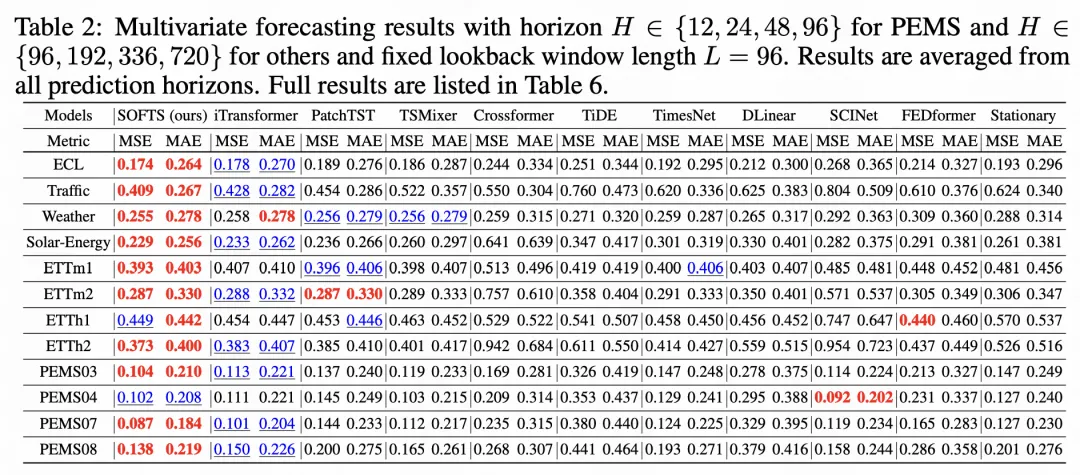

在实验效果上,本文提出的SOFTS模型结构在现有的多元时序预测benchmark上均取得了比较明显的提升。在下表展示出的24个结果中,有21个是第一,3个是第二。

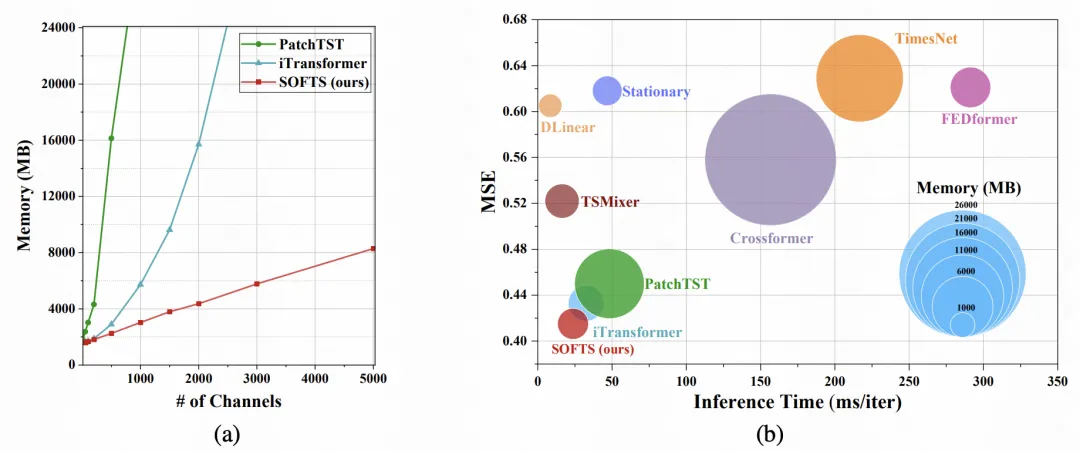

基于纯MLP结构,SOFTS能以更小的计算和存储代价获得更好的性能,如右图所示,以更快的推理和更小的内存消耗获得了最好的性能。且由于SOFTS模型的线性复杂度,其更易扩展到更大规模的数据集和问题中,如左图所示,对比了同样性能较好的iTransformer和PatchTST模型,SOFTS在通道迅速增长的情况下依旧可用,而另两个模型则迅速超过常用的24G显存上限。

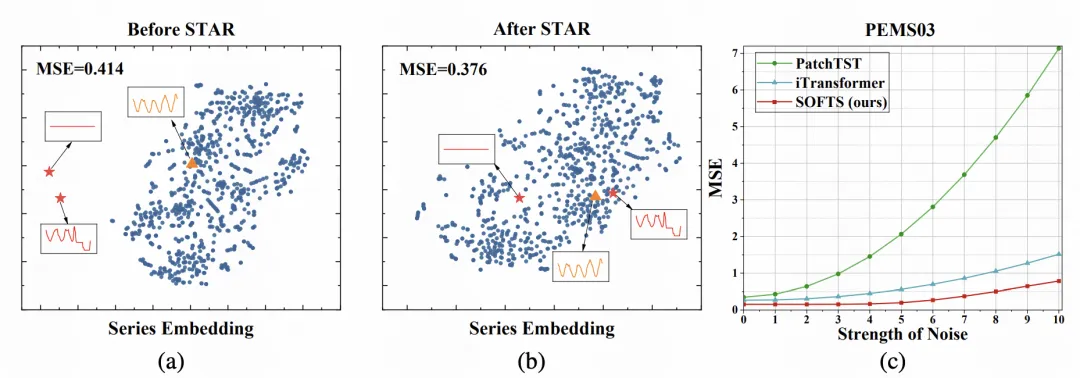

通过STAR模块,SOFTS能够调整异常序列的表征,下图(a)表示了进入STAR之前的序列表示,异常的通道出现在远离正常分布的位置,在这种表示上预测仅能获得0.414的预测误差,而通过STAR调整后,这些通道的表示被重新调整,根据不同序列的特征聚类到类似的正常通道附近,其预测性能也被提升至0.374,提升幅度达9%。其性能受通道噪声的影响也更小,如下图(c)。因此,采用STAR结构的SOFTS更具鲁棒性。

4.总结

尽管通道独立已被证明是提高多变量时间序列预测鲁棒性的有效策略,但通道间的相关性是进一步提升性能的重要信息。之前的方法在提取相关性时面临着模型复杂性和性能之间的两难困境。在本文中,我们通过引入Series-cOre Fused Time Series预测器(SOFTS)解决了这一难题。SOFTS在保持低复杂度的同时,实现了最先进的性能,并且通过创新的STar Aggregate-Redistribute(STAR)模块高效地捕捉了通道间的相关性。

本文转载自 圆圆的算法笔记,作者: 韩路