思维链缓存-Buffer of Thoughts,北大、UC伯克利、斯坦福最新研究大幅提升LLM推理

论文链接: https://arxiv.org/abs/2406.04271

代码链接: https://github.com/YangLing0818/buffer-of-thought-llm

近年来,大语言模型(LLMs)如GPT-4、PaLM和LLaMA在各种推理任务中展现了惊人的性能。然而,尽管这些模型在规模和性能上不断提升,它们在处理复杂推理任务时仍面临一定的挑战。

为了解决这些问题,我们提出了一种名为Buffer of Thoughts(BoT)的新型思维增强推理框架。BoT的核心在于引入一个轻量级的meta-buffer,其中存储了一系列从不同问题解决过程中提炼出的高层次thought-template。这些模板可以在解决类似问题时被检索和实例化,从而大幅提升推理的准确性、效率和鲁棒性。

Buffer of Thoughts框架

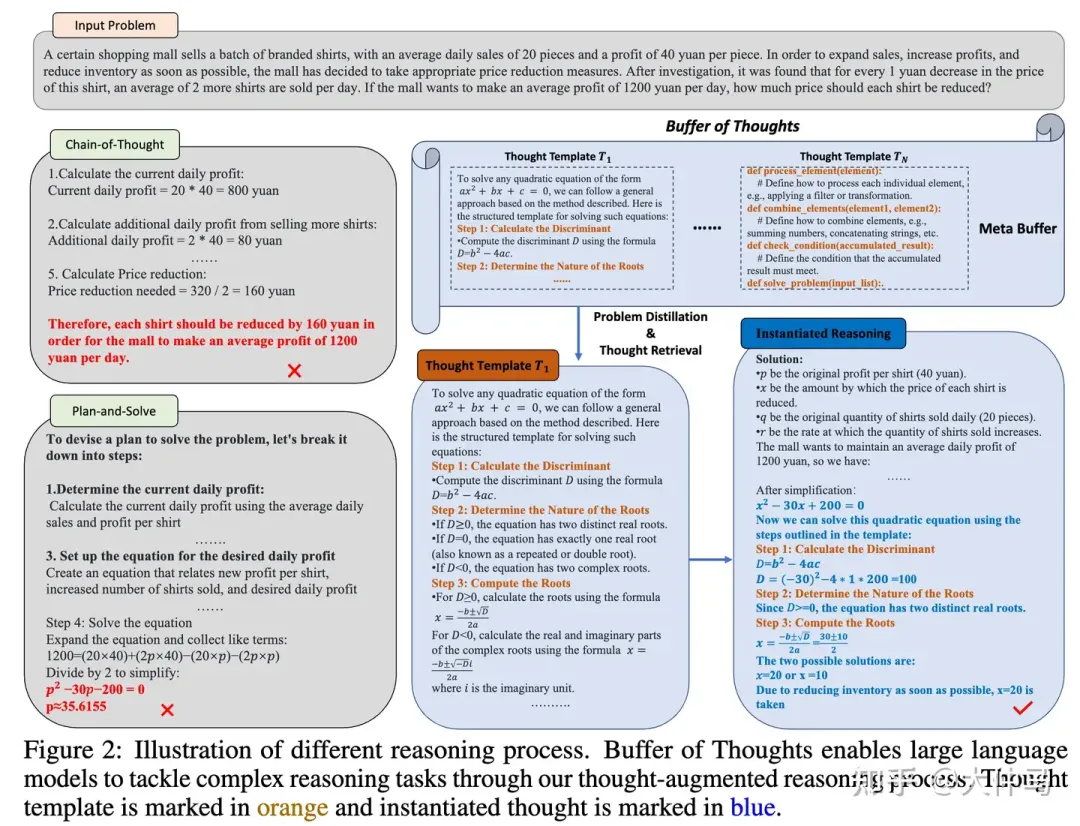

与以往的方法不同,我们创新性地提出了一个缓存思维链框架,如下图所示:

Buffer-of-Thought和之前prompt-based方法对比

- Problem Distiller:该模块负责从问题描述中提取关键信息和潜在约束,并将其转化为易于理解和推理的格式。通过这种方式,BoT能够更好地聚焦于问题的关键点,减少推理过程中的错误。

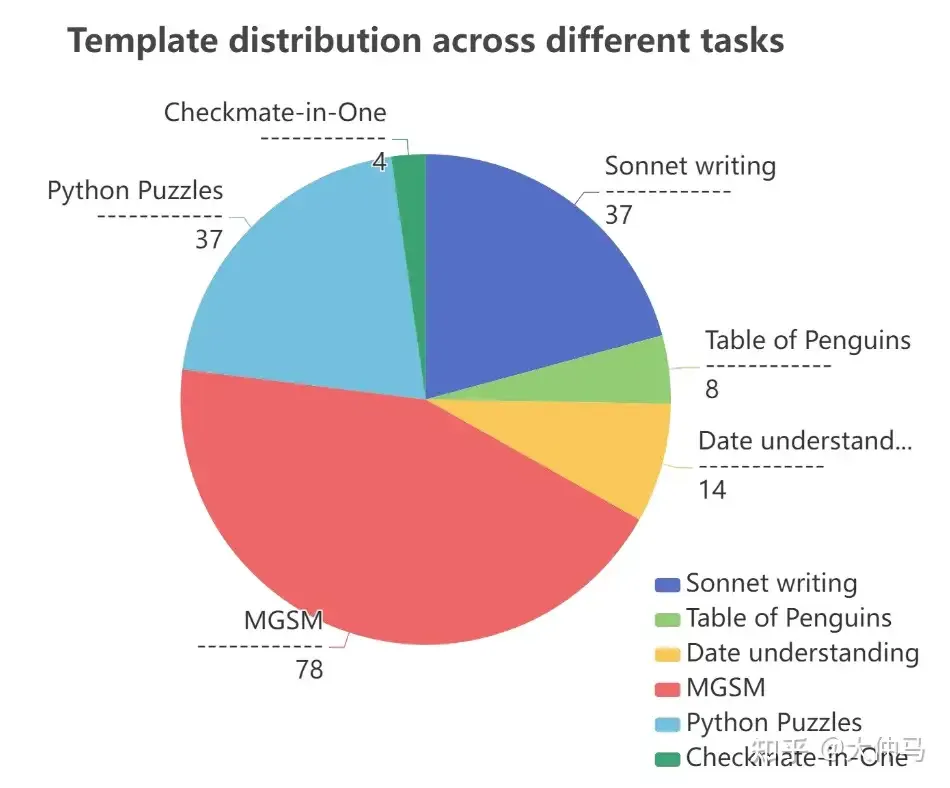

- Meta Buffer:该模块存储了大量的高层次思维模板,这些模板涵盖了文本理解、创造性语言生成、常识推理、数学推理、代码编程和应用调度等不同类别。每个模板都是从历史任务中提炼出来的,能够在相似任务中复用,从而提高推理的通用性和灵活性。

- Buffer Manager:该模块负责动态更新元缓冲区,从已解决的问题中提炼新的高层次思维模板,持续提升模型的推理能力。通过这种方式,BoT能够不断学习和进化,适应更多样化的任务需求。

在面对复杂的推理任务时,具体推理流程如下:

- 问题提炼:首先,BoT会利用problem distiller从问题描述中提取关键信息和潜在约束,并将其转化为易于理解和推理的格式。

- 模板检索:接下来,BoT会在meta buffer中检索与当前问题最相关的思维模板。这些模板包含了解决类似问题的高层次策略和步骤。

- 实例化推理:然后,BoT会根据检索到的thought template实例化具体的推理结构,并结合问题提炼器提取的信息进行推理。

- 动态更新:最后,BoT会利用buffer manager将新的问题解决过程提炼成高层次思维模板,并动态更新到元缓冲区中,以便未来复用

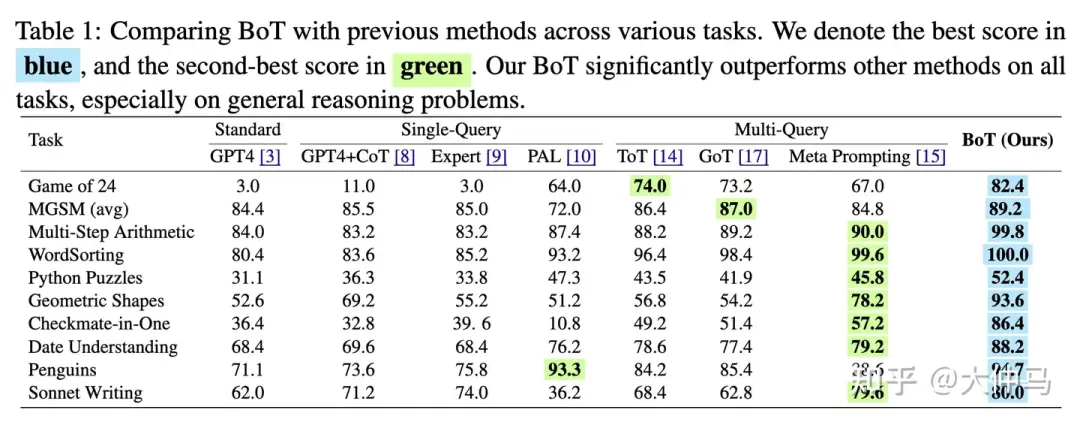

我们在10个具有挑战性的推理任务上进行了广泛的实验,包括Game of 24、Geometric shapes、Checkmate In One等。实验结果表明,BoT在这些任务上显著超越了现有的最先进方法。例如,在Game of 24上,BoT的准确率达到82.4%,相比于传统Chain-of-Thought提升了11%。在Geometric shapes任务上,BoT的准确率高达93.6%,相比于现有方法提升了20%。

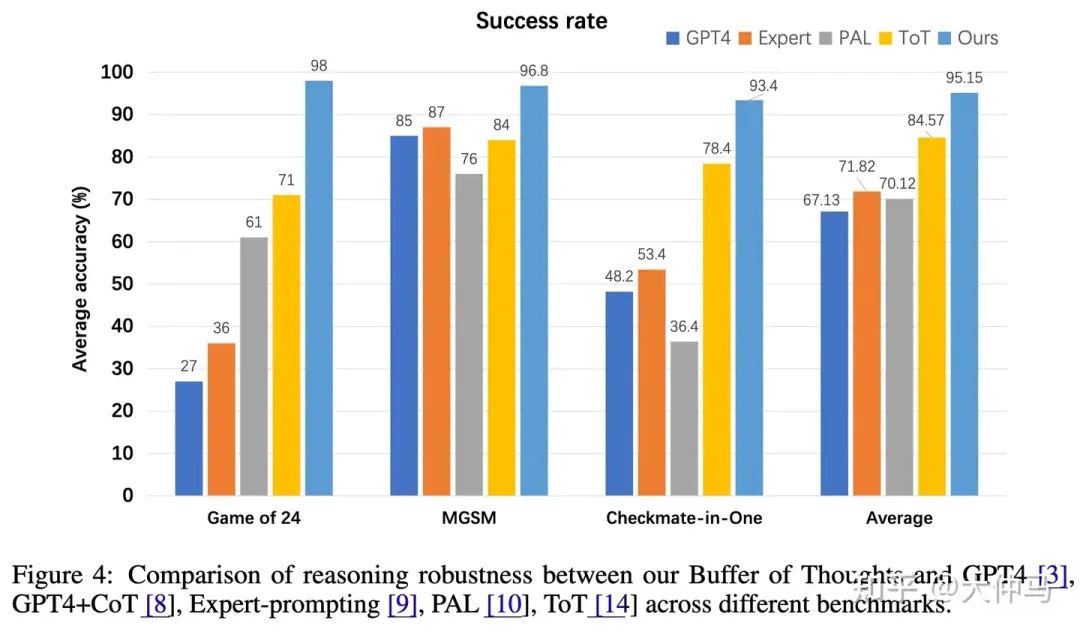

此外,BoT在推理效率和鲁棒性上也表现出色。与Multi-query prompting方法相比,**BoT的推理成本仅为其12%**,但推理准确率显著提升。同时,BoT在面对不同任务时表现出更高的成功率,平均成功率比第二好的方法高出10%。

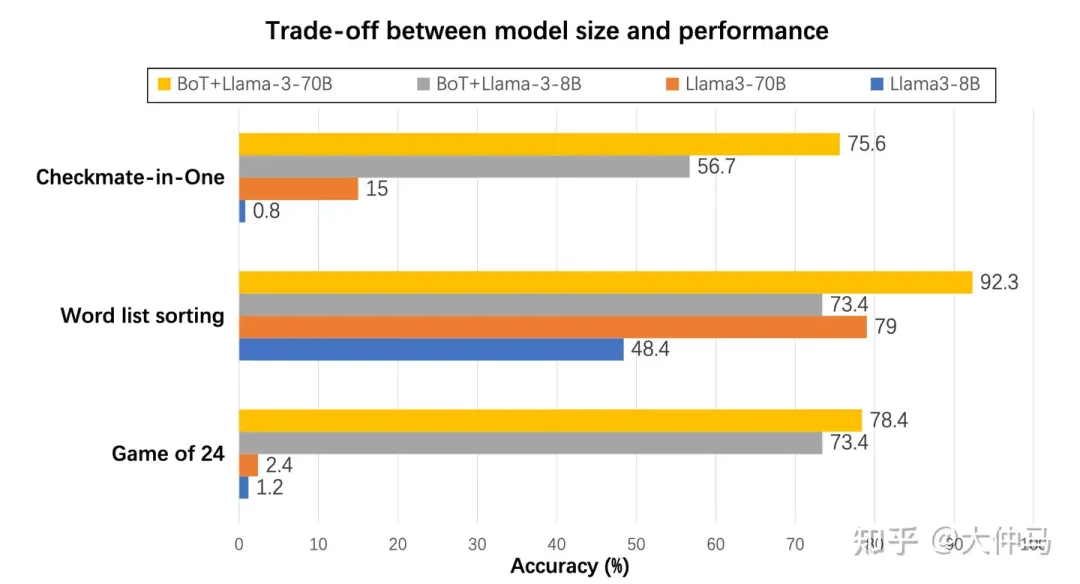

模型大小与性能的权衡分析

如下图所示,在Game of 24、word list sorting和Checkmate-in-One任务中,Llama3-8B和Llama-70B模型可能会产生较差的结果。然而,配备了我们的BoT后,这两个模型的准确率显著提高。值得注意的是,BoT+Llama3-8B在某些任务上可以超越单独使用Llama3-70B模型的结果。我们的BoT使得较小的模型能够展示出接近甚至超越较大模型的能力,显著缩小了它们之间的推理能力差距。此外,它大大减少了大型语言模型在处理复杂问题时所需的推理成本。

鲁棒性分析-相比较之前的思维链思维链,BoT的推理鲁棒性也更好:

BoT鲁棒性分析

时间成本分布分析

如图所示,我们测量了BoT推理框架中各组件在不同任务中的平均时间成本。提取任务信息和模板检索所需的时间相对较短,而实例化推理所需的时间较长。总体而言,考虑到不同组件的复杂性,我们的BoT在时间成本分布上实现了相对平衡,展示了BoT框架的效率。

BoT的提出为大语言模型的推理能力带来了革命性提升。通过利用预先积累的高质量思维模板,BoT不仅显著提高了推理准确性,还大幅降低了推理成本,为未来的智能推理系统提供了新的研究方向和应用前景。

本文转自 AI生成未来 ,作者:大仲马