效果超越ControlNet+IP-Adapter和FreeControl!Ctrl-X:可控文生图新框架(加州大学&英伟达)

文章链接:https://arxiv.org/pdf/2406.07540

项目链接:https://genforce.github.io/ctrl-x/

最近的可控生成方法,如FreeControl和Diffusion Self-guidance,为文本到图像(T2I)扩散模型带来了细粒度的空间和外观控制,而无需训练辅助模块。然而,这些方法针对每种类型的评分函数优化潜在embedding,并采用较长的扩散步骤,使生成过程耗时且限制了它们的灵活性和使用。

本文提出了Ctrl-X,这是一个简单的T2I扩散控制结构和外观的框架,无需额外的训练或引导。Ctrl-X设计了前馈结构控制,以实现与结构图像的结构对齐,并进行语义的外观迁移,以促进从用户输入图像进行外观迁移。

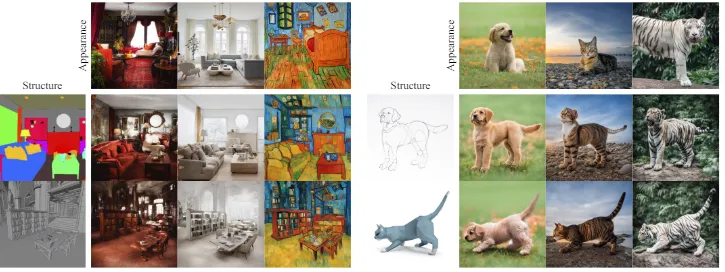

广泛的定性和定量实验说明了 Ctrl-X 在各种条件输入和模型 checkpoints 上的卓越性能。特别是,Ctrl-X支持任何形式的条件图像的新型结构和外观控制,与现有工作相比具有更高的图像质量和外观迁移,并为任何T2I和文本到视频(T2V)扩散模型提供即插即用功能。

总结本文的贡献如下:

- 提出了Ctrl-X,这是一个简单的即插即用方法,基于预训练的文本到图像扩散模型,在生成过程中提供结构和外观的解耦和 zero-shot 控制,无需额外的训练或指导。

- Ctrl-X 提出了第一个支持多个条件信号(结构和外观)和模型架构(例如文本到图像和文本到视频)的通用无需引导的解决方案。

- 本文的方法在条件对齐、文本图像对齐和图像质量方面与以往基于训练和指导的基线(如ControlNet + IP-Adapter和FreeControl)相比表现出更好的结果。

无导向结构和外观控制

Ctrl-X是一个通用框架,用于免训练、无引导、zero-shot的T2I扩散,具有结构和外观控制。给定结构图像和外观图像,Ctrl-X操作一个预训练的T2I扩散模型εθ,生成一个输出图像,该图像继承了的结构和的外观。

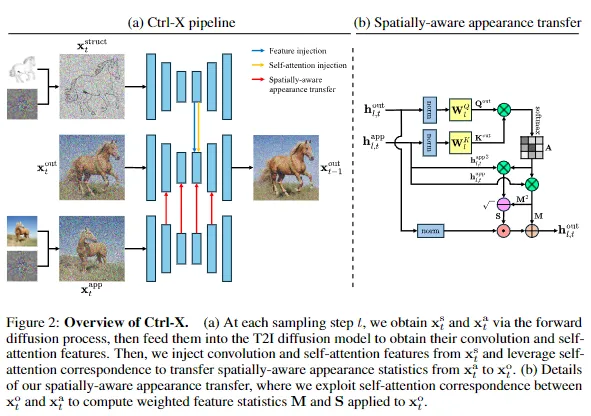

方法概述。方法如下图2所示,并概括如下:给定干净的结构和外观潜变量和,首先通过扩散正向过程直接获得噪声结构和外观潜变量和,然后从预训练的T2I扩散模型中提取它们的U-Net特征。在对输出潜变量进行去噪时,从注入卷积和自注意力特征,并利用自注意力对应关系将的空间感知外观统计信息传输到,以实现结构和外观控制。

前馈结构控制

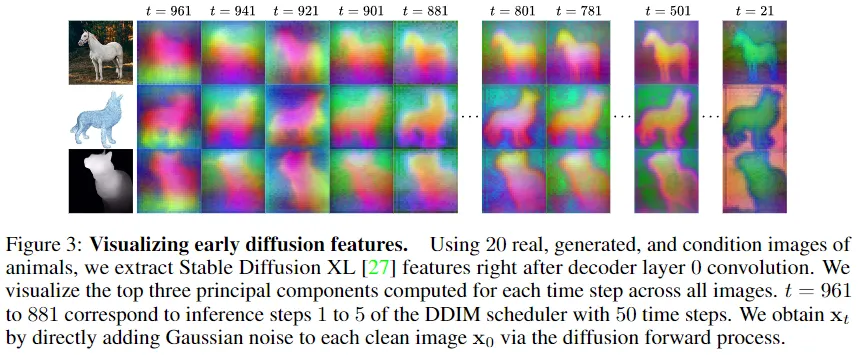

T2I扩散的结构控制需要将结构信息从转移到,特别是在早期时间步骤中。为此,初始化,并使用和随机采样的ε在方程1中通过扩散正向过程获得。受到扩散特征包含丰富布局信息的观察的启发,执行以下特征和自注意力注入:对于U-Net层l和扩散时间步t,令和为来自和的卷积块后的特征/激活,并且令和为来自和的自注意力块的注意力映射。然后,替换

与[36, 18, 24]相比,研究者们不执行反演,而是直接使用前向扩散(方程1)获得。观察到,通过前向扩散过程获得的即使在非常早期/高时间步中也包含足够的结构信息,如下图3所示。这也减少了由FreeControl观察到的基于反演的方法常见的外观泄漏。

对层应用特征注入,并对层进行自注意力注入,对于(归一化的)时间步τ,其中τ是结构控制计划。

空间外观迁移

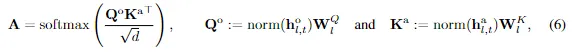

受先前定义外观为特征统计量的工作的启发,研究者们认为外观迁移是一项风格化任务。T2I扩散自注意力用注意力映射A转换值V,其中后者表示Q中的像素与K中的像素对应的方式。正如Cross-Image Attention所观察到的那样,当从每个图像的特征计算Q和K时,即使两个图像在结构上有显著差异,也可以表示两个图像之间的语义对应关系。因此,受AdaAttN的启发,提出了空间感知外观迁移,其中利用这种对应关系从生成自注意力加权的均值和标准差图到规范化:对于任何自注意力层l,让和分别为和的自注意力之前的扩散特征。然后,计算注意力映射

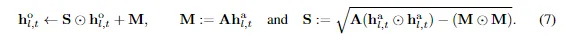

norm是应用于空间维度(hw)的。值得注意的是,我们首先对和进行归一化,以去除外观统计信息,从而隔离结构对应关系。然后,计算由A加权的的均值和标准差图M和S,并使-+用它们对进行归一化。

由和之间的结构对应加权的M和S是的空间感知特征统计量,它们被转移到。最后,像平常一样对执行层l的自注意力。对层应用外观迁移,对于(归一化的)时间步τ,其中τ是外观控制计划。

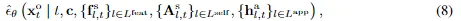

结构和外观控制。最后,用 Equation 2 中的 εθ 替换

在这里,,和 分别对应于用于特征注入的特征,用于自注意力注入的xst注意力映射,以及用于外观迁移的特征。

实验

研究者们提供了大量的定量和定性结果,以展示Ctrl-X在T2I扩散上的结构保留和外观对齐。

具有结构和外观控制的T2I扩散

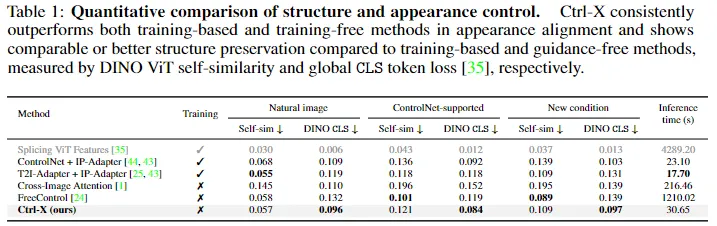

基线。对于基于训练的方法,ControlNet 和 T2I-Adapter学习了一个辅助模块,该模块将条件图像注入到预训练的扩散模型中,以实现结构对齐。然后,将它们与IP-Adapter(用于图像提示和外观迁移)相结合。Splicing ViT Features针对每个源-外观图像对从头开始训练一个 U-Net,以最小化它们的 DINO-ViT 自相似性距离和全局 [CLS] token损失。

(对于基于训练的基准不支持的结构条件,将其转换为边缘检测图。)对于基于引导的方法,FreeControl 通过从扩散特征子空间计算的反向传播得到的分数函数来强制结构和外观对齐。对于无指导的方法,Cross-Image Attention 操纵注意力权重以在保持结构的同时转移外观。尽可能在 SDXL v1.0 上运行所有方法,否则使用它们的默认基础模型。

数据集。本文的方法支持具有外观迁移和任意条件结构控制的T2I扩散。由于没有针对这种灵活任务的基准,创建了一个新数据集,包含256个不同的结构-外观对。结构图像包括31%的自然图像,49%的ControlNet支持的条件(如边缘检测、深度、分割),以及20%的野外条件(如3D网格、点云),外观图像是Web和生成图像的混合。使用模板和手动注释来制作结构、外观和输出文本提示。

评估指标。对于定量评估,报告了两个广泛采用的指标:DINO Self-sim 衡量了DINO-ViT 特征空间中结构图像和输出图像之间的自相似距离,较低的距离表示更好的结构保留;DINO CLS 衡量了外观图像和输出图像之间的DINO-ViT全局 [CLS] token之间的损失,较低的损失表示更好的外观对齐。

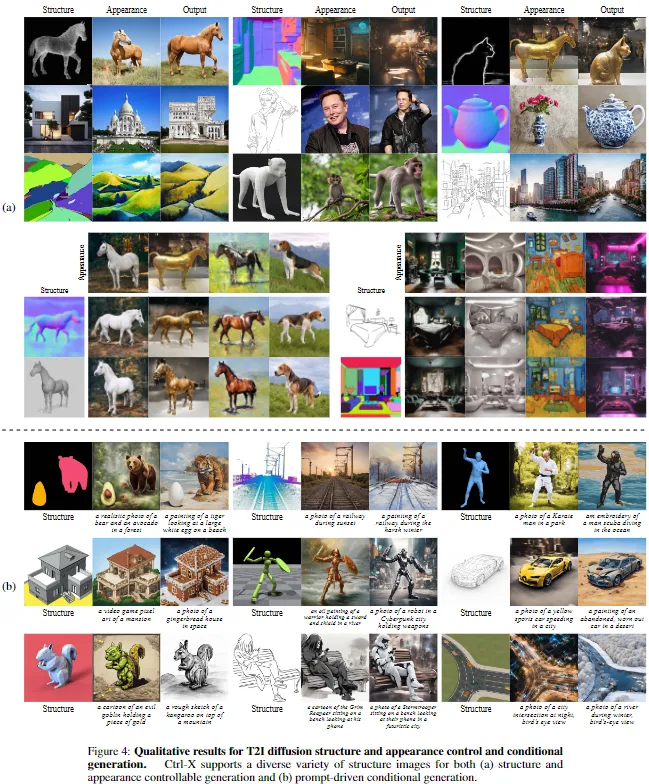

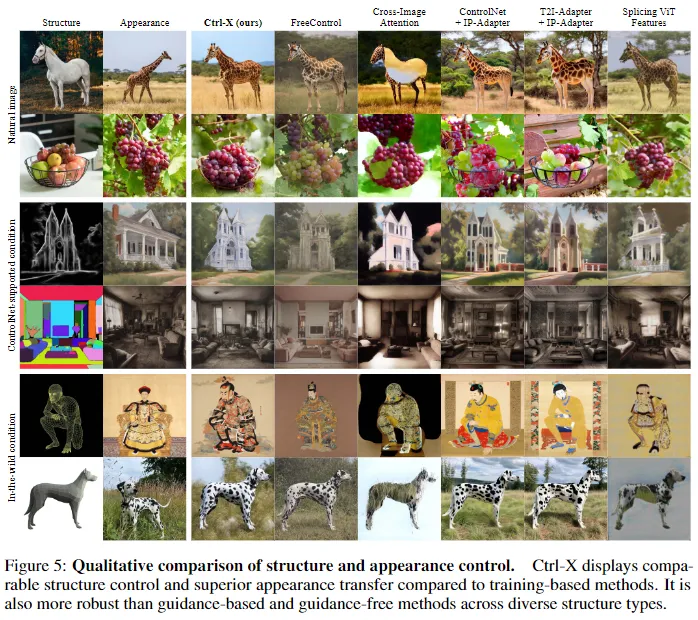

定性结果。如下图4和图5所示,Ctrl-X从各种结构图像中忠实地保留了结构,包括自然图像和ControlNet支持的条件(如HED、分割),以及野外条件(如线框、3D网格),这在先前的基于训练的方法中是不可能的,同时灵活地从外观图像中转移外观,具有语义对应关系。

与基线方法的比较。上图5和下表1将Ctrl-X与基线方法进行了比较。对于基于训练和基于指导的方法,尽管T2I-Adapter和FreeControl在结构保留方面更强(较小的DINO自相似距离),但它们通常难以实现忠实的外观迁移,并且产生更差的全局CLS损失,这在图5的第1行和第3行特别明显。由于基于训练的方法将结构控制模块(ControlNet和T2I-Adapter)与单独训练的外观迁移模块IP-Adapter 结合在一起,这两个模块有时会以牺牲外观迁移为代价产生冲突的控制信号(例如第1行)—对于ControlNet来说,也包括结构保留。对于FreeControl来说,其从提取的embedding中获得的外观评分函数可能无法充分捕捉更复杂的外观对应关系,再加上需要每个图像的超参数调整,导致输出的对比度较低,并且有时无法进行外观迁移(例如第4行)。此外,尽管Splicing ViT Features在表1中具有最佳的DINO自相似性和CLS分数,但图5显示,其输出图像通常模糊不清,并显示出与非自然图像的结构图像外观泄漏(例如第3行、第5行和第6行)。它之所以在基准测试中表现良好,是因为其每个图像的训练直接最小化了这两个指标。

与无指导基线Cross-Image Attention相比,该方法不够稳健,对结构图像的外观更为敏感,因为反演的结构潜变量包含了强烈的外观信息。这导致了结构对齐较差,并且经常出现外观泄漏或伪影(例如第6行),从结构到输出图像,导致更差的DINO自相似性距离和全局CLS损失。在实践中,发现Cross-Image Attention对其遮罩域非常敏感,并且有时无法产生具有跨模态对(例如线框到照片)的输出。

推理效率。研究者们研究了该方法与基线方法的推理时间,所有方法都使用基础模型SDXL v1.0,除了Cross-Image Attention(SD v1.5)和Splicing ViT Features(U-Net)。表1报告了使用单个NVIDIA A6000 GPU的平均推理时间。与基于训练的ControlNet(1.32倍)和T2I-Adapter(1.73倍)及IP-Adapter相比,Ctrl-X稍慢一些,但明显快于每个图像训练的Splicing ViT(0.0071倍)、基于指导的FreeControl(0.025倍)和无指导的Cross-Image Attention(0.14倍)。无训练和无指导方法达到了与基于训练的方法相当的运行时,表明了其灵活性。

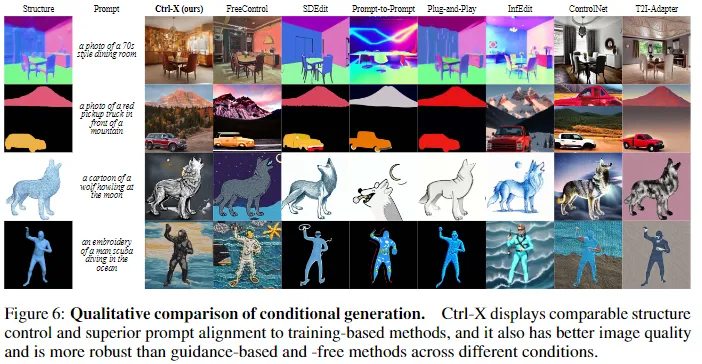

扩展到基于提示的条件生成。Ctrl-X还支持基于提示的条件生成,它生成一个符合给定文本提示的输出图像,并与结构图像对齐,如前面图4和下图6所示。受FreeControl的启发,Ctrl-X可以联合生成,基于文本提示以及,其中使用方程2从xat中获得xat−1进行去噪处理而没有控制。

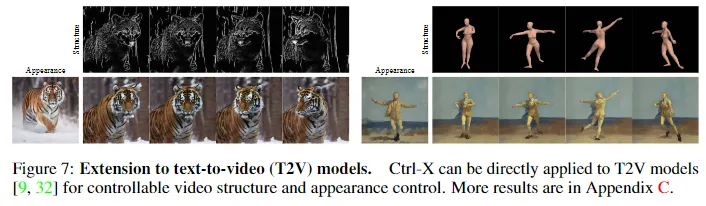

扩展到视频扩散模型

Ctrl-X无需训练、无需指导,并且运行时具有竞争力。因此,可以直接将方法应用于文本到视频(T2V)模型,如下图7所示。本文的方法将结构图像和输出视频之间的结构紧密对齐,同时从外观图像中传递时间一致的外观。

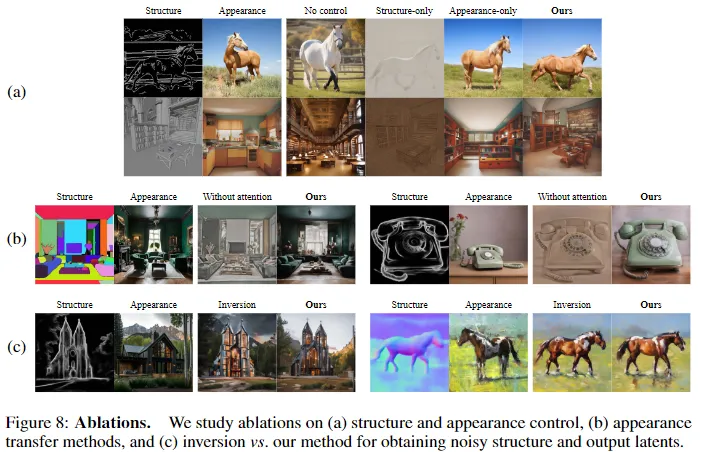

消融实验

控制效果。如下图8(a)所示,结构控制负责结构保留(仅外观 vs. 本文的方法)。此外,仅结构控制不能够隔离结构信息,会显示出强烈的结构图像外观泄漏和低质量的输出(仅结构 vs. 本文的方法),因为它仅仅注入了结构特征,这为外观控制创造了语义对应关系。

外观迁移方法。由于研究者们将外观迁移视为一项风格化任务,比较了带有和不带有注意力加权的外观统计量转移。没有注意力加权(相当于AdaIN)时,归一化是全局的,因此不能考虑外观图像和输出图像之间的语义对应关系,因此输出看起来对比度低。

反演效果。比较了DDIM反演和前向扩散(本文的方法)来获得和,如上图8(c)所示。在具有挑战性的条件下(左侧),反演显示了从结构图像中的外观泄漏,而在其他条件下(右侧)与本文的方法类似。考虑到反演成本和额外的模型推理时间,对于本文的方法来说,前向扩散是一个更好的选择。

结论

本文提出了Ctrl-X,这是一个针对任何T2I和T2V扩散模型的结构和外观控制的无需训练和无需引导的框架。Ctrl-X利用了预训练的T2I扩散模型的特征对应关系,支持任意的结构图像条件,适用于多种模型架构,并在与基于训练和指导的方法相比取得了竞争性的结构保留和更优异的外观迁移,同时享受了无需指导方法的低开销优势。

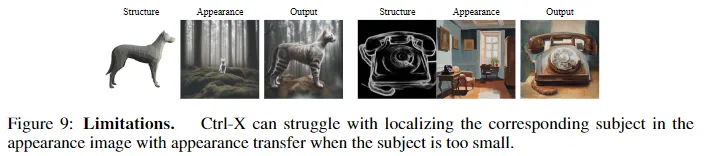

局限性。如下图9所示,Ctrl-X的关键局限性在于语义外观迁移方法可能无法捕捉到目标外观,特别是当实例很小时,因为特征图的低分辨率。希望本文的方法和发现能够揭示在生成模型变得更大、更强大时,控制生成方面的新可能性和研究。

更广泛的影响。Ctrl-X通过支持多种条件信号(结构和外观)和模型架构,而无需额外的训练或优化计算开销,使可控生成变得更加易于访问和灵活。然而,这种易用性也使得将预训练的T2I/T2V模型用于恶意应用(例如深度伪造)变得更加容易,特别是由于可控性使用户能够生成特定图像,从而引发了关于同意和为使用他们的工作作为条件图像而给予艺术家的信用的伦理关切。针对这些安全问题,T2I和T2V模型变得更加安全。同样,Ctrl-X可以继承相同的安全保障措施,其即插即用的性质允许开源社区审查和改进其安全性。

本文转自AI生成未来 ,作者:Kuan Heng Lin 等