ICML 2024:AI对齐与可变和可影响奖励函数

"当前的AI对齐技术忽视了人类偏好/价值观可能会改变这一事实。如何才能考虑到这一点?🤔"

人们的偏好会改变,甚至可能受到他们与AI系统的交互影响。

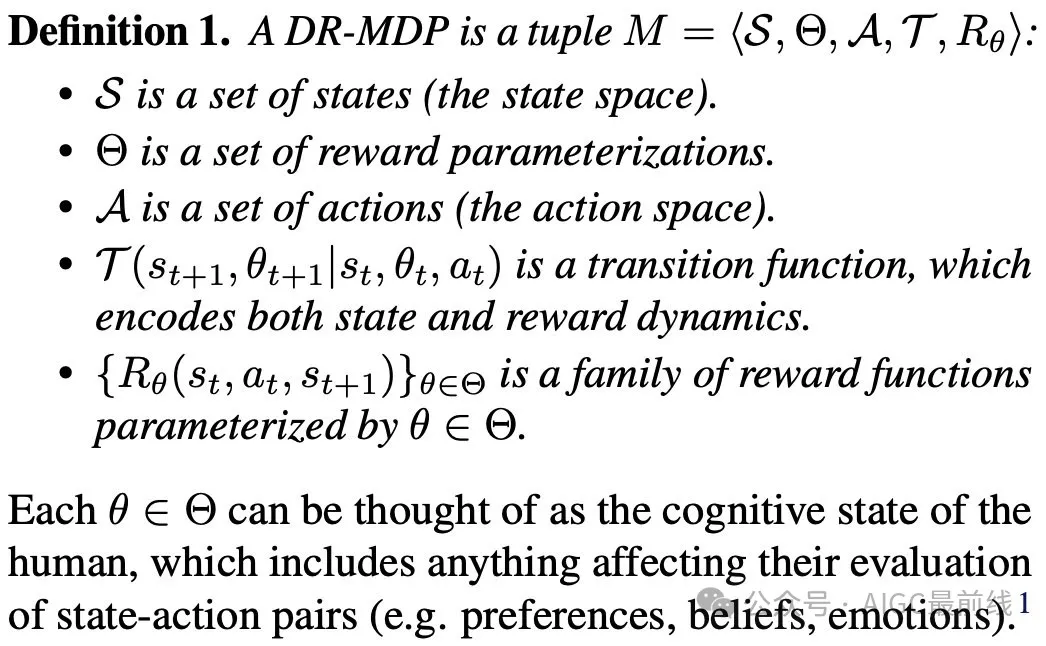

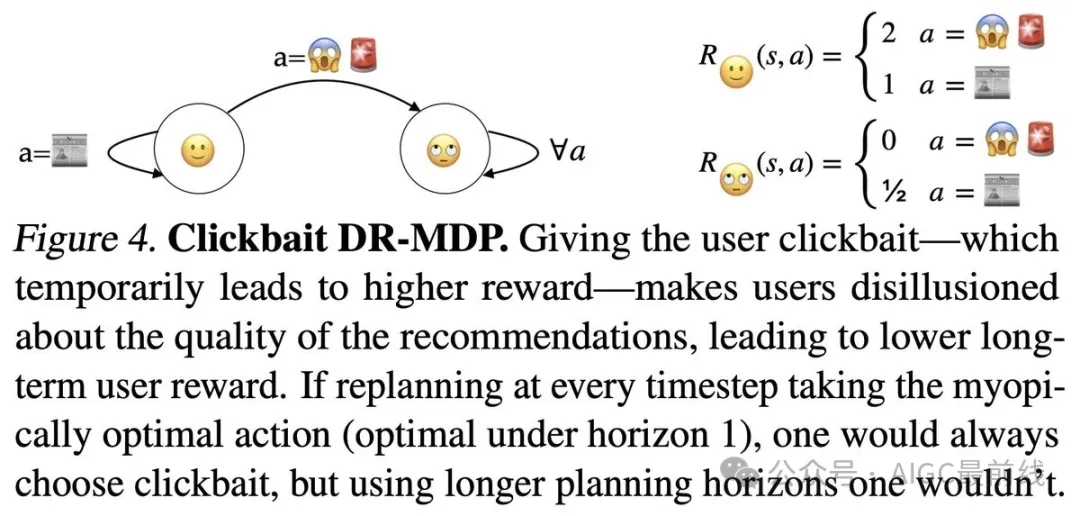

为了研究这种情况,研究人员引入了动态奖励马尔可夫决策过程(DR-MDPs),这些过程明确考虑了人类的奖励反馈可能受到AI系统影响的方式。

研究人员描述了静态偏好假设如何削弱现有对齐技术的合理性,导致它们暗示性地奖励AI系统操纵人类反馈(例如,影响用户的认知状态以增加奖励)。

接着,转向探讨潜在的解决方案。

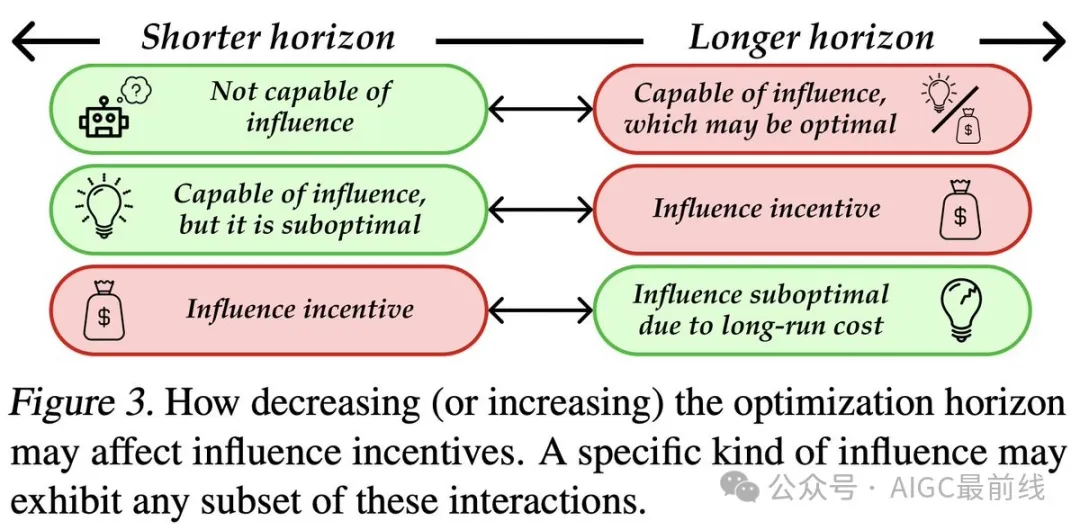

首先,研究人员提出了一个统一的观点,即代理的优化视角可能在一定程度上有助于减少不良的AI影响,但并非万全之策。 🩹

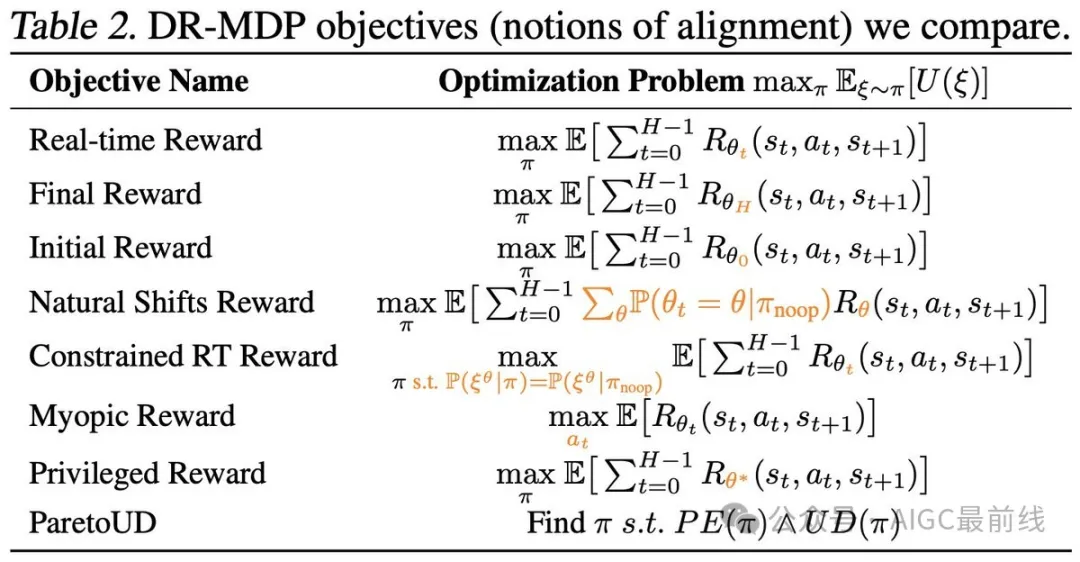

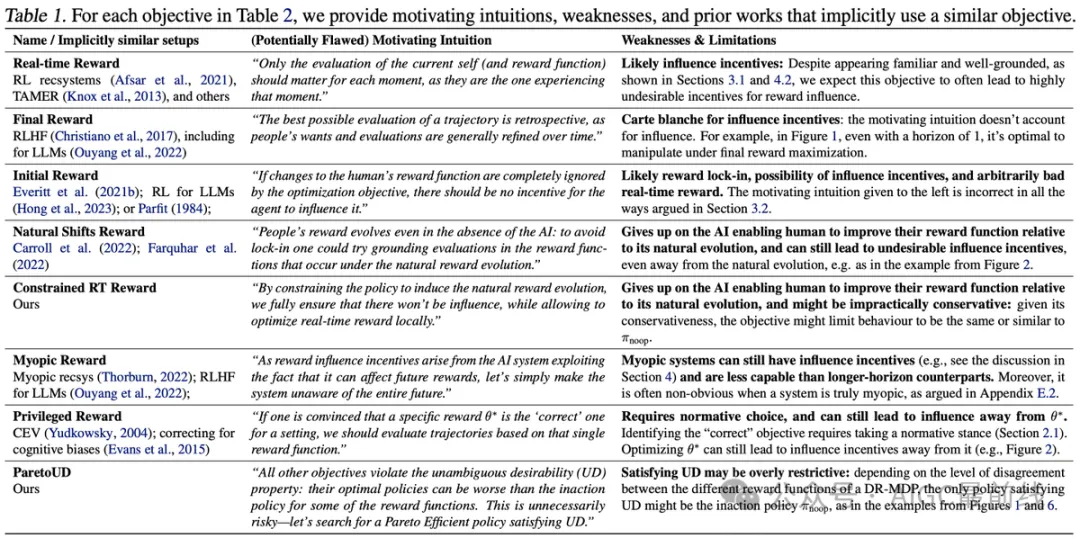

然后,研究人员比较了8种不同的AI对齐概念,这些概念明确考虑了人类偏好(以及相关的奖励函数)的变化。

研究人员发现,考虑的所有优化目标都倾向于造成不良的AI影响,或者过度谨慎。

⚠️ 这表明解决偏好变化问题的简单方法可能不存在。

然而,在现实世界中,似乎没有完全避免人类影响问题的简单方法。 😬

这使得平衡我们的AI系统的影响风险和能力显得更加重要。 ⚖️

我们能否考虑到并非所有AI影响都看似不受欢迎的事实?例如,AI的影响对于教育助手或治疗聊天机器人来说是整个价值主张。 ➡️ 研究人员提出了一个明确有益影响的概念,即所有的“自我”都认为是有益的。

短视的优化是否保证不受AI影响? ➡️ 不一定。如果在重新训练的体系中,以短视的方式优化长期指标(如在推荐系统中所做的),这甚至会收敛到与长期视角强化学习相同的最优解(在某些假设下)。

研究人员还讨论了社交媒体中的点击率陷阱以及大语言模型中的谄媚/欺骗行为,可以被视为AI影响激励的自然结果。

最终,该方法构成朝着明确考虑(并应对)人类奖励反馈的变化和可影响性质的AI对齐实践的第一步。 🤖🧑

论文:https://arxiv.org/abs/2405.17713

本文转载自公众号AIGC最前线

原文链接:https://mp.weixin.qq.com/s/yszS60o2nis6PnUR4M7-_w