Meta NLLB团队:将神经机器翻译扩展到200种语言,问鼎Nature! 原创

神经技术的发展为机器翻译的研究开辟了新的途径。如今,神经机器翻译(NMT)系统可以利用高度多语言能力,甚至进行零翻译,提供了有希望的语言覆盖和质量结果。然而,扩展高质量的NMT需要大量平行双语数据,而这些数据对世界上7000多种语言并不平等地可用。将重点放在改进相对较少数量的高资源语言的翻译质量上,将导致研究关注低资源语言的不足,从而加剧了数字不平等。为了打破这一模式,研究人员在这里介绍了No Language Left Behind——一个利用跨语言转移学习的单一大规模多语言模型。研究人员开发了一个基于稀疏门专家混合架构的条件计算模型,该架构是基于针对低资源语言量身定制的新挖掘技术获得的数据进行训练的。此外,团队设计了多种架构和训练改进方法,以抵消在数千个任务上进行训练时的过拟合。使用专门为此目的创建的工具评估了该模型在40,000个翻译方向上的性能——一个自动基准(FLORES-200),一个人工评估指标(XSTS)和一个涵盖模型中每种语言的毒性检测器。与以前的最先进模型相比,该模型在BLEU度量下平均达到了44%的翻译质量改进。通过展示如何将NMT扩展到200种语言,并且将此工作中的所有贡献免费提供给非商业用户使用,该工作为通用翻译系统的发展奠定了重要的基础。

最近,神经机器翻译(NMT)的出现推动了翻译技术的发展,但其好处并不均衡分布。绝大多数改进主要受益于高资源语言,许多低资源语言被落下了。为了研究目的,研究人员将高资源语言定义为至少具有100万句对齐文本数据(或双语文本)的语言。这种差距主要可以归因于数据缺口:NMT模型通常需要大量数据才能产生高质量的翻译,而这些数据在低资源语言中并不可用。"无语言被遗忘"(NLLB-200)项目旨在通过利用以前未知的方法构建具有跨语言转移能力的大规模多语言模型,使相关语言能够相互学习,从而克服这一限制。

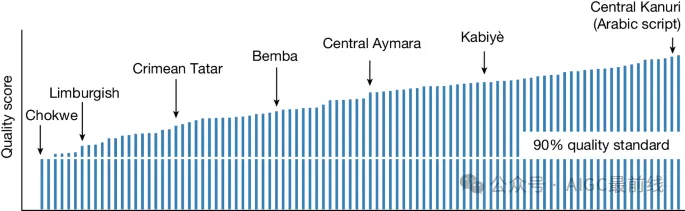

目前已广泛认可,多语言模型相比双语模型表现出有希望的性能改进。然而,一个问题仍然存在,即大规模多语言模型是否能够在不损害质量的情况下表示数百种语言。结果表明,在机器翻译中增加支持的语言数量并保持输出质量并不是互相排斥的努力。最终模型包括200种语言,低资源语言数量是高资源语言数量的三倍,平均性能比之前的最先进系统提高了44%。本文介绍了实现这一目标所使用的一些最重要的数据收集、建模和评估技术。

首先,与高资源语言相比,低资源语言的训练数据在成本和物流方面都具有挑战性。公开可用的数字资源或者数量有限,或者对于自动化系统来说难以检测(尤其是在大型公共网络数据集,如CommonCrawl中)。无论是否需要收集关键质量的人工翻译种子数据,足够的数据获取依赖于大规模数据挖掘和单语数据流水线。后者的技术通常受到噪声和偏差的影响,因此验证它们生成的数据集的质量是繁琐的。在NLLB-200中,研究人员展示了一种基于蒸馏的句子编码技术LASER3,它有助于有效地挖掘低资源语言的平行数据。

其次,在建模方面,研究人员使用一系列的种子、挖掘、开源和回译数据集来训练多语言条件计算模型(更具体地说,稀疏门控专家混合模型),这些模型可以在相关语言之间实现跨语言转移,而不增加无关语言之间的干扰。研究人员展示了如何在跨语言转移和干扰之间取得最优的性能平衡,并提高低资源语言的性能。

最后,为了进行质量评估,研究人员创建了FLORES-200,这是一个大规模多语言基准,可以衡量NLLB-200模型涵盖的近40,000个翻译方向的翻译质量。除了自动评估指标,还创建了跨语义文本相似度(XSTS)和毒性评估(ETOX)。XSTS是一个人工评估协议,可以在不同语言之间提供一致性;ETOX是一个使用毒性词汇列表检测翻译中添加毒性的工具。

除了创建这些模型,研究人员还反思了NLLB的潜在社会影响。为了增强工作在服务低资源语言社区方面的实际适用性,Meta将在此努力中描述的所有基准、数据、代码和模型作为资源免费提供给非商业用户使用,地址如下:

https://github.com/facebookresearch/fairseq/tree/nllb

论文地址:https://www.nature.com/articles/s41586-024-07335-x

本文转载自公众号AIGC最前线

原文链接:https://mp.weixin.qq.com/s/1HLOGEd3MjtS3WPjht1ogw