3D语言模型的新突破:解锁虚拟现实中的'幻觉'问题

随着人工智能技术的飞速发展,3D语言模型(3D-LLMs)已成为研究的热点,它们在理解和生成语言指令方面展现出了巨大的潜力。这些模型不仅能够处理文本信息,还能理解和操作三维空间中的物体,这对于发展能够与物理世界互动的智能系统至关重要。

3D语言模型的核心在于其能够将语言与三维场景紧密结合。传统的大型语言模型(LLMs)如GPT和BERT等已经在文本处理方面取得了显著成就,但它们主要处理的是二维图像和文本数据。而3D-LLMs则是在此基础上的进一步扩展,它们能够处理和理解三维点云数据,从而在空间理解和物体操作方面提供更为丰富的信息。

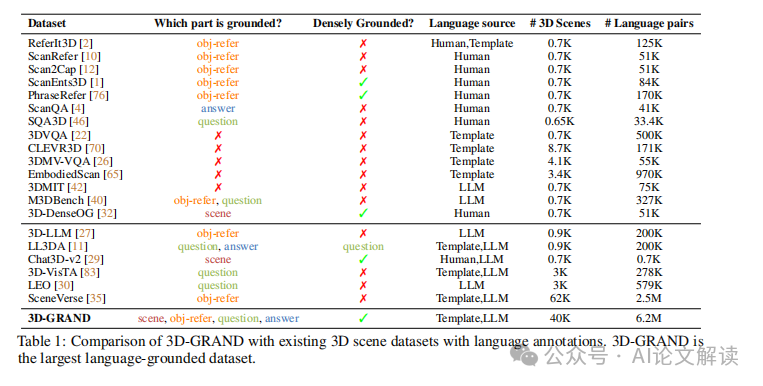

然而,3D-LLMs的发展仍面临一些挑战,尤其是在数据集的构建和模型训练方面。目前,与二维图像和文本配对的数据集已经非常丰富,但专门针对三维场景和语言指令的大规模数据集还相对较少。这限制了模型在理解复杂三维环境中的能力。

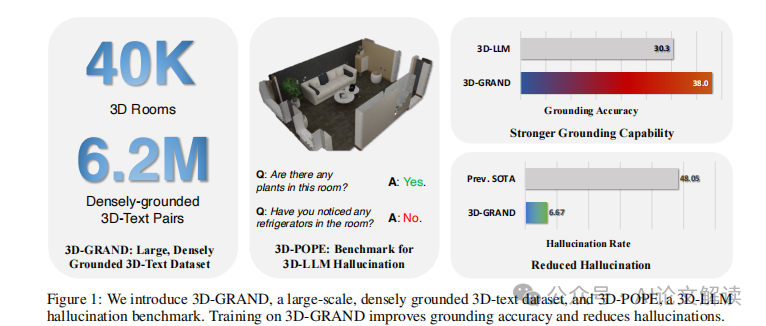

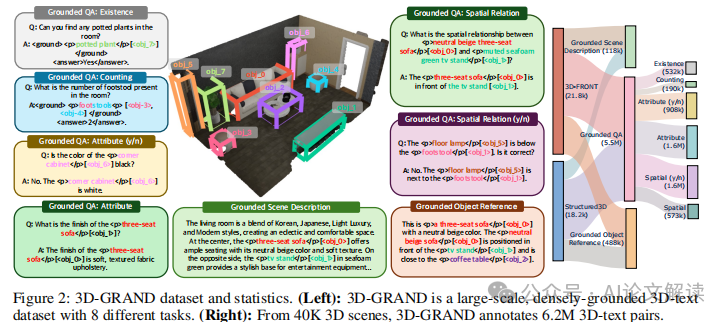

为了解决这一问题,研究人员开发了3D-GRAND数据集,这是一个创新的大规模数据集,包含了超过40,000个家庭场景和620万个与场景密切相关的语言指令。这一数据集的推出,极大地推动了3D-LLMs在空间理解和语言生成方面的研究,使模型能够更好地理解和描述复杂的三维环境。

此外,为了系统评估3D-LLMs在处理虚构对象(即“幻觉”问题)方面的表现,研究人员还提出了3D-POPE基准测试。这一测试旨在通过一系列的评估任务,检测模型在确认三维场景中对象存在与否方面的准确性。

通过这些先进的数据集和评估工具,3D语言模型正在逐步克服早期的限制,展现出在多种实际应用中的巨大潜力,例如在机器人技术、虚拟现实和自动化系统中的应用。这些研究不仅推动了人工智能技术的发展,也为我们提供了一个全新的视角,来理解和创造与三维世界互动的智能系统。

论文信息及下载链接在文末

3D-GRAND数据集的创新与重要性

1. 数据集规模与密集地面实体关联

3D-GRAND数据集是一个开创性的大规模数据集,包含40,087个家庭场景和6.2百万个与场景密切相关的语言指令。这种密集的短语到对象的地面实体关联是此数据集的一大特色,它极大地丰富了3D语言模型的训练材料,使得模型在理解和生成与3D环境相关的语言时更为准确和自然。

2. 提高模型性能与减少幻觉

通过在3D-GRAND上进行指令调整训练,显著提高了3D语言模型的地面实体关联能力,并有效减少了模型在生成语言时的幻觉现象。这一点在模型训练和评估中表现尤为突出,通过系统的实验验证,使用3D-GRAND数据集训练的模型在多个基准测试中都显示出优越的性能。

3. 支持多样化的语言任务

3D-GRAND不仅仅支持基本的对象引用任务,还包括空间推理、场景理解等复杂的语言任务。这种多样化的任务支持使得3D-GRAND能够更全面地评估和训练3D语言模型,推动模型在更广泛的应用场景中的部署和使用。

4. 高质量的注释和可扩展性

3D-GRAND的语言注释经过严格的人工评估,确保了数据的高质量和多样性。此外,该数据集的设计考虑到了未来的可扩展性,支持从仿真数据到真实世界数据的转换,这为使用合成数据进行3D文本理解提供了新的可能性。

5. 早期信号显示有效的仿真到现实的转换

初步结果表明,通过在3D-GRAND上训练的模型能够有效地转移到真实世界的3D扫描数据上,这为未来低成本、可持续的3D数据扩展提供了有力的早期信号。

总之,3D-GRAND数据集的引入不仅解决了现有3D语言模型训练数据不足的问题,还通过提供大规模、高质量和密集地面实体关联的数据,极大地推动了3D语言模型在理解和交互3D环境方面的研究和应用。

3D-POPE基准测试:评估3D语言模型的幻觉行为

在3D语言模型(3D-LLMs)的研究和应用中,一个重要的挑战是如何准确地识别和处理模型在处理3D场景时可能出现的“幻觉”行为,即模型错误地识别或生成不存在的对象。为了系统地评估这一行为,我们引入了一个全新的基准测试——3D-POPE(3D Polling-based Object Probing Evaluation)。

1. 3D-POPE基准测试的设计

3D-POPE旨在通过一系列标准化的测试来评估3D-LLMs在3D场景中对对象存在性的判断能力。这些测试包括向模型提出关于场景中某个对象是否存在的问题,并根据模型的是或否回答来评估其性能。

为了构建这一基准测试,我们从ScanNet数据集中挑选了一组场景,并使用ScanNet200的语义类别来定义测试对象。我们特别关注模型对于对象存在性的判断能力,因此设计了一系列包含存在和不存在对象的问题,以确保测试的全面性和平衡性。

2. 采样策略

在构建3D-POPE测试集时,我们采用了三种不同的采样策略来选择负样本(即不存在的对象):

- 对抗性采样:对于场景中已确认存在的每一个对象,我们选择与之共现频率最高的不存在对象作为对抗样本。这种方法有助于测试模型在复杂场景中的鲁棒性。

这些策略的设计旨在挑战模型的鲁棒性,评估其在不同级别的对象幻觉情况下的表现。

3. 性能评估指标

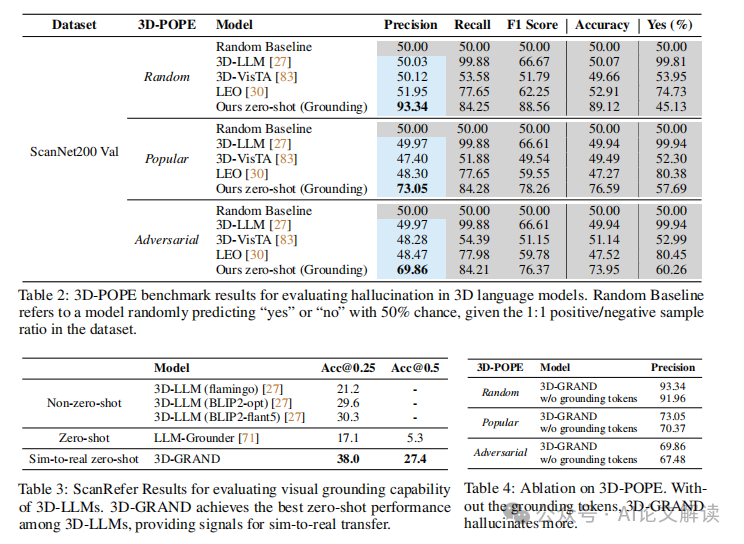

我们使用几个关键指标来评估3D-LLMs在3D-POPE基准测试上的表现,包括精确度(Precision)、召回率(Recall)、F1分数、准确率(Accuracy)以及错误肯定率(Yes %)。这些指标综合反映了模型在确认对象存在性方面的能力和可靠性。

4. 公开排行榜

为了促进研究社区的公平比较和合作,我们设立了一个公开的3D-POPE排行榜,研究人员可以提交他们的3D-LLM结果,并与其他最先进模型进行比较。排行榜将根据上述评估指标显示每个模型的性能,为研究人员提供一个透明和标准化的评估平台。

通过3D-POPE基准测试,我们希望能够深入了解3D-LLMs在处理复杂3D场景时的对象幻觉问题,为未来研究提供指导,并推动更可靠和准确的3D语言模型的发展。

实验设计与结果分析

1. 实验设计

在本研究中,我们引入了一个全新的大规模数据集3D-GRAND,专为3D环境中的语言指令调整而设计。该数据集包含40,087个家庭场景,与6.2百万个密集地与场景语言指令相结合。为了评估3D语言模型(3D-LLMs)在处理这些数据时的表现,我们设计了一系列实验,旨在测试模型在不同数据规模下的性能,并探索模型训练的有效性。

我们还引入了一个新的基准测试3D-POPE(3D Polling-based Object Probing Evaluation),用于系统地评估3D-LLMs在对象幻觉方面的表现。这一基准测试通过提出存在性问题来评估模型的回答,从而检测模型是否会产生幻觉——即错误地认为某个不存在的对象存在于场景中。

2. 结果分析

2.1 3D-GRAND数据集的影响

使用3D-GRAND进行训练的结果显示,该数据集显著提高了3D-LLMs的地面真实性(grounding)能力,并有效减少了幻觉现象。具体来说,模型在3D-POPE基准测试中的表现优于所有基线模型,尤其是在随机抽样策略下,模型展示了93.34%的精确度和89.12%的准确率。这一结果强调了密集地面数据对于提高模型性能的重要性。

2.2 3D-POPE基准测试

在3D-POPE基准测试中,我们采用了多种抽样策略来评估模型对于不存在对象的识别能力。结果表明,尽管在更具挑战性的抽样设置(如流行和对抗样本)中表现存在下降,3D-GRAND模型仍然能够维持较高的性能,显示出其鲁棒性。

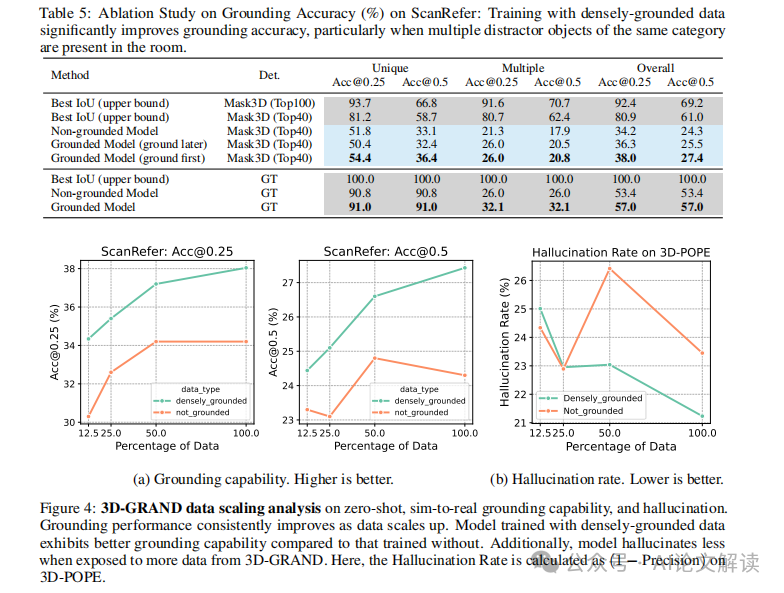

2.3 数据规模与模型性能的关系

我们的实验还揭示了数据规模与模型性能之间的正相关关系。随着训练数据的增加,模型在真实世界3D扫描数据上的表现也随之提高,这为使用合成3D场景数据进行训练提供了一种可行的策略,可能会在未来降低成本并提高模型的可访问性和扩展性。

3. 模拟到真实的转换

我们的研究结果提供了模拟到真实转换的初步信号,表明在大规模合成数据上训练的模型能够有效地迁移到真实世界的3D扫描中。这一发现对于未来3D-LLMs的应用和发展具有重要意义,可能会推动3D视觉语言模型在更广泛的实际应用中的部署。

通过这些实验和分析,我们不仅验证了3D-GRAND数据集的有效性,也展示了大规模、密集地面数据在提升3D语言模型性能中的关键作用。我们相信这些发现将为未来的研究提供宝贵的指导,并推动3D-LLMs在各种实际应用中的进一步发展。

模型的消融研究与深入分析

在深入分析和消融研究中,我们关注的核心是评估3D-LLMs在处理3D场景时的性能,尤其是在减少幻觉(hallucination)和增强语言与3D场景的对应(grounding)方面的能力。通过对3D-GRAND数据集的使用,我们能够系统地评估模型在这些关键任务上的表现。

1. 消融研究的设计与实施

消融研究的目的是通过系统地移除或修改模型的某些部分,来理解这些部分对模型性能的具体影响。在我们的研究中,特别关注了以下几个方面:

- 数据密集度的影响:我们比较了在不同密集度的数据训练下,3D-LLMs的性能变化。结果表明,使用密集标注的数据(如3D-GRAND)可以显著提高模型的地面真实性(ground truth fidelity)和减少幻觉现象。

- 输入数据的变化:通过改变输入数据的类型(如只使用文本指令而不是结合3D场景信息),我们评估了3D场景理解对模型性能的影响。

- 模型结构的变化:我们尝试了不同的模型架构,包括更改层的深度和宽度,以及引入或去除特定的功能模块,如对象检测器和语义分割器。

2. 深入分析的关键发现

通过消融研究,我们得到了一些关键的发现,这些发现帮助我们更好地理解3D-LLMs在处理3D语言任务时的行为:

- 数据密集度对性能的显著影响:在3D-GRAND这样的大规模、密集标注的数据集上训练的模型,在减少幻觉和提高语言地面真实性方面表现更好。这强调了高质量、密集标注数据在训练有效的3D-LLMs中的重要性。

- 模型对3D场景信息的依赖性:输入数据中包含的3D场景信息对模型的性能至关重要。模型在没有3D场景信息的情况下性能显著下降,这表明了3D信息在理解和生成与场景相关的语言中的核心作用。

- 模型结构的优化:通过调整模型结构,我们发现某些结构变化(如增加层的深度)可以改善模型的细节理解能力,而其他变化(如去除语义分割器)则可能导致性能下降。

这些发现不仅增强了我们对3D-LLMs行为的理解,也为未来研究提供了 valuable insights,特别是在设计更高效和准确的模型结构以及创建更有效的训练数据集方面。

结论与未来展望

在本研究中,我们介绍了3D-GRAND和3D-POPE两个创新的资源,它们为3D语言模型(3D-LLMs)的发展提供了重要的支持。通过这些资源,我们不仅显著提高了模型在理解和生成与3D场景密切相关的语言指令的能力,还有效减少了模型在生成过程中的幻觉现象。

1. 主要成果

我们的研究首次在大规模的数据集上实现了3D场景与语言指令的密集配对,这在之前的研究中是未曾有过的。3D-GRAND数据集包含超过40,000个家庭场景和620万条语言指令,这些指令与场景中的具体对象紧密相关联。使用这一数据集进行训练的3D-LLMs在减少幻觉和提高语言地面真实性(grounding)方面表现出色。

此外,我们还开发了3D-POPE基准测试,这是一个系统评估3D-LLMs在对象幻觉方面表现的工具。通过这一基准测试,我们可以更公平、更系统地比较不同模型的性能,并进一步理解模型在处理复杂3D场景时的行为。

2. 未来的研究方向

尽管我们取得了一定的进展,但在3D-LLMs的研究领域,仍有许多问题需要解决。首先,尽管3D-GRAND数据集的规模已经很大,但与现实世界的复杂多变相比,它仍然有限。未来的工作可以探索如何进一步扩展这种类型的数据集,包括更多种类的3D场景和更复杂的语言指令。

其次,从模拟数据到真实世界数据的迁移仍是一个挑战。虽然我们的模型在模拟数据上表现良好,但如何确保这些模型在现实世界中同样有效仍需进一步研究。这可能涉及到新的模型架构或是更精细的训练策略。

最后,随着技术的发展,我们预见到3D-LLMs将在更多实际应用中发挥作用,如自动驾驶、机器人导航等领域。因此,如何将这些模型有效地集成到具体的应用场景中,也是未来研究的一个重要方向。

通过3D-GRAND和3D-POPE,我们为3D-LLMs的研究和应用提供了坚实的基础。我们期待未来的研究能在此基础上,继续推动3D理解和交互技术的边界,最终实现更智能、更自主的机器人和虚拟代理人。

标题: 3D-GRAND: Towards Better Grounding and Less Hallucination for 3D-LLMs

作者: Jianing Yang, Xuweiyi Chen, Nikhil Madaan, Madhavan Iyengar, Shengyi Qian, David F. Fouhey, Joyce Chai

机构: University of Michigan, New York University

链接: https://3d-grand.github.io/

本文转载自 AI论文解读,作者:柏企