【LLM】ShareGPT4Video:借助更优质的标题提升视频理解和生成能力

一、结论写在前面

这篇论文来自:中国科学技术大学、香港中文大学、北京大学、上海 AI Lab。

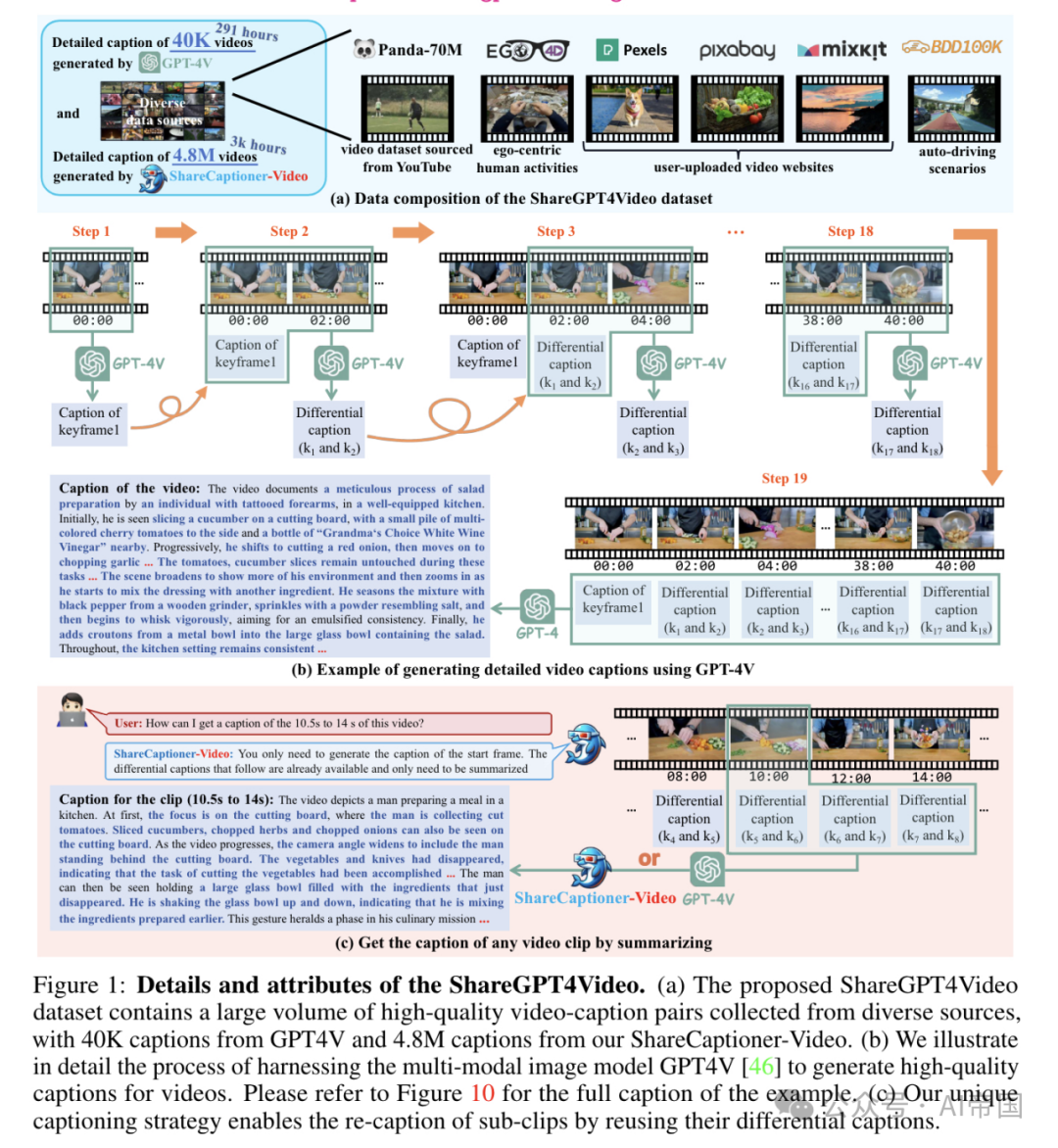

论文推出了ShareGPT4Video系列,旨在通过密集且精确的标注促进大型视频语言模型(LVLMs)的视频理解和文本到视频模型(T2VMs)的视频生成。该系列包括:

1)ShareGPT4Video,包含4万个GPT4V标注的密集视频标注,这些视频具有不同长度和来源,通过精心设计的数据过滤和标注策略开发。

2)ShareCaptioner-Video,一个高效且能力强大的任意视频标注模型,由其标注了480万个高质量美学视频。

3)ShareGPT4Video-8B,一个简单却卓越的LVLM,在三个前沿视频基准测试中达到了最先进(SOTA)性能。

为此,论文摒弃了不可扩展且成本高昂的人工标注者,发现使用GPT4V对视频进行标注,采用简单的多帧或帧连接输入策略,会导致细节不足且有时时间上混乱的结果。论文认为设计高质量视频标注策略的挑战在于三个方面:1) 帧间精确的时间变化识别。2) 帧内详细内容描述。3) 任意长度视频的帧数可扩展性。

为此,论文精心设计了一种差异视频标注策略,该策略稳定、可扩展且高效,适用于生成任意分辨率、宽高比和长度的视频标注。基于此,论文构建了ShareGPT4Video,包含4万个高质量视频,涵盖广泛类别,其标注涵盖丰富的世界知识、物体属性、摄像机运动,以及关键的、详细且精确的事件时间描述。基于ShareGPT4Video,论文进一步开发了ShareCaptioner-Video,一个能够高效生成任意视频高质量标注的优秀标注器。

论文通过它标注了480万个具有美学吸引力的视频,并在10秒文本到视频生成任务中验证了其有效性。对于视频理解,论文验证了ShareGPT4Video在几种当前LVLM架构上的有效性,并展示了论文卓越的新LVLM ShareGPT4Video-8B。所有模型、策略和标注将开源,论文希望该项目能作为推动LVLMs和T2VMs社区进步的关键资源。

二、论文的简单介绍

2.1 论文的背景

尽管视频内容具有丰富的语义和时间信息,但现有数据中视频通常只配有简短的描述。这些简短的描述限制了对视频的深入理解以及视频生成的可控性。虽然图像-文本对话和文本到图像生成任务中已认识到详细描述的重要性,但在视频理解和生成方面类似的努力仍然不足。

然而,创建大规模、高质量的视频描述是一项挑战性任务。即使是人类,为长视频生成详细的描述也是复杂且耗时的,这阻碍了大规模的标注工作。当前的开源大规模视觉语言模型(LVLMs)缺乏这种能力,而闭源API尚不支持视频输入。

论文认为,制定有效的视频描述策略的挑战源于三个基本方面:1) 帧间精确的时间变化识别:时间维度将视频与图像区分开来。不精确的时间描述会显著降低视频描述的质量,并在训练模型时引起混淆。2) 帧内详细内容的描述:详细描述对于图像与文本模态之间的对齐至关重要,对于视频-文本对齐也同样重要。3) 任意长度视频的帧数可扩展性:在实际应用中,视频的长度差异很大。理想的描述策略应能适应这种变化,并为任何长度的视频生成适当的描述。

为此,论文提出了差分滑动窗口描述策略(DiffSW),该策略稳定、可扩展且高效,适用于为任意视频生成描述。DiffSW的核心理念是将所有帧到描述的任务转化为差分描述任务。

2.2 ShareGPT4Video数据集

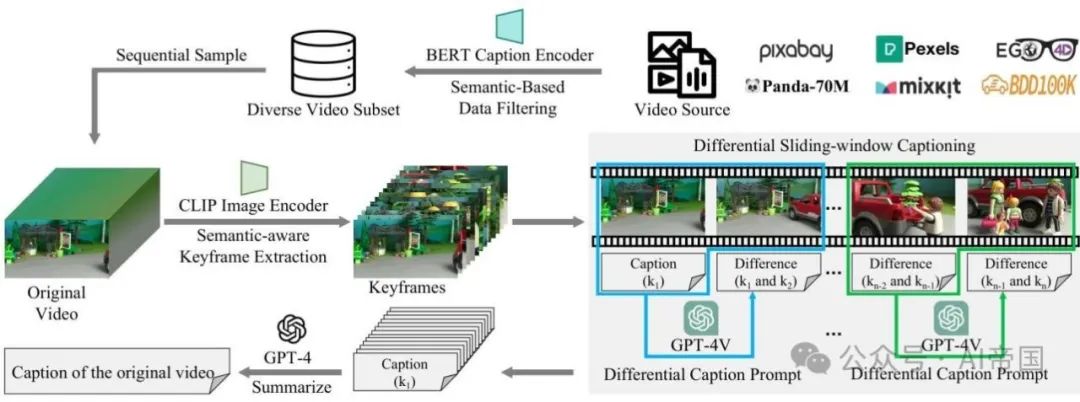

这里详细阐述了如何构建ShareGPT4Video数据集。论文在图2中详细描述了整个过程。

图2:生成高质量视频-标题数据的流程。论文首先根据美学质量和内容复杂性选择多样化的视频来源。接下来,论文使用基于语义的数据过滤来防止内容同质化。然后,论文应用语义感知的帧提取进行稀疏采样,保持显著的语义变化。最后,论文实施差异滑动窗口标题生成策略,利用GPT-4V生成详细且时间上丰富的标题

2.2.1 数据收集

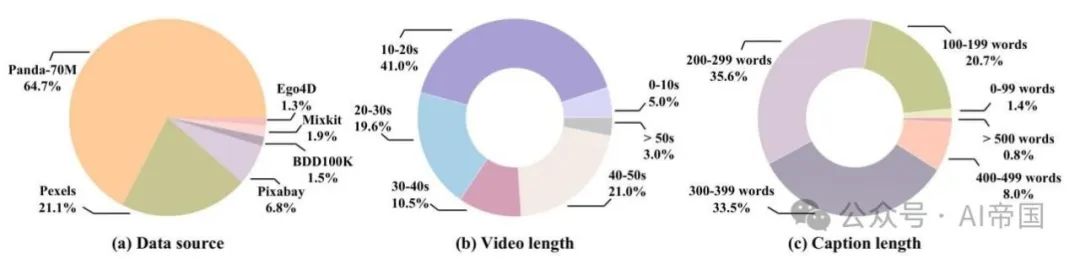

数据源选择。为了服务于视频理解和视频生成任务,论文在收集过程中考虑视频的美学质量和内容复杂性:

•论文首先考虑Panda-70M,这是一个从YouTube获取的高分辨率视频数据集,包含时长约一分钟的片段。这个开放领域来源覆盖了野生动物、烹饪、体育、新闻与电视节目、游戏与3D渲染等多样领域。它通常包含复杂的内容和过渡,为理解各种现实世界场景提供了坚实基础。

•然而,这些内容和过渡的复杂性对视频生成领域提出了重大挑战。为了解决这一问题,论文还从一些用户上传视频网站获取了大量美学上吸引人的视频。这些视频主要由风景和美学上令人愉悦的人类活动组成,涉及较少的过渡和更简单的事件。

•最后,论文通过选择来自Ego4D 和BDD100K 的视频来补充论文的收集,填补自我中心人类活动和自动驾驶场景中的空白,确保论文的视频来源尽可能多地涵盖现实世界场景。

基于语义的数据过滤。尽管论文的字幕生成方法能够支持较长时间的视频,但由于视频时长与数量之间的权衡,论文的收集主要集中在短于两分钟的视频上。

•论文首先从选定的数据源中过滤掉超过两分钟的视频,将两分钟内的视频作为候选。随后,论文引入了一种基于语义的数据过滤策略,以减少这些候选视频之间的内容同质性,并保持最终视频数据集的多样性。该方法旨在从候选视频池中选择具有显著主题差异的视频,以构成论文的最终视频集合。

•具体而言,论文首先使用Panda-Student 模型为每个候选视频生成一个简短的单句字幕,然后维护一个最终的视频候选池。论文提供了伪代码,如图14所示。

2.2.2 视频处理

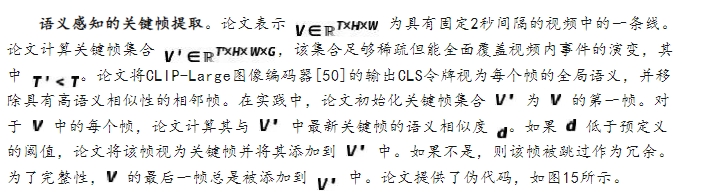

论文开发了一种语义感知的关键帧提取方法,该方法在减少时间冗余和保持语义连贯性之间取得了平衡。

图3:综合视频-标题数据集:(a) 该数据集涵盖了广泛的内容,包括野生动物、烹饪、体育、风景、以自我为中心的人类活动、自动驾驶场景等。(b) 数据集中的视频长度从2秒到2分钟不等。(c) 标题主要在200到400字之间,提供了丰富的时序信息,很好地服务于视频理解和生成任务 。

2.2.3标题生成流程

文发现如果直接将所有帧输入GPT4V,GPT4V难以稳定生成具有正确时序关系的标题,并且随着帧数的增加,其性能进一步恶化。另一方面,如果论文将所有帧合并成一张大图,随着帧数的增加,GPT4V会丢失更多细节,如图11-12所示。

差异滑动窗口字幕生成。为此,论文开发了一种差异滑动窗口字幕生成流程,用于为各种视频生成高质量的字幕,并附带详细的时序描述。具体而言,每次输入到图像多模态模型的内容包括当前关键帧及其与前一关键帧的差异字幕。接着,论文引入了差异提示,引导GPT4V关注当前帧与前一帧之间的变化,如姿态、位置、摄像机角度等。此外,将前一帧的差异字幕作为补充上下文融入,提高了响应质量并减少了幻觉现象。这是因为图像嵌入和文本字幕分别提供了图像的显式和隐式表示。差异字幕不仅增加了额外的上下文,还整合了来自两帧之前的时序信息,进一步增强了模型的时序理解能力。最后,论文将所有差异字幕及其相应的时戳输入到GPT4中。设计了一个特定的总结提示,指导大型语言模型生成具有精确时序动态和详细空间信息的高质量视频字幕。在实践中,论文使用GPT-4-Turbo-04-09进行所有标注。

2.3 ShareCaptioner-Video

2.3.1 模型设计

论文使用收集的视频字幕数据对IXC2-4KHD 进行微调,从而得到论文的ShareCaptioner-Video。为了灵活使用,论文对数据进行了重新组织,以支持以下功能:

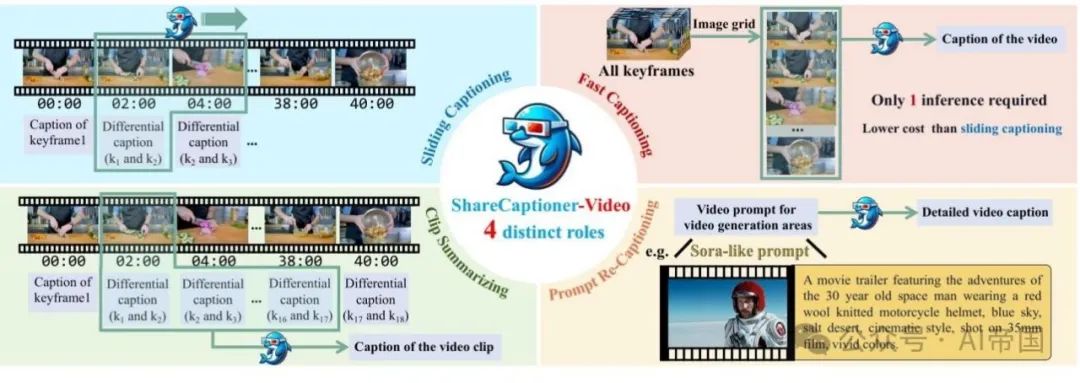

图 4:ShareCaptioner-Video 是一个具有以下功能的四合一出色视频字幕模型:快速字幕生成、滑动字幕、剪辑总结以及提示重新字幕

1.快速字幕生成:该模型采用图像网格格式进行直接视频字幕生成,提供了适用于短视频的快速生成速度。在实践中,论文将视频的所有关键帧连接成一个垂直拉长的图像,并在字幕任务上对模型进行训练。

2.滑动字幕:该模型支持以差分滑动窗口格式进行流式字幕生成,生成适用于长视频的高质量字幕。与第2.3节中使用的字幕流程类似,论文将前一个差分字幕旁边的两个相邻关键帧作为输入,并训练模型描述它们之间发生的事件。

3.剪辑总结:该模型可以快速总结来自ShareGPT4Video或经历了差分滑动窗口字幕生成过程的视频的任何剪辑,无需重新处理帧。论文将所有差分描述作为输入,输出为视频字幕。

4.提示重新字幕:该模型可以重新表达用户输入的提示,这些用户偏好特定的视频生成区域,确保基于高质量视频字幕数据训练的T2VM在推理过程中与其训练中保持格式对齐。在实践中,论文使用GPT-4生成Sora风格的提示用于论文的密集字幕,并以相反的方式训练重新字幕任务,即使用生成的提示作为输入,密集字幕作为训练目标。

2.3.2 字幕生成规模化

为了验证论文的ShareCaptioner-Video在视频字幕生成任务中的有效性,并进一步支持视频生成领域的发展,论文利用它对大量审美吸引人的视频进行了注释。

2.4实验

2.4.1 视频理解

数据集和基准。为了全面探索论文高质量视频字幕数据给LVLMs带来的益处,论文在三个多模态视频基准上对模型进行了全面评估。VideoBench从13个现有数据源(如MSVD-QA,MSRVTT-QA,Activitynet-QA等)中策划了约15,000个跨10个评估维度的QA对。MVBench 旨在挑战LVLMs处理视频任务,这些任务不能通过单帧依赖有效解决,其包含了从11个公共视频测试中派生出的4,000个QA对基准。TempCompass 特别评估了LVLMs在各种时间方面的微妙性能,如速度、方向和属性变化。它包含410个视频和7,540个精心收集的指令,强调时间理解和交互。

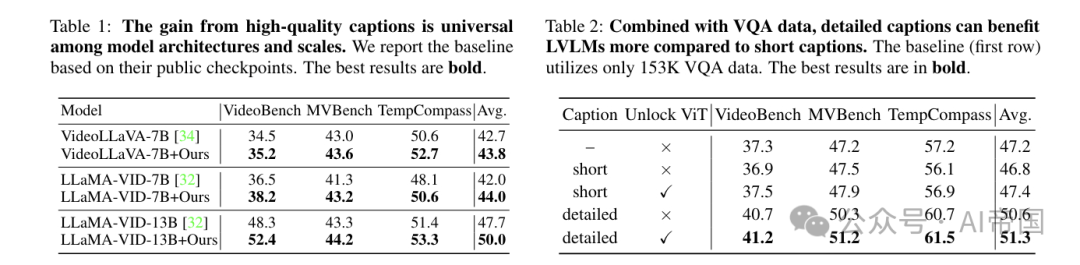

通过ShareGPT4Video提升当前LVLM的性能。论文验证了ShareGPT4Video收集的高质量视频字幕数据对于提升当前LVLM性能的有效性。为了公平和简化,论文将ShareGPT4Video中与复杂场景相关的28K高质量视频字幕数据(包括Panda-70M 、Ego4D [18]和BDD100K )整合,以同等数量替换VideoChatGPT-100K 对话数据中的字幕数据。然后,论文使用默认的训练设置和超参数训练VideoLLaVA 和LLaMA-VID。如表1所示,ShareGPT4Video在不同的LVLM架构和规模上持续提高了视频与语言模态之间的对齐。具体而言,集成高质量字幕后,VideoLLaVA-7B在三个全面的多模态视频基准测试上平均性能提升了1.1,而LLaMA-VID-7B和LLaMA-VID-13B分别实现了平均2.0和2.3的提升。论文高质量的视频字幕数据特别有助于LVLM在需要复杂时间理解的基准测试上实现显著的性能提升,例如TempCompass 。

ShareGPT4Video-8B。为了获得最终的ShareGPT4Video-8B模型,论文从LLaVA-Next-8B [26]图像多模态模型开始。与之前的LVLM方法一致,论文遵循lG-VLM策略,从每个视频中均匀采样16帧,并将这些帧排列成4x4的图像网格,以形成训练和推理的输入。对于训练数据,论文首先从各种教学视频到文本数据集中收集153K的VQA数据来构建论文的基准。这一收集包括来自VideoChatGPT的13K对话数据和140K问答对,其中45K数据点来自CLEVRER ,8K来自EGO-QA ,34K来自NextQA ,53K来自TGIF-Transition 。然后,这些VQA数据与28K视频字幕数据结合,形成一个包含181K样本的综合训练数据集。

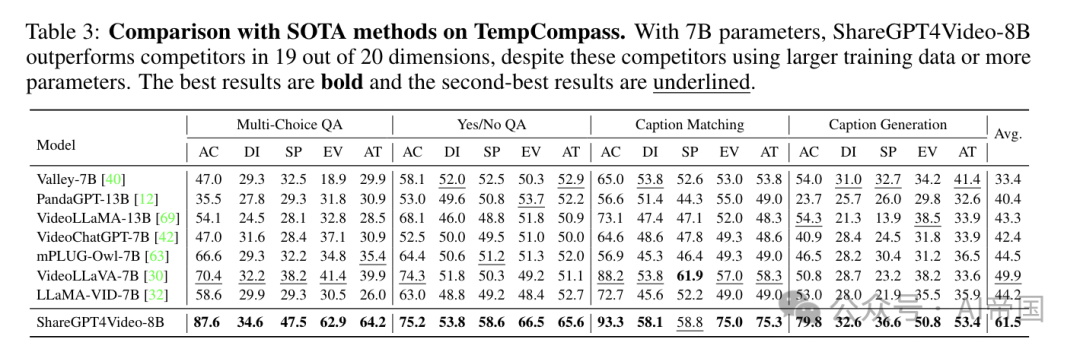

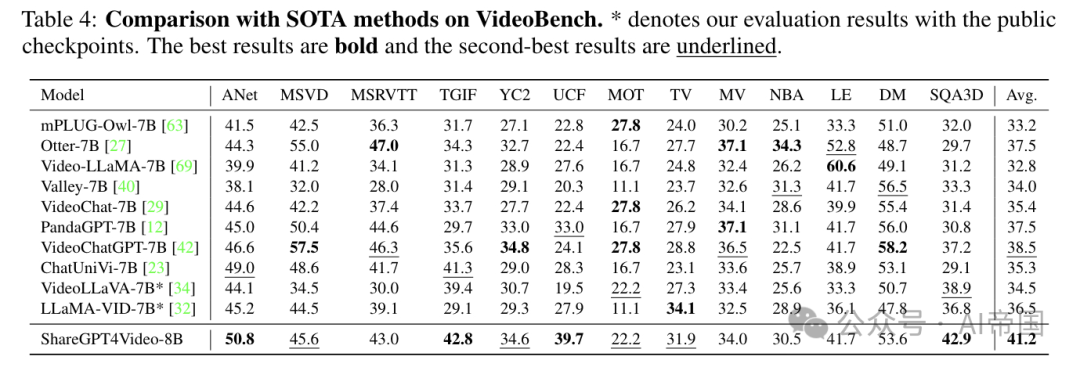

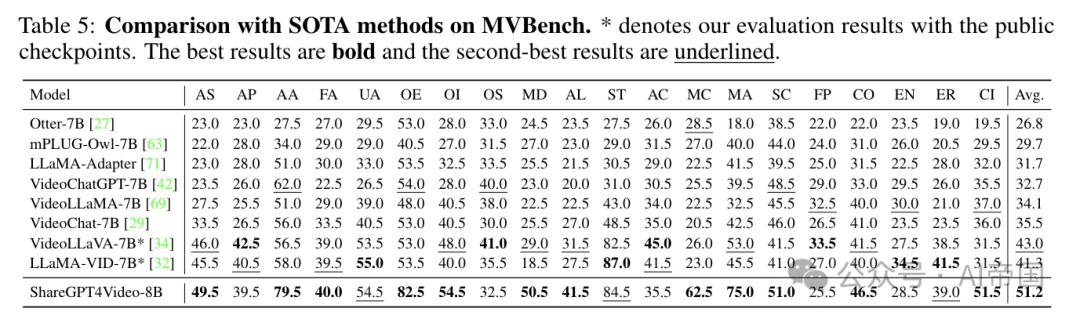

如表3、4、5所示,论文展示了论文的ShareGPT4Video-8B模型(由论文的ShareGPT4Video数据集增强)与现有最先进的LVLMs之间的定量比较。值得注意的是,与之前的LVLMs相比,论文的ShareGPT4Video-8B在所有三个综合基准测试中均取得了最优性能。具体而言,得益于ShareGPT4Video提供的丰富时间信息,论文的ShareGPT4Video-8B模型在TempCompass基准上实现了令人印象深刻的平均准确率61.59%。这比之前表现最佳的LVLM,VideoLLaVA-7B提高了11.6%。此外,尽管VideoBench和MVBench基准从各种现有视频数据集中收集了多样化的QA数据,论文在这两个基准上均取得了稳健的性能,平均准确率分别超过之前的最先进水平2.7%和8.2%。

关于标题质量和ViT的消融研究。基于ShareGPT4Video-8B,论文研究了标题质量和可学习的视觉编码器如何影响模态对齐。如表2所示,在VQA数据之上引入简短的标题可能不会带来显著的性能提升。由于模态对齐不佳,它甚至可能在某些基准上降低性能。比较表2中的第一、第二和第四行,得益于论文高质量标题数据理解时间序列所带来的显著性能提升是显而易见的。此外,在训练时使用详细标题解锁视觉编码器有助于更好地实现LVLMs的模态对齐。

2.4.2 视频字幕生成

为了验证ShareCapitoner-Video的能力,论文通过人类偏好投票定量比较了ShareCapitoner-Video与GPT4V之间的视频字幕质量。如表7显示,其性能与GPT4V相当。图9中还展示了定性结果。更多详情,请参阅附录A.4节。

表3:与TempCompass上的SOTA方法进行比较。尽管竞争对手使用了更大的训练数据或更多的参数,但拥有70亿参数的ShareGPT4Video-8B在20个维度中的19个维度上超越了竞争对手。最佳结果以粗体显示,次佳结果以下划线标出

表 4:在 VideoBench 上与 SOTA 方法的比较。 表示论文使用公开检查点进行评估的结果。最佳结果以粗体显示,次佳结果以下划线显示

表 5:与MVBench上的SOTA方法的比较。表示论文使用公共检查点的评估结果。最佳结果加粗,次佳结果下划线*

2.4.3 视频生成

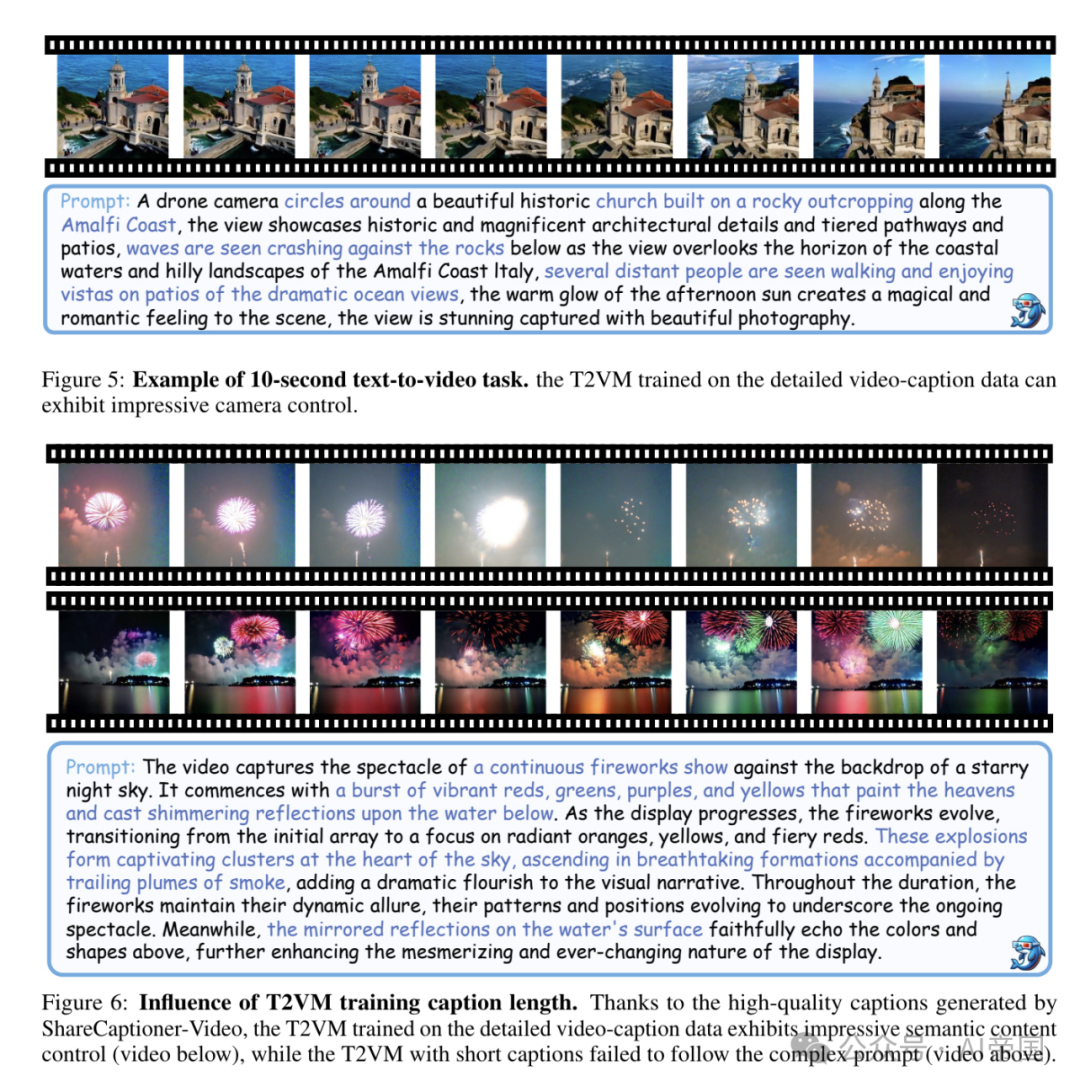

模型设置。为了验证高质量字幕在T2VMs领域的有效性,论文使用ShareCaptioner-Video和Panda-Student 分别为450万个65帧视频和30万个221帧视频生成高质量且简短的视频字幕。遵循Open-Sora-Plan [25]中概述的流程,论文对预训练的T2VM进行了微调,以生成高保真度10秒视频。作为比较,论文对具有相同数量视频-简短字幕对的基线模型进行了微调。

定性分析。如图5所示,T2VM在ShareCaptioner-Video生成的高质量详细字幕辅助下,能够准确遵循详细提示,并在语义内容和相机运动控制方面表现出卓越的控制能力。生成的视频展示了复杂而生动的画面。相比之下,当提供简短字幕时,T2VM难以遵循复杂的生成提示,导致结果不佳。

论文标题:ShareGPT4Video: Improving Video Understanding and Generation with Better Captions

论文链接:https://arxiv.org/pdf/2406.04325

论文项目地址:https://sharegpt4video.github.io/

本文转载自 AI帝国,作者: 无影寺