ACL 2024 | 让纯LLM实现类人的符号逻辑推理能力,开源框架SymbCoT来了

徐俊东,本文第一作者。本科毕业于伦敦大学学院(UCL),硕士就读于新加坡国立大学(NUS)计算机系。主要研究方向为大语言模型的推理能力。

个人主页:https://aiden0526.github.io/JundongXu/

不使用外部工具也能让大语言模型(LLMs)实现严谨可信的推理,新国立提出 SymbCoT 推理框架:结合符号化逻辑(Symbolic Logical)表达式与思维链,极大提升推理质量,鲁棒性与可信度。

LLMs 已表现出强大的语义理解能力。但现有的 LLMs 在实行严密的逻辑符号推理方面还存在很大的不足,依然需要依赖不同的思维提示方法与外部的符号推理工具进行逻辑推理。如何能让 LLMs 本身具备强大的符号逻辑推理能力,是目前让 LLMs 变得更强大的重要研究方向。

最近,新加坡国立大学联合加州大学圣芭芭拉分校与奥克兰大学的研究人员共同提出全新的符号逻辑推理框架 SymbCoT(Symbolic Chain-of-Thought),在推理质量,鲁棒性与可信度都要超越现有的方法。该工作已被 ACL 2024 录用。

- 论文:Faithful Logical Reasoning via Symbolic Chain-of-Thought

- 论文地址:https://arxiv.org/pdf/2405.18357.pdf

- 代码地址:https://github.com/Aiden0526/SymbCoT

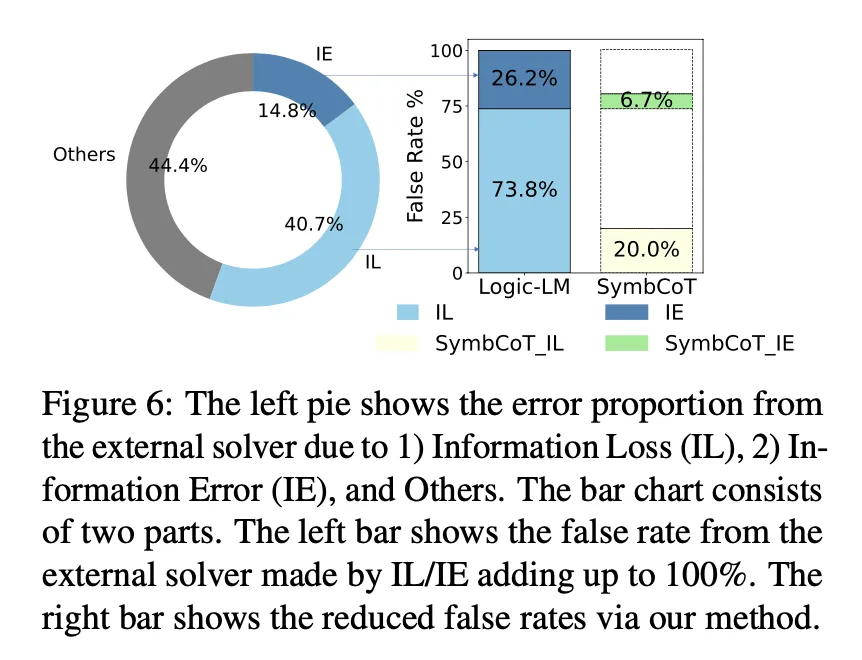

当前有效的逻辑推理方法还存在一些缺陷。比如说 CoT 在严密的逻辑推理过程中经常会产生逻辑谬误。引入外部工具的方法,比如 Logic-LM,使用 LLM 来翻译前提,然后使用外部推理工具如 Prover9 来进行逻辑推导,但这种方法在翻译的过程中容易出现信息损失或翻译错误导致外部推理工具无法执行。

因此,作者提出 SymbCoT,一个既可以引入严密逻辑推理,又能避免翻译造成的信息损失 / 错误导致外部推理工具失效的框架。通过实验证明,SymbCoT 与直接提示,传统 CoT 和使用外部推理工具相比,SymbCoT 分别在三个复杂逻辑推理数据集上提升 22.08%、9.31% 和 7.88%。并且在复杂场景推理、可信度、鲁棒性等方面优于现有方法。

推特知名人工智能博主随后转发了这篇论文,认为这种方法有助于改进高级工作流程,构建更可靠和智能的 LLM AI 代理。该推文仅发布一天,已获得 6w + 浏览量和超过 1200 + 点赞与收藏。

A.SymbCoT 框架介绍

总体来说,SymbCoT 包含四个部分:

1. 翻译:将逻辑推理任务中的前提与结论翻译成对应的符号化表达。

2. 规划:根据结合翻译前后的自然语言与符号化表达,生成符合逻辑推理的计划。

3. 执行:严格按照对应的逻辑推理规则去验证结论的逻辑正确性。

4. 验证:验证翻译与执行是否存在错误。通过对比翻译前后的语义信息,去验证翻译过程中存在的错误并矫正,同时验证执行过程中是否存在不符合逻辑推理规则的步骤。

以下结合具体的使用示例进行介绍。

- 任务定义:

作者提出的 SymbCoT 来解决逻辑推理任务。该任务需要从一系列给定的前提中,判断给定的声明是否正确

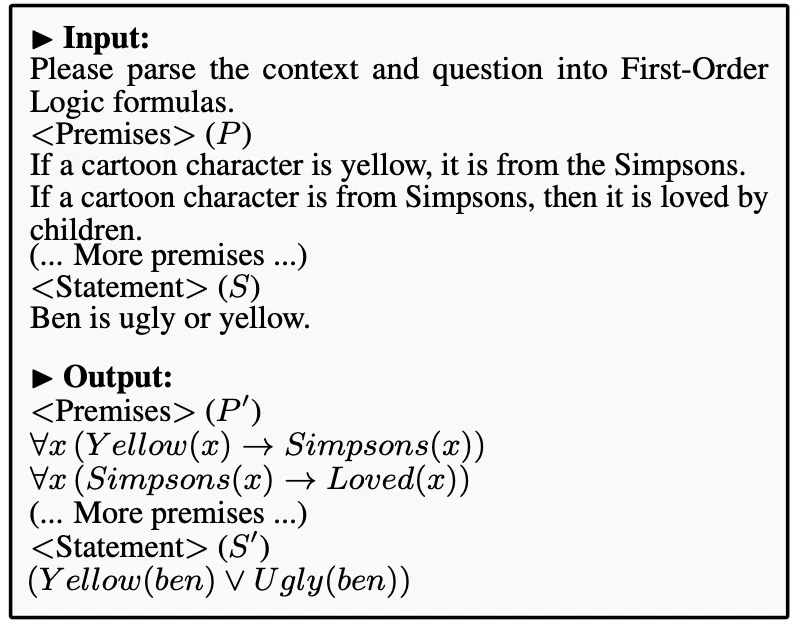

- 翻译:

首先,SymbCoT 中的翻译模块会将给定的前提 P,声明 S,翻译成对应的符号化表达 P' 和 S'

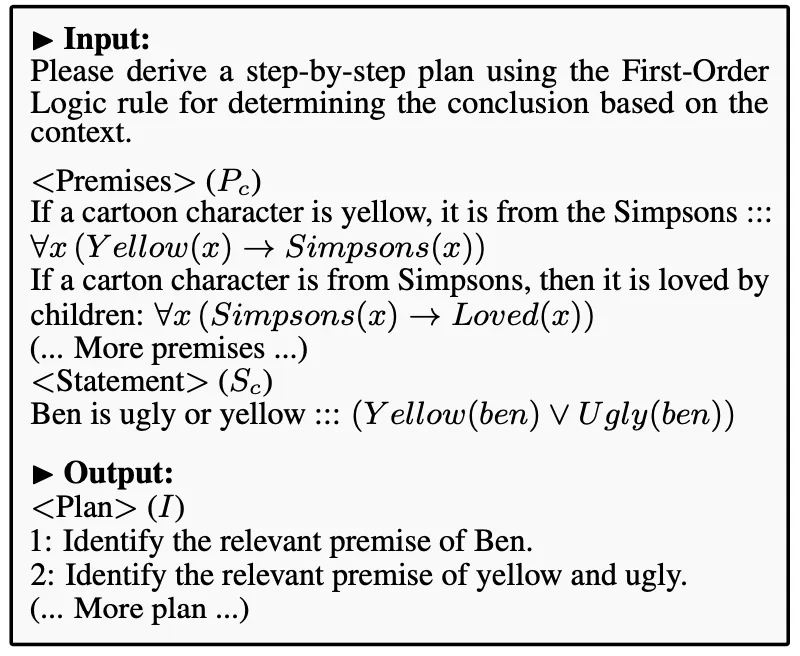

- 规划:

结合翻译前后的自然语言与符号化信息,规划模块会基于相关的逻辑规则去生成一个可执行的逻辑推理计划

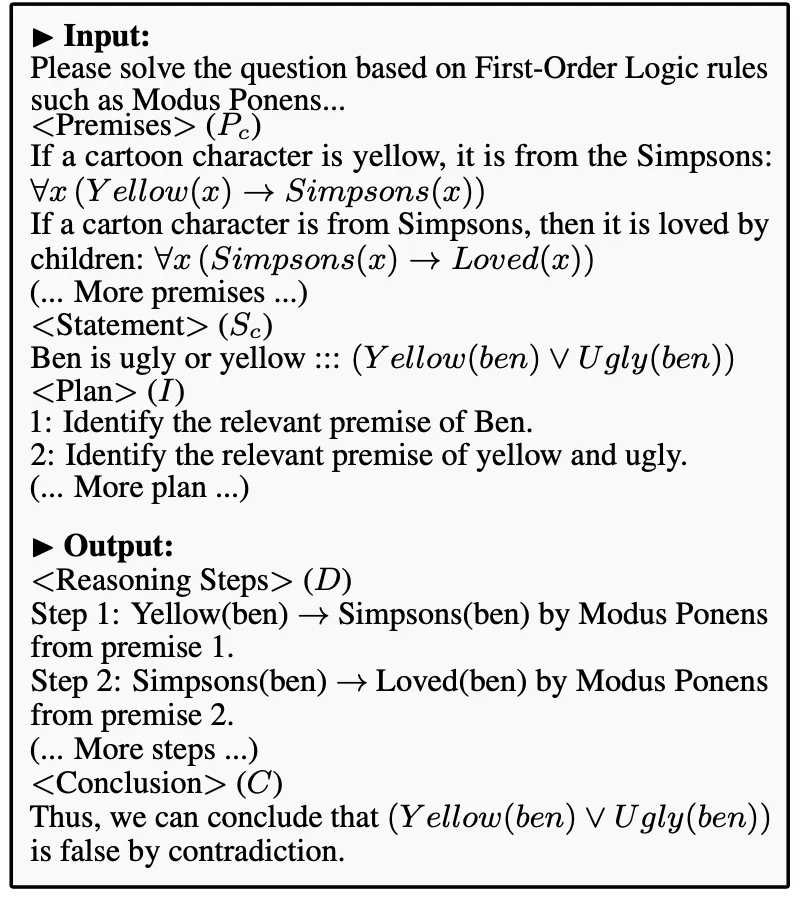

- 执行:

根据翻译前后结合的信息,配合规划模块生成的执行计划,SymbCoT 会严密地遵守逻辑推理规则去执行计划,对声明的正确性得出一个初步结论

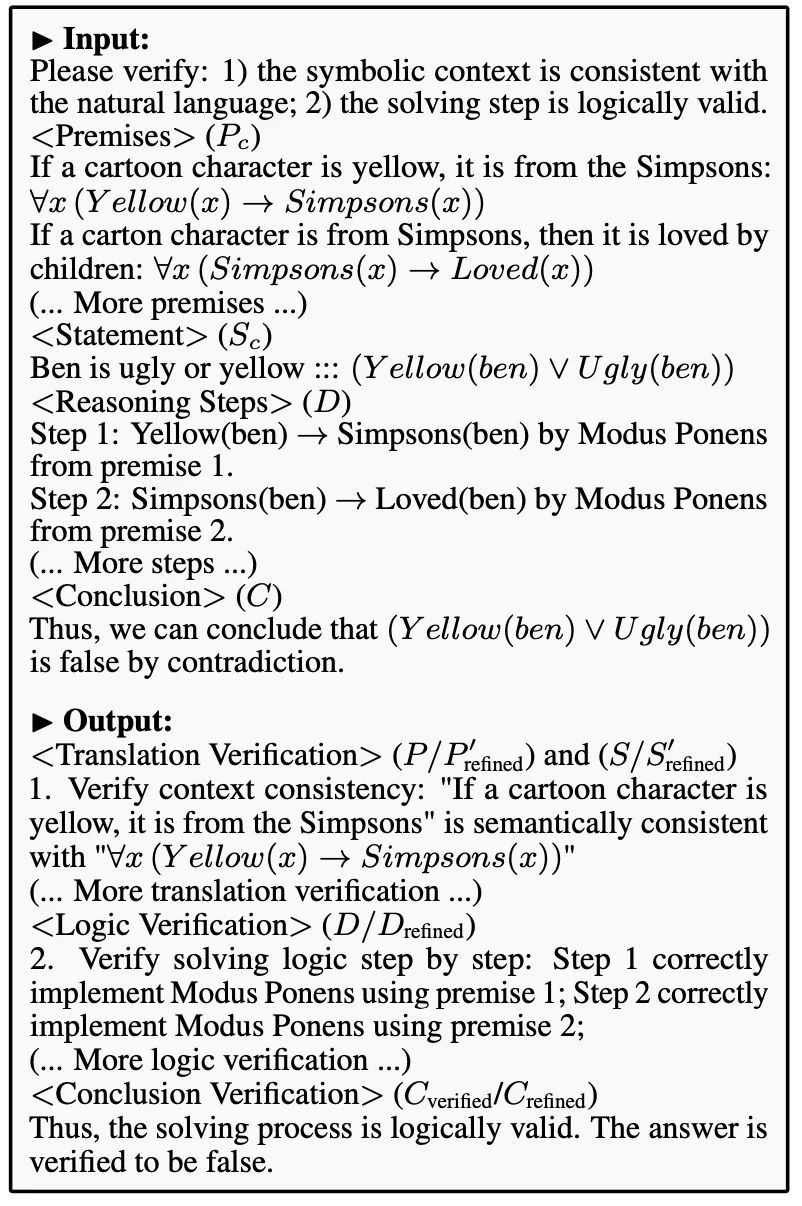

- 验证:

该模块主要有两个功能。第一:通过比对翻译前后的语义信息,验证翻译中是否存在错误;第二:检查执行过程中的每一步是否遵守了严谨的逻辑规则。若任何一个步骤中存在错误,验证模块会更正发现的错误并给出正确的推理步骤与结果

B. 实验结果

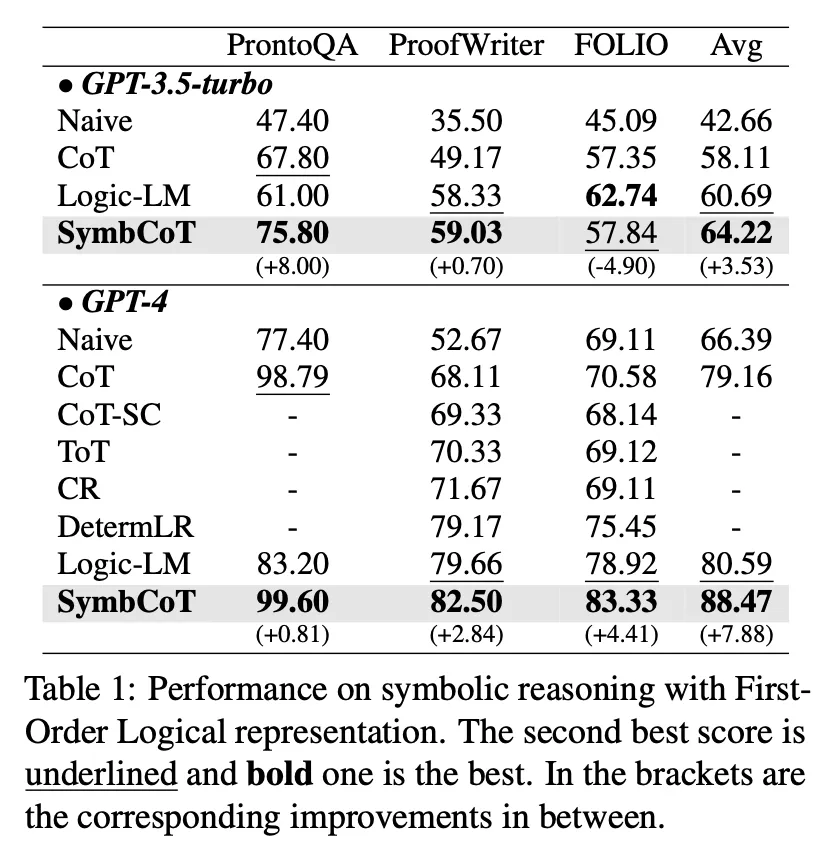

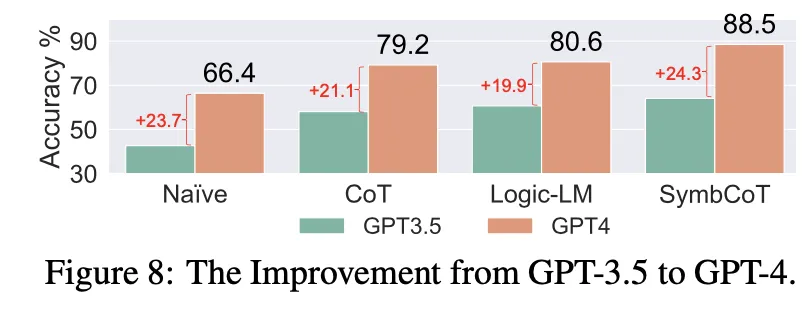

作者首先使用 First-order logic 的规则,在三个逻辑推理数据集上进行了测试。实验证明 SymbCoT 在 GPT3.5-turbo 与 GPT-4 上均能大幅超越传统 CoT 的性能,甚至超越了使用外部工具的框架(Logic-LM)。

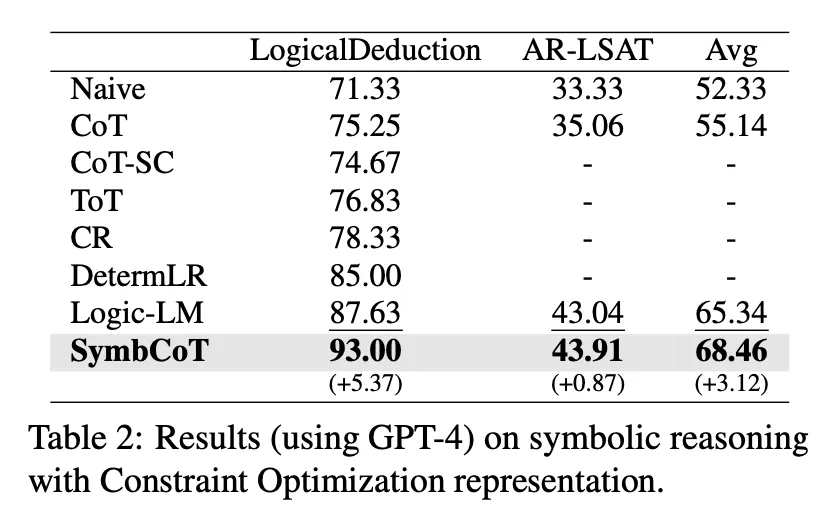

为了验证该框架的普适性,作者随后使用 Constraint Optimization 符号表达的推理规则在另外两个数据集上进行了测试。实验证明使用不同的逻辑规则也能带来更好的性能。

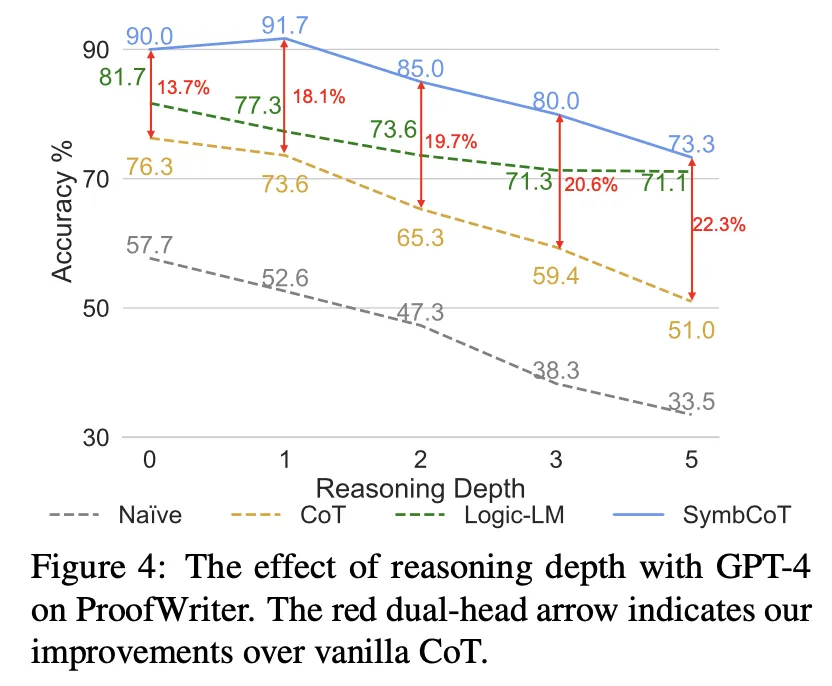

- 复杂推理能力:

作者分析了不同方法在不同推理深度上的表现,发现随着推理深度的增加,SymbCoT 相对于 CoT 的改进变得更加明显,表明 SymbCoT 在处理更复杂问题上的优势。

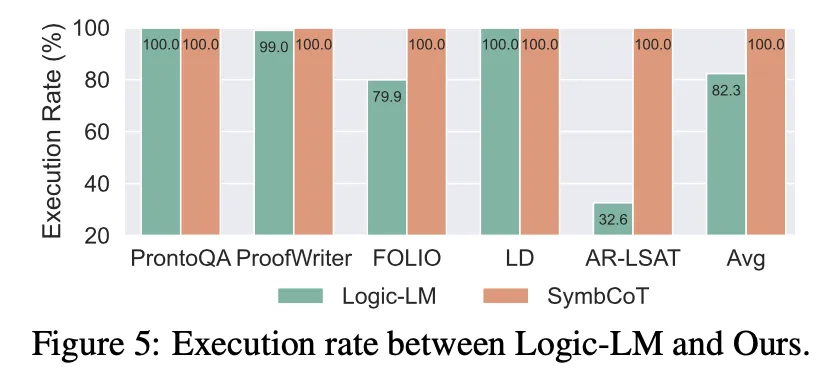

- 鲁棒性:

作者比较了完全基于 LLM 的推理器与依赖外部解析器的方法(如 Logic-LM)在执行符号表达式语法时的成功率,发现 SymbCoT 在语法执行上的成功率显著提高,展示了对语法错误的显著鲁棒性。

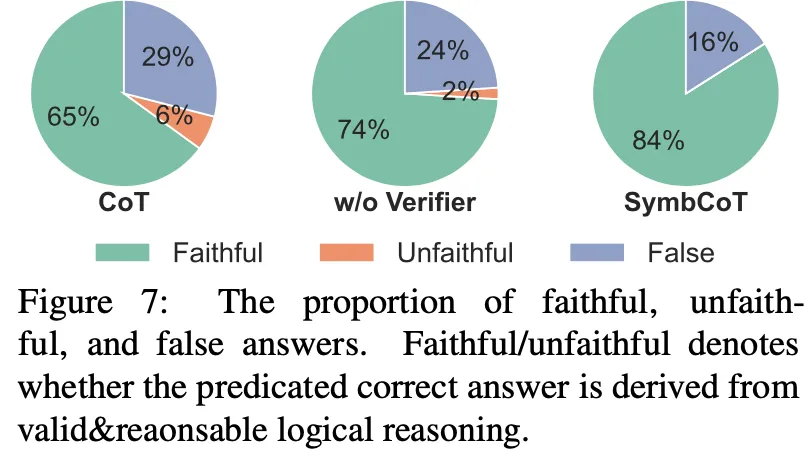

- 可信的逻辑推理:

传统 CoT 在逻辑推理的时候有时候会基于错误的推理过程得到正确的答案,这种情况会误导使用者从而造成不好的后果。SymbCoT 基于严密逻辑推理与验证,有效消除了传统 CoT 中过程不可信的缺陷。

- 符号与自然语言混合表达的优势:

作者分析了 LLM 从自然语言到符号语言的转换过程中可能遗漏的关键信息或引入的不准确性,发现 SymbCoT 通过结合符号和自然语言表达来纠正翻译错误并增强逻辑推理的有效性。

- 不同 LLM 的影响:

作者还比较了 GPT-3.5 和 GPT-4 在三个 FOL 数据集上的表现,发现在升级模型后,SymbCoT 方法的性能提升最为显著,强调了 SymbCoT 方法与更先进模型之间的协同效应。

总体来说,SymbCoT 是一个更准确、更可信且更鲁棒的逻辑推理框架,适合用于要求复杂且精确的逻辑推理任务。

本文转自 机器之心 ,作者:机器之心