OpenAI 和谷歌 DeepMind已风险重重,13位硅谷AI大厂员工联名上信:我们需要对前沿AI发出警告的权利! 原创

出品 | 51CTO技术栈(微信号:blog51cto)

忍无可忍!

面对AI技术发展的各种风险隐患,这些前沿AI企业的一线员工再也不堪忍受任人捂嘴的现状了!

他们想要挣脱保密协议和公司报复的重重风险,获得对公众发出警告的权利。

昨日,13名来自OpenAI和Google DeepMind的现任及前员工上了联名信。内容直指对AGI和人类对齐失败的担忧,他们呼吁“获得权利,去分享OpenAI、 DeepMind及其他前沿公司正在构建的技术可能带来的“严重风险”,并且能获得必要的保护避免因为言论而遭受报复。”

图片

图片

公开信地址:https://righttowarn.ai/

AI圈员工苦捂嘴久矣!

这篇公开信也得到了AI大佬Jan Leike的转发。此前他高调出走OpenAI,并开怼公司风气,表示这几年早已“忽视安全准则,将快速推出“吸引眼球”的产品作为最重要的事情”。

图片

图片

员工对于企业报复的担忧并非空穴来风,出于良心和责任的发声可能代价高昂!此前,Ilya的两位亲密盟友 Leopold Aschenbrenner 和 Pavel Izmailov就曾因“泄密”而被OpenAI解雇。

根据Leopold的自述,所谓的泄密只是他写了一份有关通往AGI之路上所需的准备、安全性及安全措施的头脑风暴文件,并与三位外部研究人员分享了这份文件以获取反馈,并且文件在发出前已经经过严格的脱敏。

不久前,Ilya的离职,让大众再次关注到AI对齐团队和相应的安全问题,OpenAI的“不贬低协议”也让舆论一片哗然。该协议规定,任何员工离职后不可以公开说OpenAI的“坏话”,否则就有丢失天价股权的风险。

但沉默可能给人类带来更加难以预测的危险。正如公开信中所说“只要没有有效的政府监管这些(AI)公司,现任和前员工就是少数能够督促他们对公众负责的人。”

广泛的保密协议犹如一圈圈绳索,困住了这些想要表达担忧的员工。在此情况下,他们可以表达观点的对象似乎只剩下制造这些隐患的公司本身。

因此,这篇联文语气沉重地警告大家,如果没有适当的监管,AI系统有足够的能力造成严重的伤害。信中写道:“这些风险包括从进一步加深现有的不平等,到操纵及伪造信息,到失去对AI系统的控制,甚至可能导致人类灭绝”!

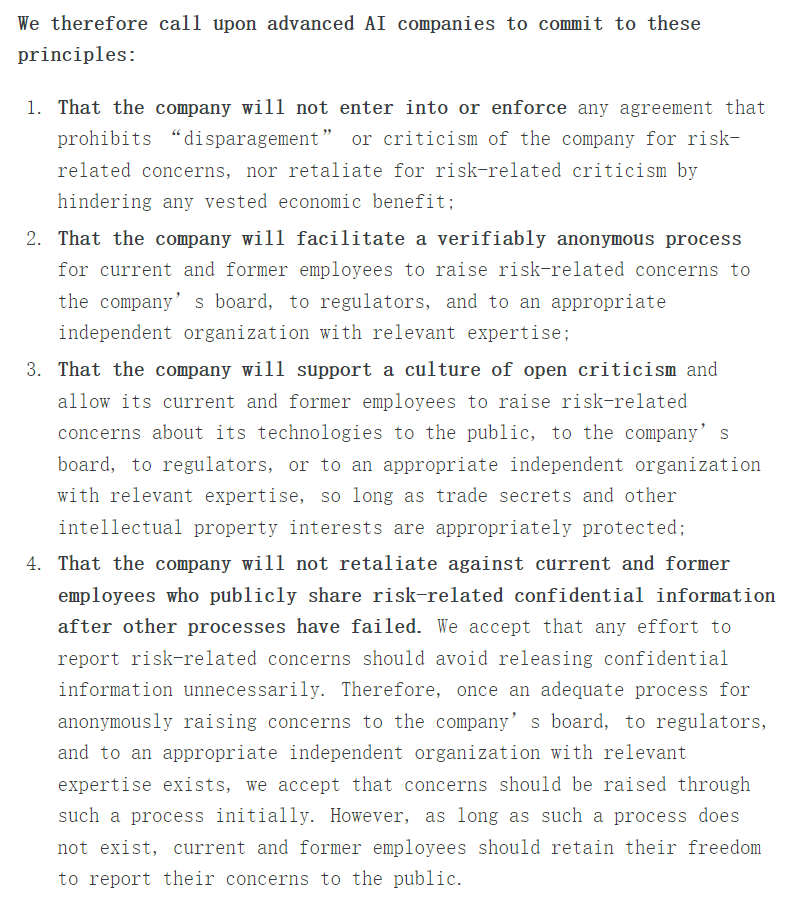

一、公开信:不签协议、匿名发声、支持批评、反对报复

公开信提到,OpenAI等人工智能公司有强烈的财务动机避免有效的监督,仅凭这些公司的“自律”分享相关的风险信息几乎是“天方夜谭”。

因此,争取员工的警告权是必要的。他们在信的主体内容中提出了“警告权”的四条原则:

公司不会签订或执行任何禁止因与风险相关的担忧而“诋毁”或批评公司的协议,也不会因与风险相关的批评而报复,阻碍任何既得经济利益;

- 公司将为现任和前员工提供一个可验证的匿名程序,可以向公司董事会、监管机构和具有相关专业知识的相关独立组织提出与风险相关的担忧;

- 公司将支持开放批评的文化,并允许其现任和前员工向公众、公司董事会、监管机构或具有相关专业知识的相关独立组织提出与其技术相关的与风险相关的担忧,只要适当保护公司商业机密和其他知识产权利益;

- 公司不会报复那些现任和前员工,当其他发声渠道失灵时,他们应该被允许公开分享与风险相关的机密信息。我们同意,公开表达对AI风险的担忧时应该避免发布不必要的机密信息。因此,一旦存在一个适当的程序,允许匿名向公司董事会、监管机构和具有相关专业知识的相关独立组织提出担忧,我们接受应该通过这样的程序匿名提出担忧。然而,只要这样的程序不存在,现任和前员工应该保留向公众报告他们担忧的自由。

图片

图片

OpenAI在给媒体的回应中表示,公司为其“提供最有能力和最安全的AI系统并相信我们科学的方法来处理风险”的记录感到自豪。发言人补充说:“我们同意,鉴于这项技术的重要性,进行严格的辩论至关重要,我们将继续与政府、民间社会和世界各地的其他社区进行交流。”

二、13人联名“上书”,7人实名警告

为“A Right to Warn about Advanced Artificial Intelligence”联名写信的13名员工中,有11位来自OpenAI,其中有7位前员工和4位现任员工。其他两位为谷歌DeepMind的现员工和前员工各一人。

在13中,共有7位勇士实名写信,他们对AI安全的责任感和对公众福祉的追求让人动容。

1.Jacob Hilton,formerly OpenAI

Jacob Hilton是OpenAI的前研究员,他曾承担了各种强化学习相关课题的研究,例如语言模型(ChatGPT、WebGPT 和 TruthfulQA)的真实性、RL 的缩放规律和过度优化等项目。

周二签署这封信后,他在X上分享了自己的经历,一年多前,当他离开OpenAI时,他就曾签署过那份臭名昭著的“非贬损协议”。当时,为了自身的利益,他签署了这一规定,并按照要求对协议本身保密。

图片

图片

他肯定了奥特曼将该协议取消的规定,但他提到“员工可能仍然担心披露的其他形式的报复,例如被解雇并因损害而被起诉。”

图片

图片

离开OpenAI后,他加入了对齐研究中心(ARC),继续关注AI安全工作。对齐研究中心是一家非营利性研究机构,其使命是使未来的机器学习系统与人类利益相一致。

2.Daniel Kokotajlo,formerly OpenAI

Daniel Kokotajlo是 OpenAI 的前工程师。和其他人不同,Daniel是一位哲学博士,加入OpenAI之前曾在AI Impacts,以及Center on Long-Term Risk(长期风险中心)工作。这就不难理解他所持有的立场。

长期以来,Daniel对压制研究人员的声音以及开发 AGI 的潜在风险表示担忧。因此,他冒着在 60 天内失去既得股权的风险,毅然决然地拒绝了在非贬损条款上签字。

图片

图片

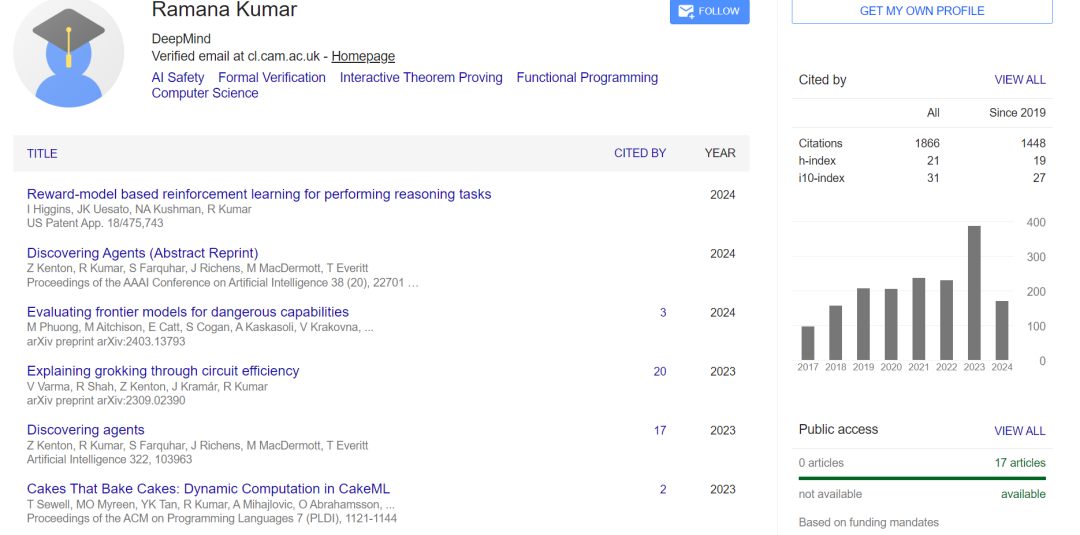

3.Ramana Kumar,formerly Google DeepMind

拉马纳-库马尔(Ramana Kumar)是一名高级研究员,曾在谷歌 DeepMind 工作。他因在人工智能安全、形式验证和交互式定理证明方面的贡献而闻名。

今年3月,他刚发表了名为《评估前沿模型的危险能力》的论文。

图片

图片

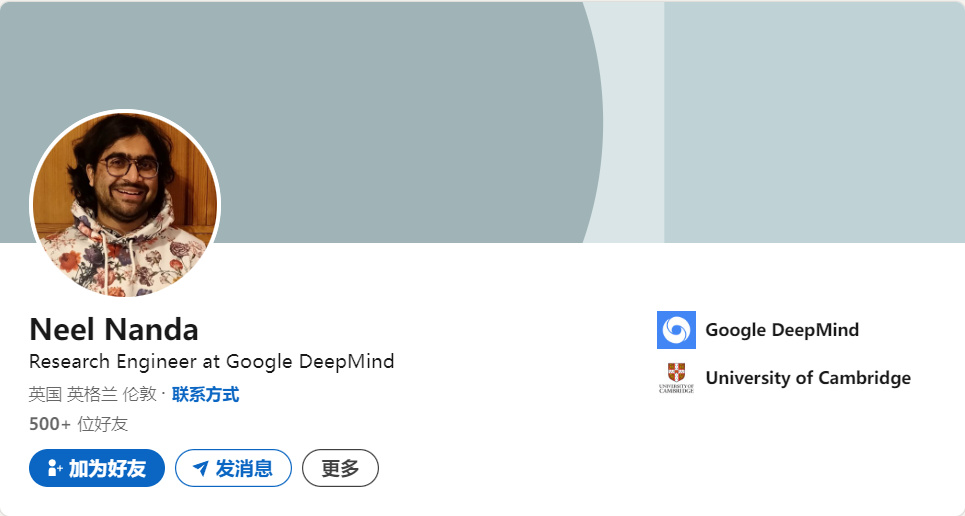

4.Neel Nanda,currently Google DeepMind, formerly Anthropic

尼尔-南达(Neel Nanda)是实名上信的唯一一位在职员工,目前是伦敦谷歌 DeepMind 的研究工程师,在机制可解释性团队工作。在此之前,他拥有多段学术研究经历,他曾作为技术人员在克里斯-奥拉(Chris Olah)领导下研究语言模型的可解释性。

图片

图片

5.William Saunders,formerly OpenAI

威廉-桑德斯(William Saunders)是 OpenAI 的前安全研究员,也是超级对齐团队的元老级人物,于 2024 年 2 月辞职。

他加入2021年加入Alignment 团队时,该团队还没被命名为“超级对齐”。根据他的领英主页,William主要从事可扩展的监督工作,是开发批评技术的团队成员之一,该技术用于使用语言模型发现其他语言模型中的错误。

之后,他被提升为管理一个 4 人团队的负责人,该团队致力于理解语言模型在上下文中的特征,最终发布了开源的 "transformer 调试器 "工具。

图片

图片

6.Carroll Wainwright,formerly OpenAI

Carroll在OpenAI工作了近三年之久。

从领英主页发现,他一直有份“副业”,即 Metaculus 公司的联合创始人。该公司是一个以公共利益为导向的组织,提供一个预测技术,它能以最佳方式汇总对未来事件的定量预测,其使命是“建设认识论基础设施,使全球社会能够模拟、理解、预测和驾驭世界上最重要、最复杂的挑战。”

图片

图片

7.Daniel Ziegler,formerly OpenAI

丹尼尔-齐格勒(Daniel Ziegler)是 OpenAI 的前工程师,曾于 2018 年至 2021 年在 OpenAI 工作。离开OpenAI后,Daniel继续进行人工智能对齐的研究工作,领导 Redwood Research 的对抗训练团队。

他也是一位长期关注公共利益的人,在学生期间,我参与创立了麻省理工学院的有效利他主义(Effective Altruism)组织,并在 2017 年毕业前运营了一年。

图片

图片

三、风险重重:2027或实现AGI,但人类还没准备好

在信中参与联名的Daniel Kokotajlo表示,他担心AI公司及整个社会是否准备好了迎接AGI,这是AI的一种假设版本——即AI可以在许多任务上超越人类。Kokotajlo表示,他认为到2027年达到AGI的可能性为50%。

Kokotajlo说:“没有什么真正阻止公司构建AGI并将其用于各种事情,而且透明度不高。”他冒着放弃股权的风险,未在不诋毁协议上签字。“我辞职是因为我觉得我们还没有准备好。我们作为一个公司没有准备好,我们作为一个社会对这个问题没有准备好,我们需要真正投入更多的准备和思考其含义。”

这封联名信是否可以作为一个支点,撬动OpenAI这样的庞然大物?

Ilya的盟友、因为“泄密事件”被解雇的Leopold,在前日发出165页的系列长文,以论述AGI 战略图景。

图片

图片

完整PDF地址:https://situational-awareness.ai/wp-content/uploads/2024/06/situationalawareness.pdf

在扉页他非常郑重地写到“献给Ilya”,同时无不谨慎地说“尽管我曾经在OpenAI工作,但所有这些都是基于公开可获得的信息、我自己的想法、一般领域的知识,或者是科幻小说的闲谈。”

图片

图片

在长文中,Leopold提出了一种避免盲目乐观和悲观的“AGI现实主义”,其中有三个原则:

- 超级智能是国家安全问题。我们正在迅速建造比最聪明的人类还要聪明的机器……它将是人类有史以来建造的最强大的武器。

- 美国必须掌握AGI的领导权(编者注:本条为Leopold基于自身立场出发,仅作翻译)。人工智能实验室必须把国家利益放在首位。

- 我们可以不搞砸它。认识到超级智能的力量也意味着认识到它的危险。…… 随着加速的加剧,我只希望讨论变得更加尖锐。但我最大的希望是,那些能感受到AGI即将到来有多么重量的人,能将其视为庄严的职责召唤。

本文转载自51CTO技术栈,作者:伊风